Автор: Денис Аветисян

В статье представлена инновационная методика обнаружения и нейтрализации вредоносных участников в системах федеративного обучения, основанная на отслеживании изменений в динамике потерь.

Читаем отчёты, пьём кофе, ждём дивиденды. Если тебе надоел хайп и ты ищешь скучную, но стабильную гавань — добро пожаловать.

Бесплатный Телеграм канал

Предлагаемая система FL-LTD обеспечивает надежную защиту от атак, манипулирующих функциями потерь, без доступа к данным или градиентам клиентов.

Несмотря на преимущества федеративного обучения в обеспечении конфиденциальности данных, системы подвержены рискам со стороны злонамеренных участников. В данной работе, посвященной ‘Robust Federated Learning for Malicious Clients using Loss Trend Deviation Detection’, предложен новый, легковесный и сохраняющий конфиденциальность механизм защиты, FL-LTD, который обнаруживает и смягчает влияние злонамеренных клиентов путем мониторинга динамики изменения функции потерь во времени. FL-LTD эффективно выявляет аномальное поведение без инспекции градиентов или доступа к данным клиентов, обеспечивая устойчивость и стабильную сходимость. Может ли мониторинг динамики потерь стать ключевым элементом в построении безопасных и надежных систем федеративного обучения?

Уязвимость федеративного обучения: атаки и риски

Несмотря на то, что федеративное обучение (FL) изначально разрабатывалось с целью повышения конфиденциальности данных, оно подвержено атакам со стороны злоумышленников, стремящихся скомпрометировать глобальную модель. В отличие от централизованного обучения, где данные хранятся и обрабатываются на одном сервере, FL предполагает распределенное обучение на множестве клиентских устройств. Это создает новые векторы атак: злоумышленник, контролирующий часть клиентов, может намеренно отправлять искаженные обновления модели, чтобы повлиять на ее производительность или даже внедрить вредоносный код. Уязвимость усиливается тем, что FL часто используется в сценариях, где доверие к клиентам ограничено, например, в мобильных приложениях или системах Интернета вещей. Таким образом, обеспечение надежности и безопасности федеративного обучения требует разработки эффективных механизмов обнаружения и смягчения атак, направленных на компрометацию глобальной модели.

Распределенное обучение, несмотря на свои преимущества в области конфиденциальности, особенно уязвимо, когда данные на различных клиентских устройствах значительно отличаются друг от друга — это явление известно как Non-IID данные. Именно эта неоднородность создает благоприятную почву для целенаправленных атак. Если у каждого клиента уникальный набор данных, отражающий специфические паттерны или особенности, злоумышленник, контролирующий одного или нескольких клиентов, может манипулировать локальными обновлениями модели, чтобы повлиять на глобальную модель таким образом, который будет выгоден только ему. Отсутствие репрезентативности данных у отдельных участников усложняет обнаружение аномалий и повышает эффективность злонамеренных действий, так как искаженные обновления могут быть замаскированы под естественные колебания, вызванные различиями в данных.

Традиционные методы защиты в федеративном обучении часто оказываются неэффективными из-за возможности злоумышленников манипулировать сообщаемыми значениями функции потерь. Атаки, основанные на манипуляции потерями, позволяют намеренно искажать процесс агрегации глобальной модели, вводя в заблуждение сервер относительно реального прогресса обучения. Злоумышленники, контролируя часть клиентов, могут сообщать завышенные или заниженные значения потерь, влияя на веса, присваиваемые их обновлениям модели. Это приводит к тому, что глобальная модель смещается в нежелательном направлении, ухудшая ее производительность или даже вводя в нее вредоносный код. Эффективная защита от таких атак требует разработки новых механизмов, способных обнаруживать и нейтрализовать манипуляции с функцией потерь, обеспечивая надежность и безопасность процесса федеративного обучения.

Робастная агрегация: укрепление защиты

Методы робастной агрегации направлены на снижение влияния искаженных обновлений, поступающих от злонамеренных или неисправных клиентов в распределенных системах машинного обучения. В отличие от стандартного усреднения, которое уязвимо к атакам, где отдельные клиенты отправляют намеренно неверные данные, робастные методы стремятся к вычислению агрегированного обновления, устойчивого к выбросам. Это достигается за счет использования статистических мер, отличных от среднего арифметического, таких как медиана или взвешенные медианы, что позволяет исключить из процесса агрегации обновления, существенно отличающиеся от большинства. Эффективность робастной агрегации напрямую зависит от способности алгоритма корректно идентифицировать и игнорировать аномальные обновления, минимизируя их влияние на глобальную модель.

В отличие от стандартного усреднения, методы агрегации, такие как геометрическое медианное агрегирование и подход минимизации дисперсии, демонстрируют повышенную устойчивость к искаженным обновлениям от недобросовестных или неисправных клиентов. Геометрическое медианное агрегирование вычисляет медиану векторов обновлений, что снижает влияние выбросов. Подход минимизации дисперсии стремится к построению агрегированного обновления с минимальной дисперсией значений, тем самым уменьшая вклад сильно отличающихся обновлений. В то время как стандартное усреднение чувствительно к значениям-выбросам, данные методы позволяют снизить влияние атак, направленных на искажение глобальной модели за счет манипулирования обновлениями отдельных клиентов. Эффективность данных подходов обусловлена тем, что они менее восприимчивы к большим отклонениям в обновлениях, что повышает общую надежность системы.

Эффективная защита в системах федеративного обучения требует не только применения стратегий надежной агрегации, но и внедрения проактивных методов обнаружения злонамеренных клиентов. Просто агрегирование данных, даже с использованием устойчивых к выбросам алгоритмов, не гарантирует безопасности, если вредоносные участники продолжают предоставлять скомпрометированные обновления. Обнаружение злонамеренных клиентов позволяет идентифицировать и изолировать их, предотвращая влияние на глобальную модель. Методы обнаружения включают анализ поведения клиентов, выявление аномалий в обновлениях и использование криптографических техник для проверки целостности данных. Изоляция может включать исключение клиента из процесса обучения или снижение его веса в процессе агрегации. Комбинация надежной агрегации и проактивного обнаружения злонамеренных клиентов обеспечивает более надежную и безопасную систему федеративного обучения.

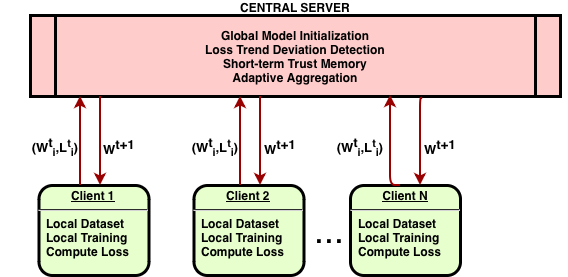

FL-LTD: динамический каркас защиты

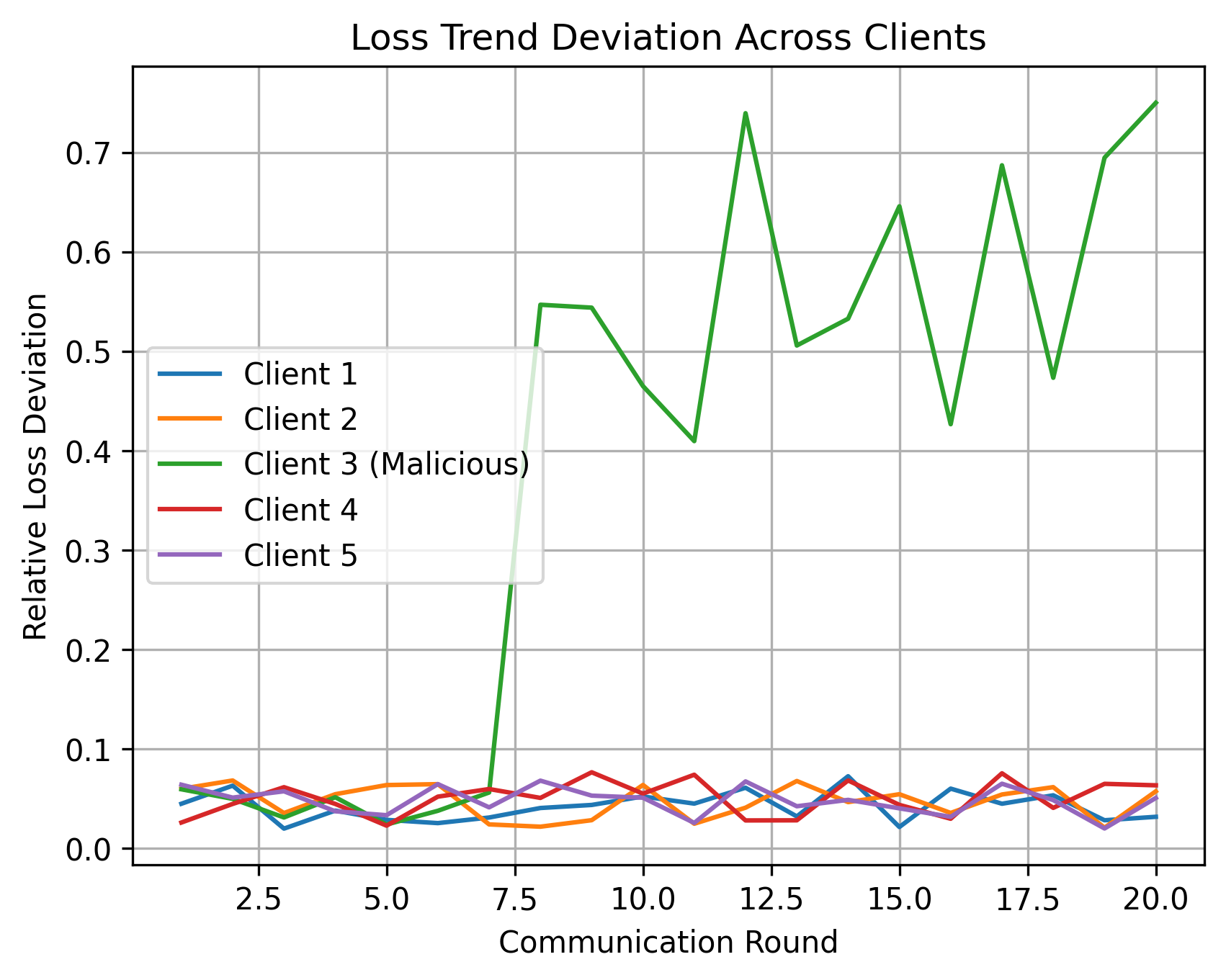

Система FL-LTD представляет собой новый защитный механизм, основанный на анализе отклонений в динамике потерь (Loss Trend Deviation) при обучении на клиентских устройствах. В основе подхода лежит мониторинг изменений значений функции потерь в процессе федеративного обучения. Аномальные тренды потерь, отклоняющиеся от ожидаемого поведения, рассматриваются как потенциальные индикаторы злонамеренной активности со стороны отдельных клиентов. Идентификация таких аномалий позволяет своевременно реагировать на атаки, направленные на компрометацию глобальной модели, и повышает устойчивость системы федеративного обучения к различным типам угроз.

В основе работы FL-LTD лежит мониторинг динамики изменения функции потерь в процессе обучения на клиентских устройствах. Аномальное поведение злоумышленников, даже при попытках замаскировать вредоносное воздействие, проявляется в отклонениях тренда потерь от ожидаемого. Анализируя изменение потерь во времени, FL-LTD способен выявлять клиентов, отправляющих обновления, приводящие к нетипичному увеличению или нестабильности функции потерь, что позволяет идентифицировать атаки, направленные на манипулирование процессом обучения. Данный подход эффективен против атак, при которых злоумышленники стремятся постепенно ухудшить качество модели, имитируя поведение добросовестных участников, поскольку даже незначительные, но устойчивые отклонения в тренде потерь могут быть обнаружены системой.

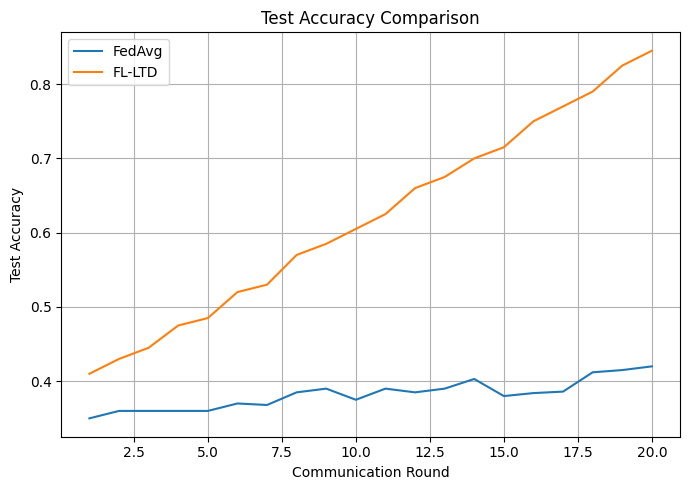

Предлагаемый фреймворк FL-LTD значительно повышает устойчивость федеративного обучения к манипуляциям с потерями. В условиях атак, направленных на искажение потерь при обучении, FL-LTD более чем вдвое увеличивает конечную точность тестирования по сравнению со стандартным алгоритмом FedAvg. Дополнительное использование адаптивной взвешенной редукции (Adaptive Down-weighting) усиливает защиту, снижая влияние обнаруженных злонамеренных клиентов в процессе агрегации, что обеспечивает целостность модели и предотвращает распространение вредоносных обновлений.

Поддержание устойчивости: память и конфиденциальность

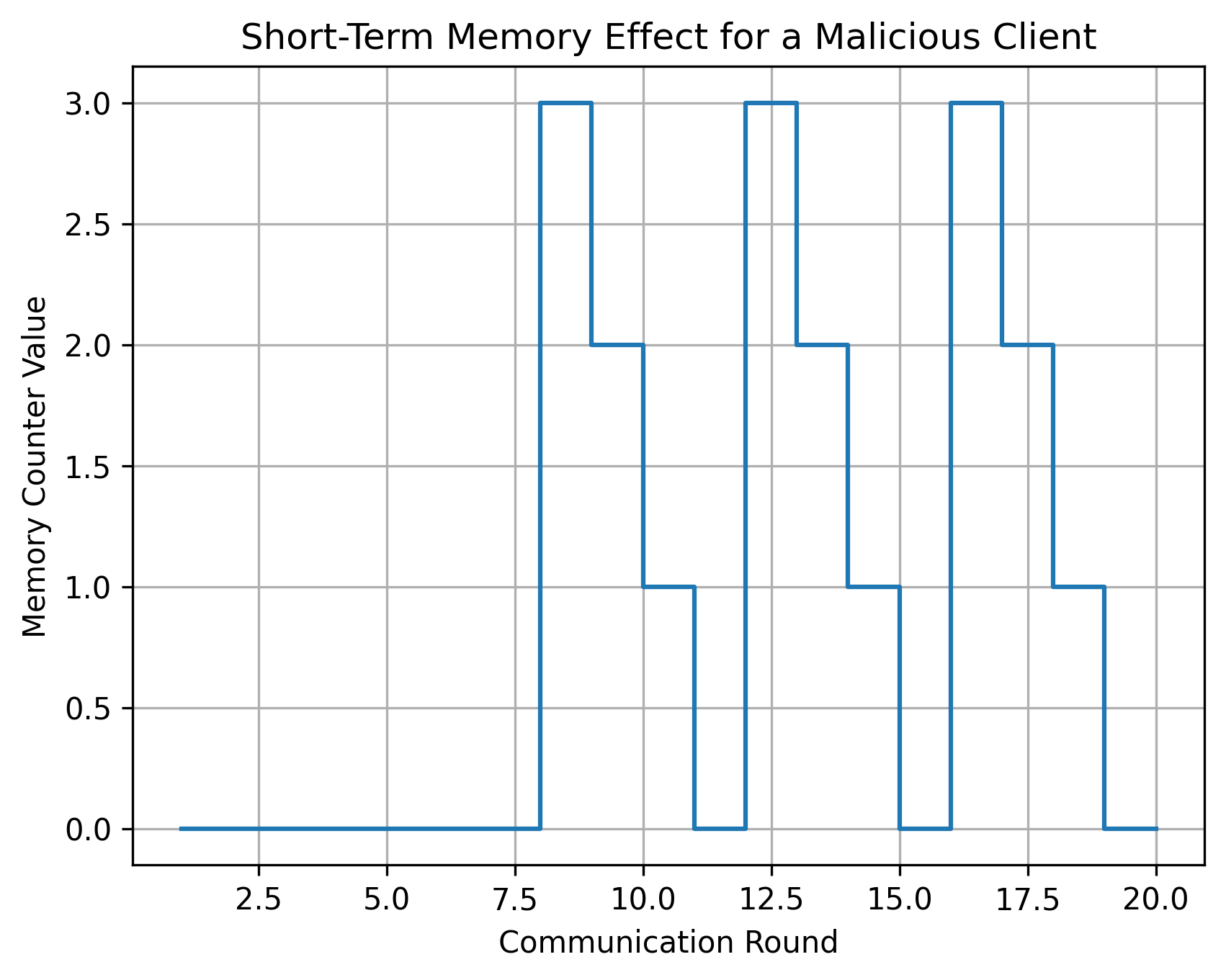

Эффективность системы FL-LTD напрямую зависит от способности сохранять информацию о недавней аномальной активности — принципа, известного как устойчивость доверия на основе памяти. Вместо того чтобы каждый раз анализировать данные «с нуля», система запоминает характерные признаки предыдущих атак и использует эти знания для оперативного выявления и нейтрализации новых угроз. Такой подход позволяет не только значительно сократить время реакции на инциденты, но и повысить точность обнаружения, поскольку система способна распознавать сложные атаки, основанные на повторении или модификации ранее зафиксированных паттернов. По сути, FL-LTD формирует своего рода «иммунитет» к известным угрозам, постоянно адаптируясь к меняющемуся ландшафту кибербезопасности и обеспечивая более надежную защиту данных.

Для обеспечения конфиденциальности при мониторинге угроз, система FL-LTD способна интегрироваться с методами безопасной агрегации данных. Данный подход позволяет анализировать информацию, поступающую от различных клиентов, без раскрытия индивидуальных данных каждого из них. В основе безопасной агрегации лежит использование гомоморфного шифрования, которое обеспечивает возможность проведения вычислений над зашифрованными данными, сохраняя при этом их конфиденциальность. Благодаря этому, система способна выявлять общие признаки аномальной активности, не получая доступ к исходным данным, что является критически важным для защиты приватности пользователей и соблюдения нормативных требований в области обработки персональных данных.

В основе технологии безопасной агрегации лежит гомоморфное шифрование, обеспечивающее конфиденциальность обновлений, поступающих от каждого клиента, в процессе их обобщения. Этот метод позволяет серверу обрабатывать зашифрованные данные, не расшифровывая их, что гарантирует, что индивидуальная информация остается скрытой. Гомоморфное шифрование преобразует данные таким образом, что операции над зашифрованными данными дают зашифрованный результат, эквивалентный результату операций над исходными, незашифрованными данными. Таким образом, сервер может вычислять агрегированные модели, основанные на данных от множества клиентов, не имея доступа к их отдельным вкладам, что существенно повышает уровень конфиденциальности и безопасности в системах федеративного обучения.

Исследование, представленное в данной работе, демонстрирует стремление к глубокому пониманию систем, что находит отражение в предложенном методе FL-LTD. Этот подход, основанный на мониторинге динамики потерь, позволяет выявлять злонамеренных клиентов, не прибегая к анализу градиентов или доступу к данным пользователей. Как однажды заметил Г.Х. Харди: «Математика — это наука о том, что можно логически доказать, а не о том, что можно доказать эмпирически». В контексте федеративного обучения, FL-LTD, подобно математической строгости, стремится к надежному обнаружению аномалий, опираясь на логический анализ временных рядов потерь, а не на вероятностные оценки или эвристики. Такая дедуктивная логика позволяет создать устойчивую систему, способную противостоять манипуляциям и обеспечивать надежность обучения.

Куда же дальше?

Предложенный подход, отслеживающий динамику потерь для выявления злонамеренных участников в федеративном обучении, безусловно, вносит свой вклад в расширение границ возможного. Однако, подобно любой системе обнаружения аномалий, FL-LTD опирается на предположение о «нормальном» поведении. Что произойдет, если злоумышленники научатся имитировать эту самую «нормальность», создавая едва заметные искажения в динамике потерь? Похоже, гонка вооружений в мире распределенного обучения только набирает обороты.

Очевидным направлением дальнейших исследований является адаптация метода к более сложным сценариям атак, когда злоумышленники действуют не единолично, а координированно, создавая иллюзию стабильности системы. Не менее интересна возможность интеграции FL-LTD с другими механизмами защиты, такими как дифференциальная приватность или робастные алгоритмы агрегации. Возможно, истинная устойчивость достигается не за счет поиска «идеальной» защиты, а за счет создания многоуровневой системы, способной выдержать самые изощренные атаки.

В конечном итоге, задача не в том, чтобы полностью исключить возможность манипулирования системой, а в том, чтобы сделать стоимость этих манипуляций непомерно высокой. Ведь даже самая совершенная защита бессильна перед лицом изобретательности и настойчивости атакующего. И, как всегда, вопрос сводится к балансу между безопасностью, производительностью и конфиденциальностью — вечной дилемме, заставляющей нас постоянно пересматривать фундаментальные принципы распределенного обучения.

Оригинал статьи: https://arxiv.org/pdf/2601.20915.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- ПРОГНОЗ ДОЛЛАРА К ШЕКЕЛЮ

- БИТКОИН ПРОГНОЗ. BTC криптовалюта

- SOL ПРОГНОЗ. SOL криптовалюта

- ЭФИРИУМ ПРОГНОЗ. ETH криптовалюта

- SAROS ПРОГНОЗ. SAROS криптовалюта

- ПРОГНОЗ ДОЛЛАРА К ЗЛОТОМУ

- AXS ПРОГНОЗ. AXS криптовалюта

- FARTCOIN ПРОГНОЗ. FARTCOIN криптовалюта

- РИППЛ ПРОГНОЗ. XRP криптовалюта

- ДОГЕКОИН ПРОГНОЗ. DOGE криптовалюта

2026-01-31 07:23