Автор: Денис Аветисян

Новый подход позволяет создавать эффективных веб-агентов, способных быстро и точно выполнять задачи в интернете.

Представлена система WebClipper, использующая графовый анализ траекторий для оптимизации баланса между точностью и эффективностью работы веб-агентов.

Несмотря на значительный потенциал веб-агентов в решении сложных задач по поиску информации, их эффективность поиска зачастую остается недостаточно изученной. В работе ‘WebClipper: Efficient Evolution of Web Agents with Graph-based Trajectory Pruning’ предложен фреймворк, использующий графообразную обрезку траекторий для повышения эффективности веб-агентов. Ключевым результатом является сжатие траекторий вызовов инструментов примерно на 20% при одновременном улучшении точности, достигаемое за счет моделирования процесса поиска агента в виде графа состояний и оптимизации траекторий как задачи поиска минимально необходимого направленного ациклического графа. Возможно ли дальнейшее улучшение баланса между точностью и эффективностью веб-агентов при помощи новых метрик и алгоритмов оптимизации?

Преодоление Когнитивных Ограничений Веб-Агентов

Современные веб-агенты сталкиваются со значительными трудностями при выполнении сложных, многоступенчатых рассуждений, необходимых для точного извлечения информации из сети. В отличие от простых поисковых запросов, требующих лишь сопоставления ключевых слов, решение реальных задач часто требует последовательного анализа нескольких источников, выявления скрытых связей и применения логических выводов. Эта потребность в глубоком рассуждении обусловлена неструктурированностью и неоднозначностью информации, доступной в интернете, что приводит к ошибкам и неточностям в результатах, полученных агентами. Неспособность эффективно справляться с подобными задачами ограничивает практическое применение веб-агентов в сферах, требующих высокой точности и надежности, таких как научные исследования, финансовый анализ и принятие критически важных решений.

Традиционные методы, используемые в веб-агентах для поиска информации, часто характеризуются излишней сложностью и неэффективностью. Вместо прямого пути к решению, они генерируют длинные, запутанные последовательности действий — так называемые «траектории». Это приводит к значительному увеличению времени поиска и потребляемых ресурсов, что делает их применение в реальных задачах затруднительным. По сути, агент тратит энергию на выполнение ненужных шагов, прежде чем достигнет нужного результата, что серьезно ограничивает масштабируемость и практическую ценность подобных систем. В результате, даже относительно простые запросы могут потребовать чрезмерных вычислительных мощностей и времени, препятствуя широкому распространению веб-агентов в повседневной жизни и в сложных автоматизированных процессах.

WebClipper: Обрезка для Эффективности и Когерентности

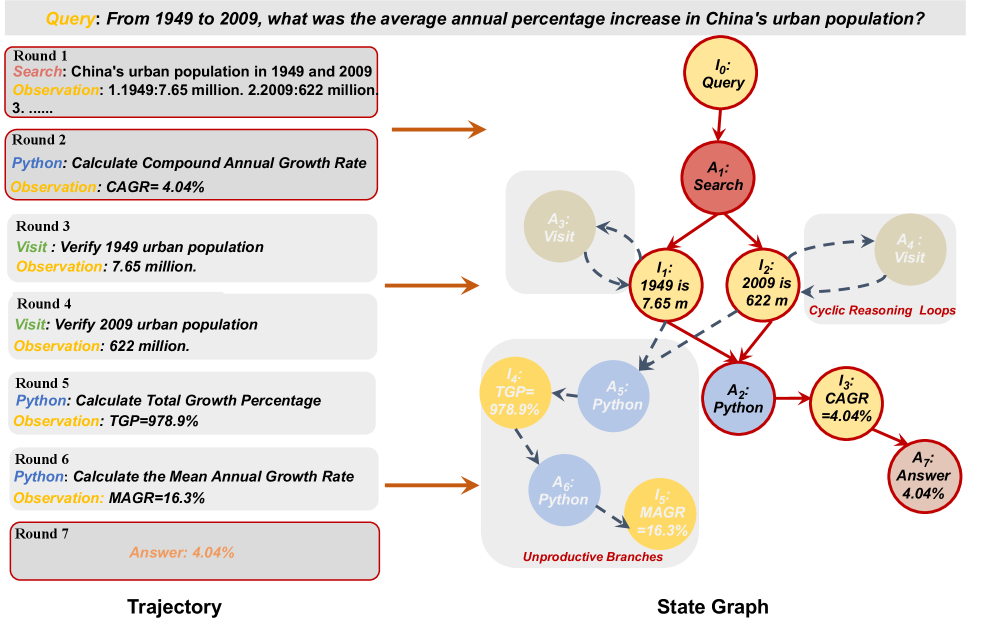

WebClipper использует методы, такие как MNDAG Pruning (Multi-Node Directed Acyclic Graph Pruning) и преобразование траекторий в граф состояний (Trajectory-to-State-Graph Transformation), для сжатия траекторий агента. MNDAG Pruning позволяет удалить из графа избыточные узлы и ребра, сохраняя при этом ключевую информацию о последовательности действий. Преобразование траекторий в граф состояний фокусируется на значимых переходах между состояниями, абстрагируясь от конкретных действий, выполняемых агентом между этими состояниями. Эти техники совместно позволяют значительно уменьшить размер представления траектории, сохраняя при этом её информативность и позволяя эффективно хранить и обрабатывать большие объемы данных о поведении агента.

В WebClipper достигается сжатие траекторий агента путем абстрагирования конкретных действий и фокусировки на существенных переходах между состояниями. Вместо детальной записи каждого шага, система идентифицирует ключевые изменения в окружающей среде и внутреннем состоянии агента, формируя более лаконичное представление процесса рассуждений. Этот подход позволяет сократить объем данных, необходимых для хранения и обработки траекторий, без потери информации, критичной для воссоздания логики принятия решений. Фактически, WebClipper переходит от описания как агент достиг определенного состояния, к фиксации только того, что состояние изменилось, и каким образом это изменение повлияло на дальнейшие действия.

Процесс обрезки траекторий в WebClipper дополняется механизмом Coherence-Aware Thought Rewriting, направленным на поддержание семантической согласованности в сжатых траекториях рассуждений. Данный механизм анализирует оставшиеся шаги после обрезки и перефразирует их, чтобы исключить логические разрывы и противоречия, возникающие из-за удаления промежуточных действий. Это обеспечивает, что сокращенная траектория по-прежнему представляет собой логически связную и осмысленную последовательность рассуждений, несмотря на уменьшенное количество шагов. В результате, повышается не только эффективность, но и надежность генерируемых ответов.

Уточнение Мыслей Агента: Перплексия и Отбор с Отклонением

Отбор на основе перплексии оценивает и приоритизирует перефразированные мысли, основываясь на их стилистической согласованности и беглости. Перплексия, как метрика, количественно оценивает, насколько хорошо языковая модель предсказывает последовательность токенов в тексте; более низкая перплексия указывает на более высокую вероятность, что текст соответствует распределению естественного языка, и, следовательно, обладает большей стилистической связностью и беглостью. В процессе уточнения мыслей, данный метод позволяет отбирать варианты, которые наиболее соответствуют ожидаемому стилю и грамматической корректности, что способствует генерации более качественных и естественных текстов.

Процесс отбора, основанный на оценке перплексии, интегрирован с методом принятия-отклонения (Rejection Sampling) для оптимизации траекторий поиска решений. В рамках этого подхода, перефразированные мысли оцениваются на соответствие заданным критериям, и только те, которые демонстрируют приемлемый уровень перплексии (т.е. высокую вероятность соответствия языковой модели), допускаются для дальнейшего рассмотрения. Остальные траектории отбрасываются, что позволяет сконцентрировать вычислительные ресурсы на наиболее перспективных направлениях и повысить эффективность поиска оптимального решения. Вероятность принятия конкретной траектории определяется на основе оценки перплексии и заданного порога принятия, что обеспечивает баланс между исследованием пространства решений и эксплуатацией наиболее вероятных путей.

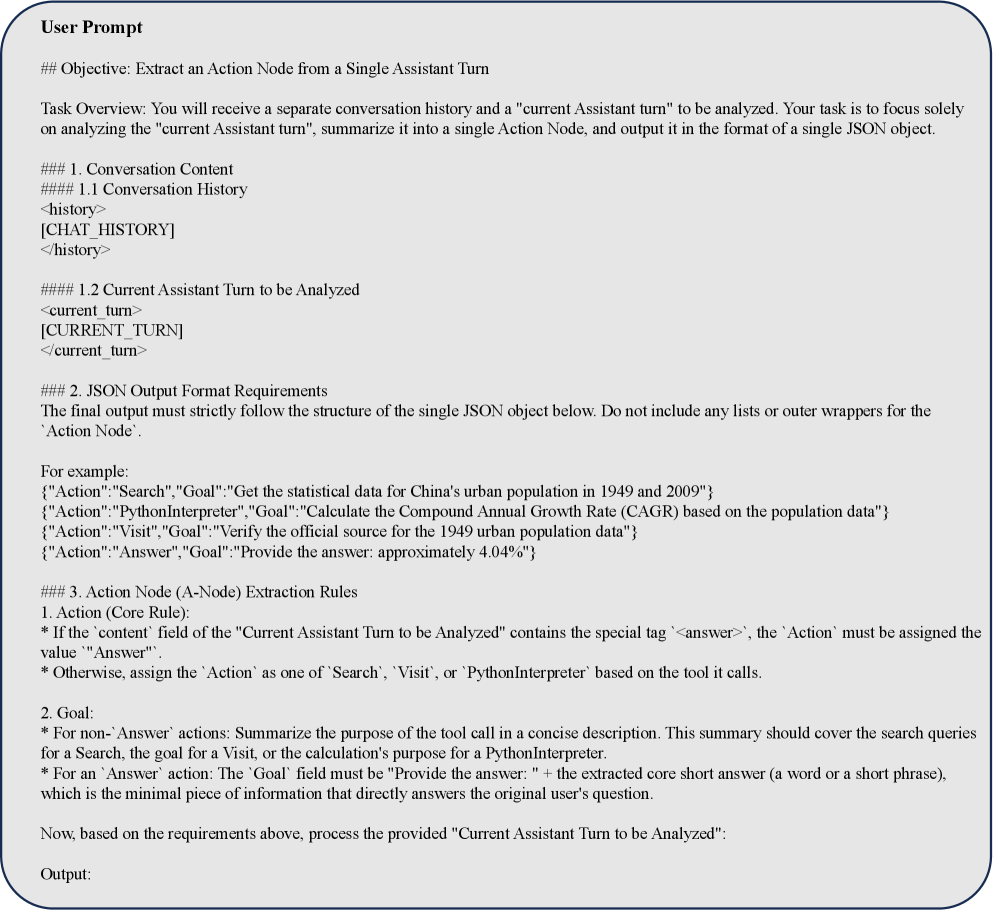

Экстрактор на базе большой языковой модели (LLM) выполняет ключевую функцию как на этапе перефразирования исходных мыслей, так и на этапе их оценки. Он используется для генерации альтернативных формулировок, обеспечивая разнообразие вариантов для дальнейшего анализа. В процессе оценки экстрактор анализирует полученные перефразировки, определяя их соответствие заданным критериям качества, таким как связность, грамматическая корректность и смысловая согласованность. Использование LLM экстрактора позволяет обеспечить надежную основу для уточнения мыслей, поскольку он способен учитывать контекст и нюансы языка, что критически важно для получения логичных и последовательных результатов.

Оценка Эффективности: Показатель F-AE

Для оценки эффективности веб-агентов была предложена метрика F-AE, позволяющая количественно оценить компромисс между точностью и скоростью работы. Традиционные показатели часто фокусируются лишь на одном аспекте — например, на проценте успешно выполненных задач, игнорируя при этом количество шагов или потребление ресурсов. F-AE Score учитывает оба этих параметра, предоставляя более полное представление о производительности агента. Данная метрика позволяет сравнивать различные модели и алгоритмы, выявляя те, которые наиболее эффективно сочетают в себе точность выполнения задач и рациональное использование ресурсов, что особенно важно для веб-агентов, работающих в реальном времени и взаимодействующих с большими объемами данных.

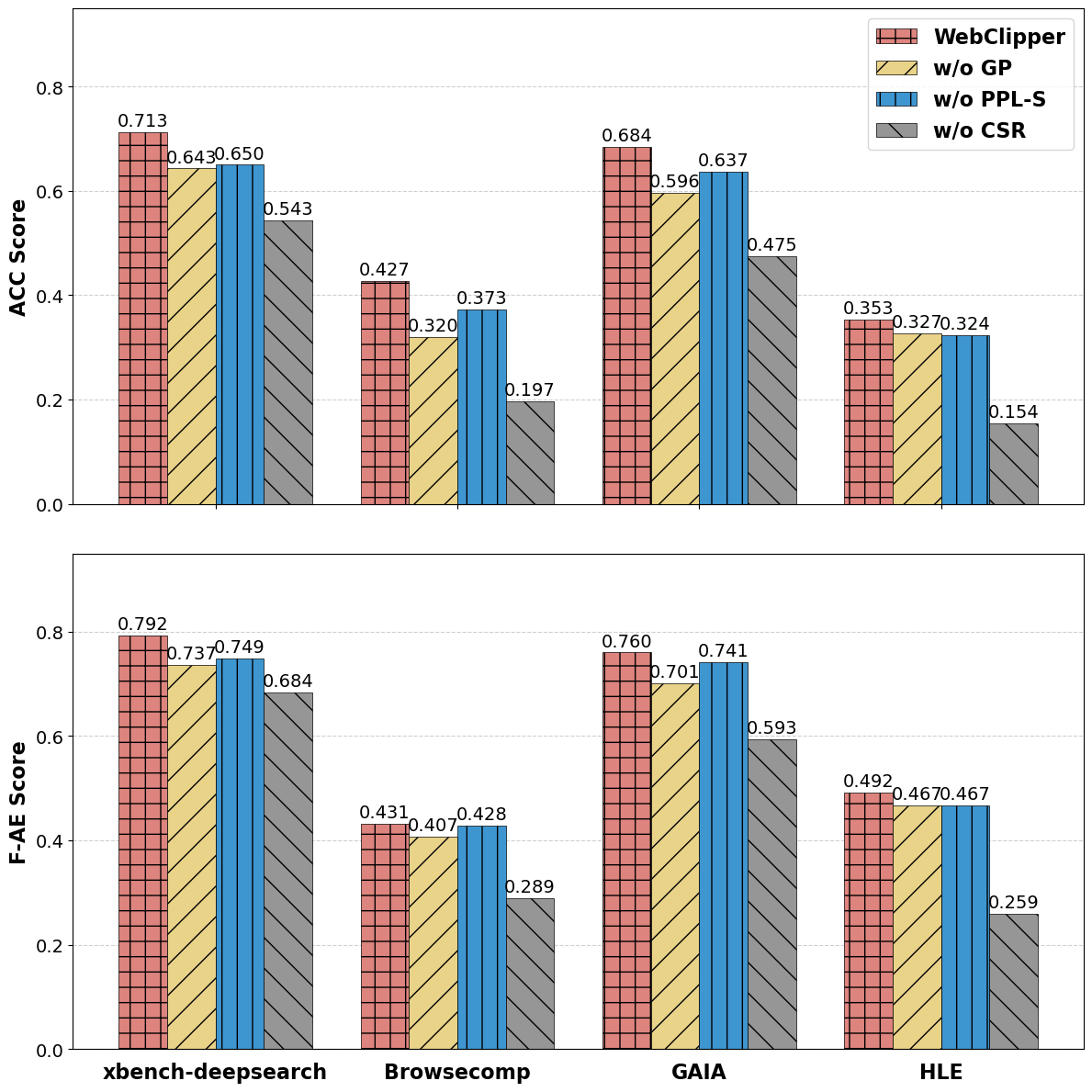

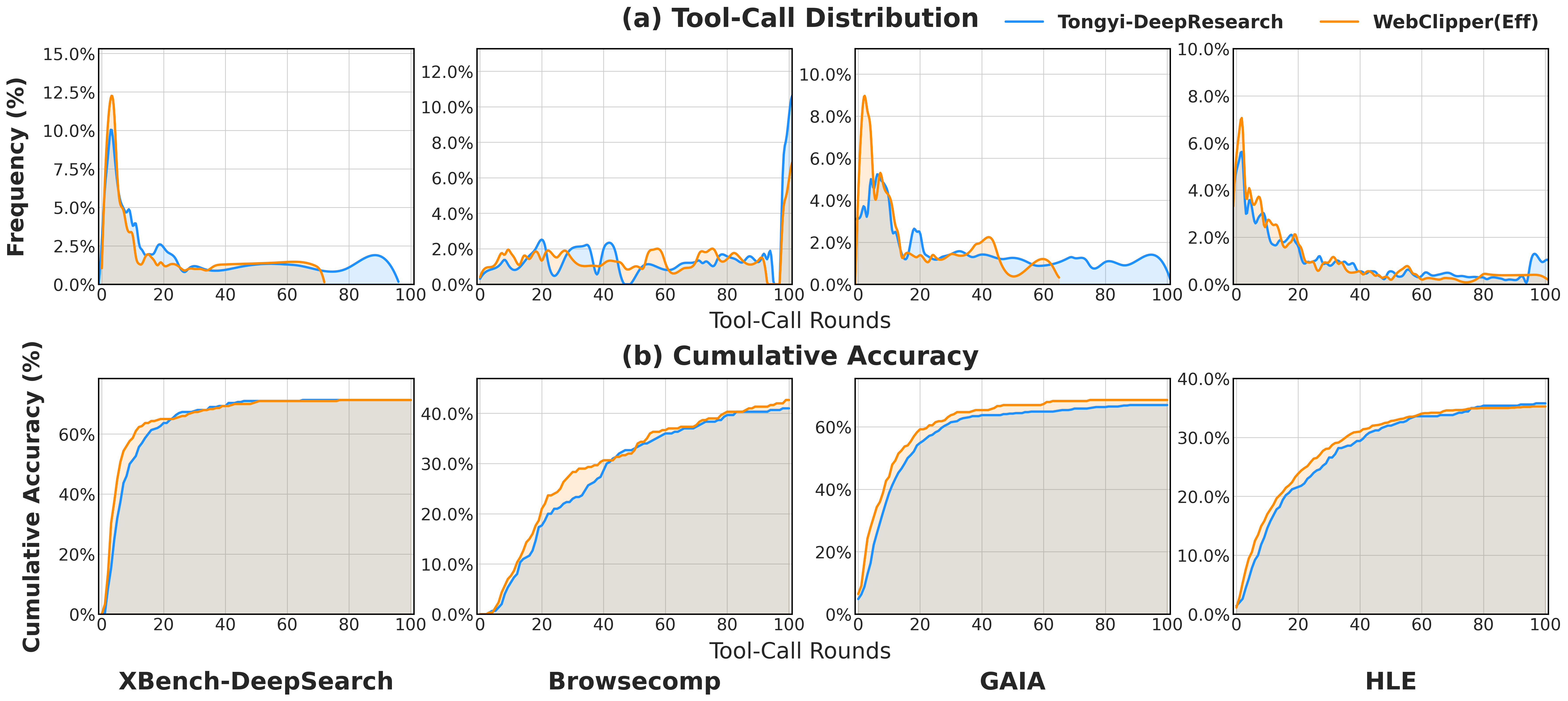

Экспериментальные исследования показали, что WebClipper, использующий описанные методы, значительно повышает эффективность работы с веб-агентами. В ходе тестов удалось снизить количество обращений к инструментам (tool-call rounds) примерно на 21%, а также уменьшить потребление токенов на 19.4% по сравнению с базовыми моделями. Данное снижение не только оптимизирует вычислительные затраты, но и способствует более быстрой и плавной работе агента, что особенно важно при взаимодействии со сложными веб-сайтами и выполнении многоступенчатых задач.

Исследования показали, что WebClipper демонстрирует наивысший показатель F-AE среди доступных моделей с открытым исходным кодом. Этот результат свидетельствует о сбалансированном подходе к достижению высокой точности при одновременной оптимизации эффективности работы. В отличие от многих систем, которые жертвуют одним ради другого, WebClipper эффективно сочетает в себе надежность выполнения задач и минимальное потребление ресурсов, что делает его особенно ценным инструментом для широкого спектра веб-приложений и задач автоматизации. Достижение такого баланса открывает новые возможности для создания более производительных и экономичных веб-агентов.

Исследование, представленное в данной работе, демонстрирует стремление к созданию не просто работающих, но и принципиально корректных веб-агентов. Авторы, используя подход, основанный на графах и отсечении неэффективных траекторий, стремятся к устойчивости алгоритмов в условиях растущей сложности задач. Как однажды заметила Грейс Хоппер: «Лучший способ предсказать будущее — это создать его». Этот принцип находит отражение в WebClipper, где, стремясь к оптимизации соотношения точности и эффективности (F-AE Score), создается агент, способный адаптироваться и сохранять работоспособность даже при увеличении объема данных и сложности веб-среды. Данный подход акцентирует внимание на фундаментальных принципах, а не на временных решениях, что обеспечивает долгосрочную устойчивость системы.

Куда двигаться дальше?

Представленная работа, хотя и демонстрирует элегантность подхода к оптимизации веб-агентов через обрезку траекторий, лишь обнажает глубину нерешенных проблем. Идея построения графа возможных действий и последующего его «расчищения» от неэффективных ветвей, безусловно, логична, однако возникает вопрос о масштабируемости этого подхода к задачам, требующим исследования поистине огромного пространства состояний. С ростом сложности веб-сайтов и задач, решаемых агентами, вычислительная стоимость построения и анализа графа может быстро стать непомерной. Необходимо искать алгоритмы, позволяющие динамически оценивать перспективность траекторий, не требуя полного построения графа.

Оценка, представленная в виде F-AE, является разумным компромиссом между точностью и эффективностью, но она все же остается эвристикой. Более строгий математический аппарат, позволяющий доказуемо оптимизировать агента по заданным критериям, остается заветной целью. Необходимо исследовать возможности применения формальных методов верификации и синтеза программ для создания веб-агентов, гарантированно достигающих оптимального решения за минимальное время.

В конечном счете, в хаосе данных спасает только математическая дисциплина. Разработка алгоритмов, способных к самообучению и адаптации к изменяющимся условиям, представляется наиболее перспективным направлением. И лишь тогда, когда алгоритм станет доказуемо корректным, можно будет говорить об истинной элегантности и эффективности веб-агентов.

Оригинал статьи: https://arxiv.org/pdf/2602.12852.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- БИТКОИН ПРОГНОЗ. BTC криптовалюта

- ПРОГНОЗ ДОЛЛАРА К ШЕКЕЛЮ

- SOL ПРОГНОЗ. SOL криптовалюта

- ЭФИРИУМ ПРОГНОЗ. ETH криптовалюта

- ДОГЕКОИН ПРОГНОЗ. DOGE криптовалюта

- РИППЛ ПРОГНОЗ. XRP криптовалюта

- SUI ПРОГНОЗ. SUI криптовалюта

- FARTCOIN ПРОГНОЗ. FARTCOIN криптовалюта

- HYPE ПРОГНОЗ. HYPE криптовалюта

- SAROS ПРОГНОЗ. SAROS криптовалюта

2026-02-17 06:55