Автор: Денис Аветисян

Исследователи предлагают эволюционный поиск для создания активационных функций, способных повысить устойчивость нейронных сетей к данным, выходящим за рамки тренировочного набора.

Эволюционный алгоритм, использующий синтетические данные и динамику хаотических систем, позволяет находить активационные функции с улучшенной обобщающей способностью.

Выбор функции активации остается активной областью исследований, поскольку различные подходы стремятся улучшить оптимизацию, сохраняя при этом выразительность модели. В работе ‘Mining Generalizable Activation Functions’ предложен эволюционный поиск для обнаружения новых функций активации, способных улучшить обобщающую способность нейронных сетей за счёт использования синтетических данных и акцента на динамике хаотических систем. Показано, что современные инструменты, такие как AlphaEvolve, позволяют исследовать широкий спектр функций, а использование штрафных условий по вычислительной сложности способствует поиску осмысленных активаций. Возможно ли, таким образом, целенаправленно разрабатывать функции активации, кодирующие определенные индуктивные смещения и обеспечивающие устойчивость к сдвигам распределения данных?

Ограничения Существующих Архитектур

Традиционные сверточные нейронные сети, такие как VGGNetwork и ResNet50, продемонстрировали впечатляющие результаты на ImageNetDataset, однако их способность к обобщению на данные, отличные от обучающей выборки, остается ограниченной. Исследования показывают, что сети, успешно распознающие изображения в рамках ImageNet, испытывают значительные трудности при работе с данными из других областей, что свидетельствует о переобучении и недостаточной инвариантности к изменениям в структуре данных. Это особенно заметно при попытке применения этих архитектур к задачам, где данные имеют иную природу или статистические характеристики, подчеркивая необходимость разработки более гибких и адаптивных моделей, способных эффективно работать с разнообразными типами данных.

Традиционные сверточные нейронные сети, такие как VGGNetwork и ResNet50, демонстрируют ограниченную способность адаптироваться к данным, не имеющим привычной евклидовой структуры. Эта особенность существенно снижает их эффективность при решении задач, связанных со сложными, нерегулярными данными, например, при прогнозировании свойств молекул. В частности, при анализе набора данных OOBG_MolHIV, предназначенного для оценки противовирусной активности соединений, стандартные архитектуры демонстрируют снижение точности из-за неспособности эффективно обрабатывать графоподобную структуру молекул и учитывать сложные взаимосвязи между атомами. Гибкость, необходимая для моделирования таких неевклидовых данных, требует новых подходов, способных учитывать специфику и сложность молекулярных структур, что открывает перспективы для разработки специализированных архитектур, превосходящих существующие решения в области хемоинформатики.

Эволюция Функций Активации для Устойчивости

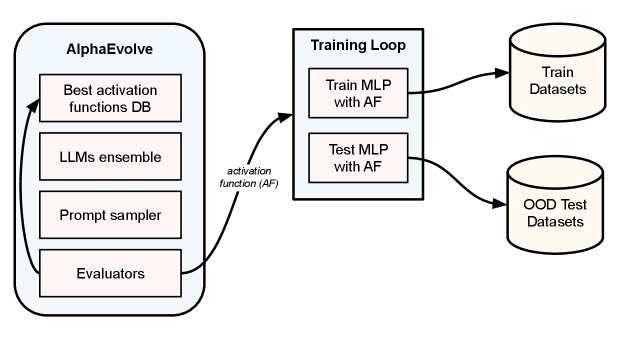

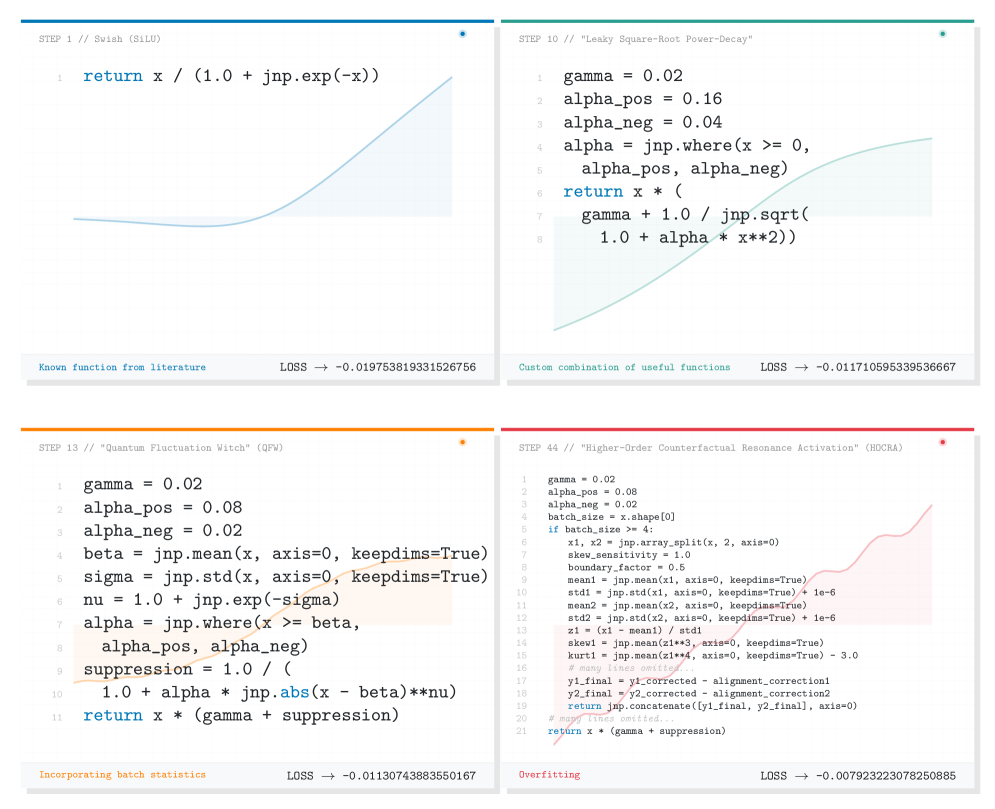

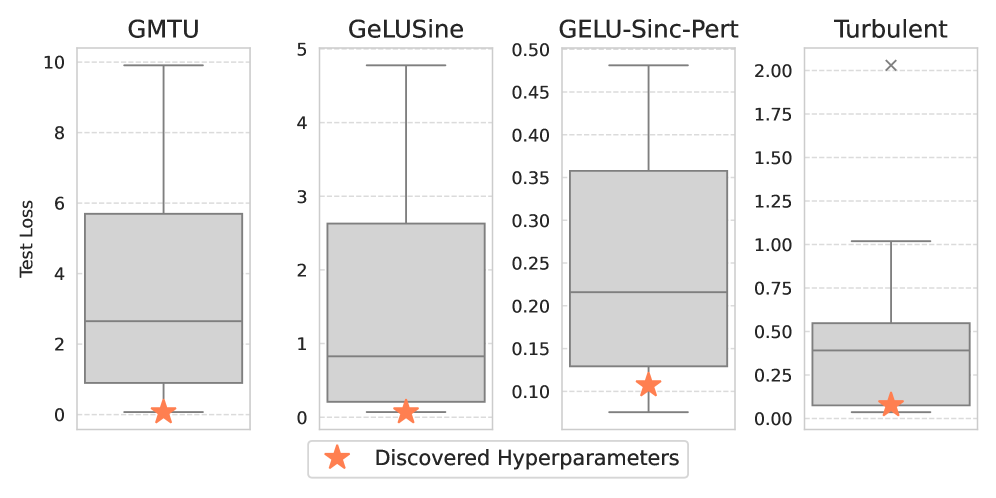

Алгоритм AlphaEvolve, основанный на принципах эволюционных вычислений, представляет собой эффективный инструмент для автоматического поиска новых функций активации, выходящих за рамки традиционной GELU. В отличие от ручного проектирования, AlphaEvolve использует генетические алгоритмы для итеративной оптимизации параметров функций активации, стремясь к улучшению производительности модели на целевых задачах. Этот подход позволяет исследовать широкий спектр возможных функций активации, включая нетривиальные и сложные формы, которые могут быть труднореализуемыми или неочевидными для человека-проектировщика. В процессе эволюции, популяция функций активации подвергается мутациям и кроссоверу, а наиболее успешные функции, оцениваемые по заданным критериям, отбираются для следующего поколения, обеспечивая постепенное улучшение характеристик.

В результате применения алгоритма AlphaEvolve были разработаны новые функции активации — TurbulentActivation и PhaseLockedEntropicRepulsion. Эти функции специально созданы для повышения устойчивости и выразительности моделей машинного обучения. TurbulentActivation характеризуется нелинейным поведением, способствующим более эффективному представлению сложных данных. PhaseLockedEntropicRepulsion, в свою очередь, использует энтропию для регуляризации и улучшения обобщающей способности модели, что позволяет достичь лучших результатов на задачах, требующих высокой точности и надежности.

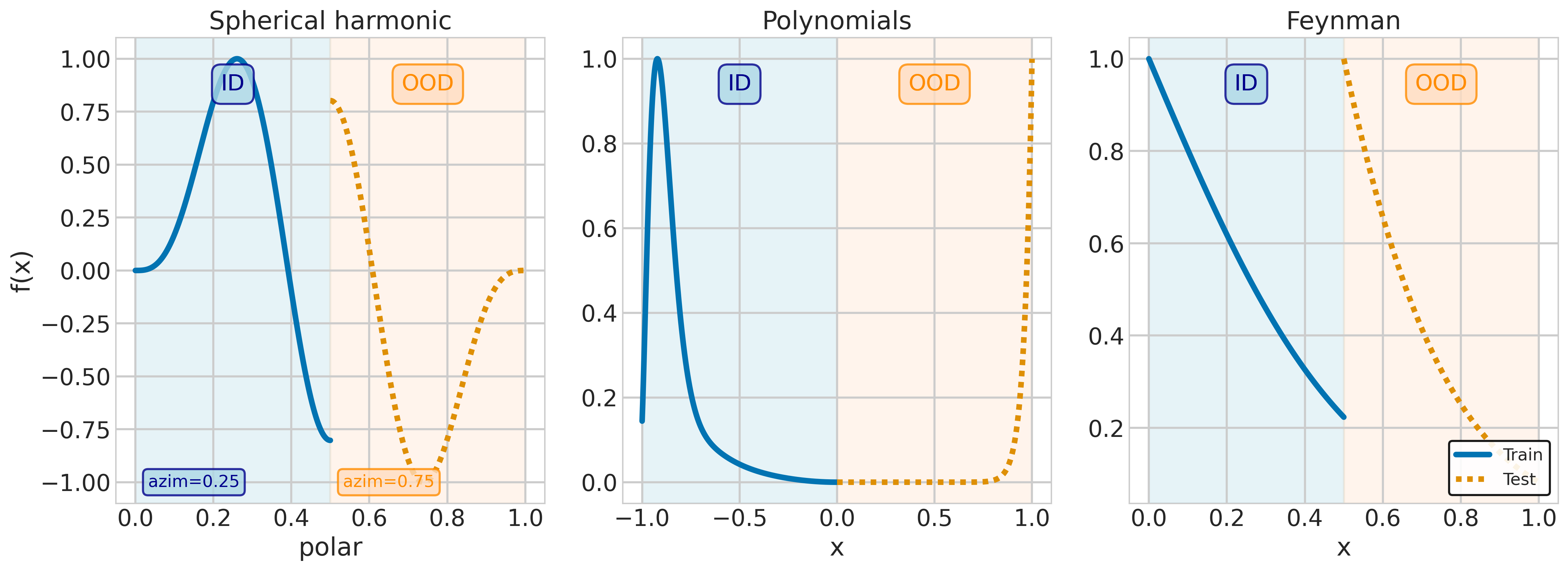

Функции TurbulentActivation и PhaseLockedEntropicRepulsion были разработаны с целью повышения производительности моделей на сложных синтетических наборах данных, таких как RandomPolynomialsDataset, FeynmanEquationsDataset и SphericalHarmonicsDataset. В ходе обучения с использованием алгоритма AlphaEvolve наблюдались улучшения метрик на этих наборах данных, что свидетельствует о потенциале новых функций в решении задач, требующих высокой обобщающей способности и устойчивости к шуму. Использование этих наборов данных позволяет оценить способность моделей к экстраполяции и решению нелинейных уравнений, что важно для разработки более надежных систем искусственного интеллекта.

Проверка Эффективности на Разнообразных Данных

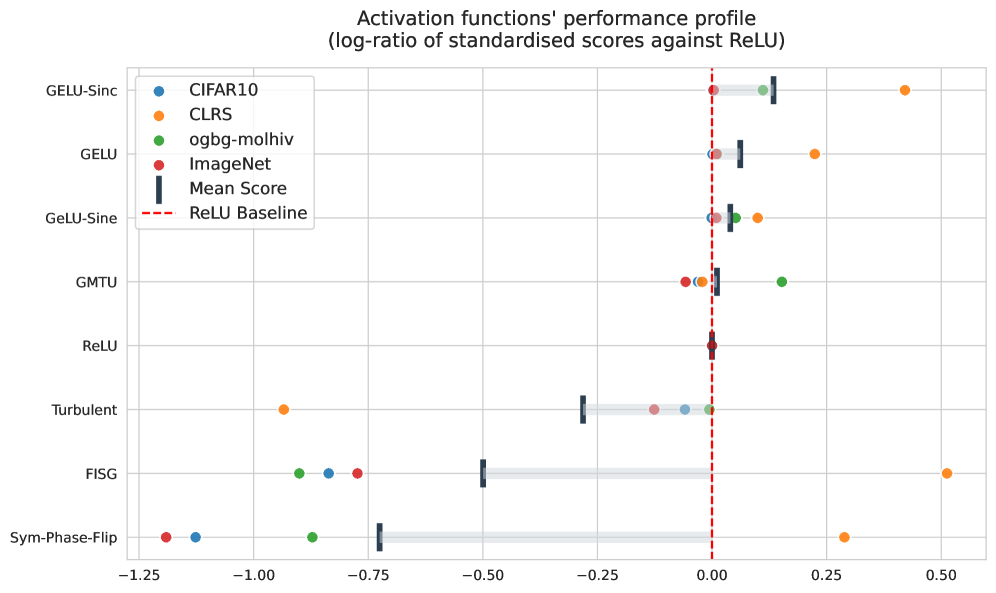

Комбинация функций активации TurbulentActivation и PhaseLockedEntropicRepulsion, совместно с GELUSine, демонстрирует значительное улучшение результатов на наборе данных CIFAR10Dataset. Эксперименты показали, что данное сочетание повышает точность классификации изображений по сравнению с использованием отдельных функций активации или другими стандартными подходами. Улучшение производительности подтверждается количественными метриками, такими как повышение общей точности и снижение частоты ошибок классификации. Данные результаты указывают на потенциал использования данной комбинации функций активации для повышения эффективности моделей машинного обучения, работающих с задачами классификации изображений.

Применение функций активации TurbulentActivation и PhaseLockedEntropicRepulsion в сочетании с GELUSine демонстрирует улучшение производительности на наборе данных CLRS30Dataset. Достигнутые результаты сопоставимы с показателями современных алгоритмов, что указывает на потенциальное улучшение способностей к алгоритмическому мышлению. Данная валидация была подтверждена использованием архитектуры TripletGMPNN, позволяющей оценить эффективность представленных функций активации при решении задач, требующих логических рассуждений и обработки последовательностей данных.

Результаты, полученные при использовании TurbulentActivation и PhaseLockedEntropicRepulsion в сочетании с GELUSine, демонстрируют улучшенную обобщающую способность не только на задачах распознавания изображений и алгоритмического рассуждения, но и на молекулярных наборах данных. В частности, на наборе OOBG_MolHIV_Dataset, комбинация указанных функций активации показала конкурентоспособные результаты, что подтверждает потенциал их применения в задачах, связанных с молекулярным моделированием и предсказанием свойств.

Влияние на Будущие Архитектуры Искусственного Интеллекта

Успешное применение AlphaEvolve в открытии устойчивых функций активации демонстрирует значительный потенциал автоматизированного машинного обучения (AutoML) для дальнейшего развития исследований в области искусственного интеллекта. Данная система, самостоятельно разработавшая функции, превосходящие существующие аналоги, указывает на возможность автоматизации не только настройки параметров нейронных сетей, но и самого процесса их проектирования. Это открывает перспективы для создания более эффективных и адаптируемых моделей, способных решать сложные задачи без необходимости ручной разработки каждого компонента. Подобный подход позволяет значительно ускорить темпы инноваций в сфере ИИ, освобождая исследователей от трудоемких задач и позволяя им сосредоточиться на более глобальных проблемах и стратегических направлениях.

Исследования показали, что проектирование функций активации играет ключевую роль в раскрытии полного потенциала моделей глубокого обучения. Традиционно, архитектура сети и алгоритмы обучения привлекали основное внимание, однако, именно функции активации определяют способность нейронов эффективно обрабатывать и передавать информацию. Новые открытия демонстрируют, что оптимизация этих функций, направленная на повышение адаптивности и обобщающей способности, может значительно улучшить производительность модели в различных задачах. Более того, удачно подобранная функция активации способна снизить потребность в огромных объемах данных для обучения и повысить устойчивость модели к шуму и искажениям. Таким образом, дальнейшее изучение и разработка инновационных функций активации представляется перспективным направлением для прогресса в области искусственного интеллекта.

Разработка искусственного интеллекта всё больше смещается в сторону создания систем, способных к адаптации и обобщению, а не к узкоспециализированным архитектурам. Такой подход позволяет создавать универсальные модели, эффективно решающие разнообразные задачи без необходимости переобучения для каждого конкретного случая. Вместо жёстко заданных параметров и структур, системы будущего будут способны самостоятельно настраиваться и оптимизироваться под изменяющиеся условия и новые данные. Это открывает путь к созданию действительно интеллектуальных систем, способных к обучению в течение всей жизни и применению знаний в различных областях, значительно расширяя спектр решаемых ими проблем и приближая нас к созданию общего искусственного интеллекта.

Исследование демонстрирует, что поиск оптимальных функций активации — задача нетривиальная, требующая выхода за рамки устоявшихся решений. Авторы предлагают эволюционный подход, стремясь к созданию функций, устойчивых к изменениям в данных. Это особенно важно, учитывая, что традиционные функции активации могут оказаться неэффективными при столкновении с данными, отличными от тех, на которых они обучались. Как однажды заметил Винтон Серф: «Сложность — это тщеславие. Ясность — милосердие». В данном исследовании эта простота достигается за счет поиска функций, способных к обобщению, а не к запоминанию, что повышает устойчивость нейронных сетей к непредсказуемым данным, особенно в контексте хаотичных систем. Каждая сложность требует алиби, и здесь предлагаемый метод предоставляет четкое обоснование для каждой вновь созданной функции активации.

Куда Далее?

Представленная работа, стремясь к поиску обобщаемых функций активации, неизбежно наталкивается на фундаментальную сложность: сама идея “обобщения” является лишь приближением, компромиссом между необходимостью и реальностью. Поиск функций, устойчивых к данным, отличным от тренировочных, подобен попытке удержать воду решетом — задача не столько невозможная, сколько бесконечно приближающаяся к идеалу. Вместо погони за абсолютной устойчивостью, возможно, более плодотворным окажется принятие неизбежной хрупкости моделей и разработка методов для быстрой адаптации к новым, неожиданным данным.

Особое внимание следует уделить природе синтетических данных, используемых в исследовании. Сгенерированные хаотические системы предоставляют удобный полигон для испытаний, но насколько адекватно они отражают сложность реального мира? Увлечение синтезом данных рискует привести к созданию моделей, блестяще справляющихся с искусственно созданными проблемами, но беспомощных перед лицом истинной неопределенности. Важнее не количество сгенерированных сценариев, а их качество, глубина и способность отражать ключевые аспекты реальных данных.

В конечном счете, успех в данной области, вероятно, будет заключаться не в создании “идеальной” функции активации, а в разработке архитектур, способных к самообучению и самокоррекции. Нейронные сети, подобно живым организмам, должны уметь адаптироваться к меняющимся условиям, учиться на ошибках и развиваться. Задача исследователя — не проектировать совершенство, а создать условия для его возникновения. Иногда, самое лучшее решение — это просто убрать лишнее.

Оригинал статьи: https://arxiv.org/pdf/2602.05688.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- БИТКОИН ПРОГНОЗ. BTC криптовалюта

- ПРОГНОЗ ДОЛЛАРА К ШЕКЕЛЮ

- SOL ПРОГНОЗ. SOL криптовалюта

- ЭФИРИУМ ПРОГНОЗ. ETH криптовалюта

- Акции Южуралзолото ГК прогноз. Цена акций UGLD

- РИППЛ ПРОГНОЗ. XRP криптовалюта

- SAROS ПРОГНОЗ. SAROS криптовалюта

- ДОГЕКОИН ПРОГНОЗ. DOGE криптовалюта

- FARTCOIN ПРОГНОЗ. FARTCOIN криптовалюта

- SUI ПРОГНОЗ. SUI криптовалюта

2026-02-06 15:08