Автор: Денис Аветисян

Новая методика машинного обучения позволяет создавать реалистичные рентгеновские изображения в тёмном поле, оценивая и учитывая различные типы неопределённости.

Читаем отчёты, пьём кофе, ждём дивиденды. Если тебе надоел хайп и ты ищешь скучную, но стабильную гавань — добро пожаловать.

Бесплатный Телеграм канал

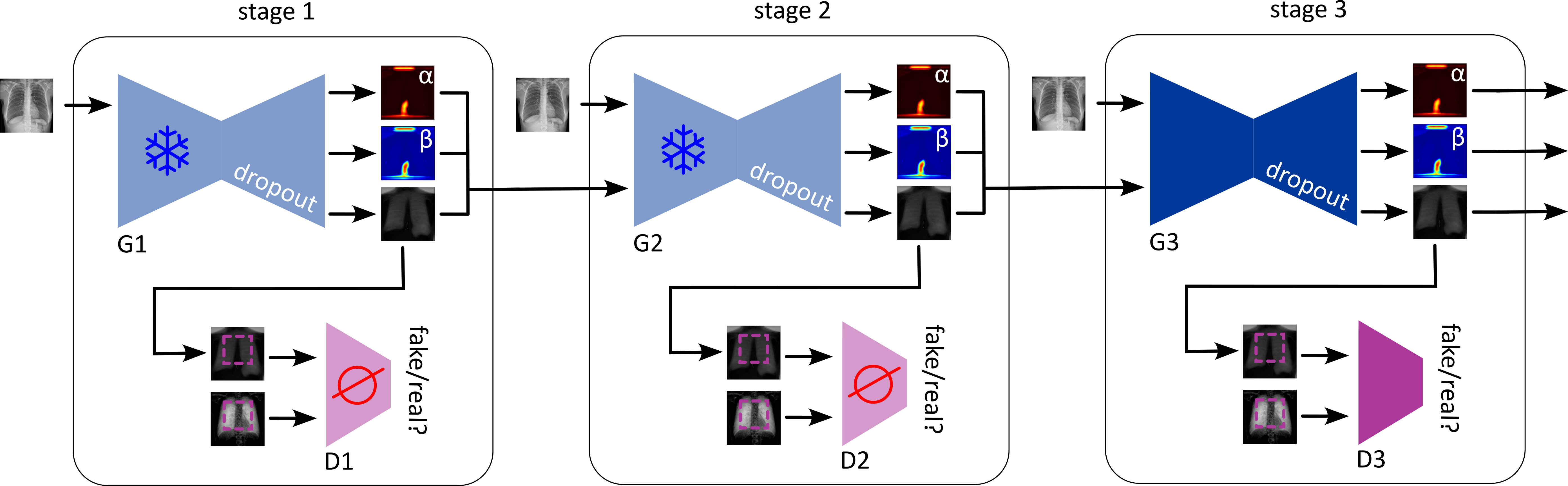

Предложена глубокая нейронная сеть, использующая генеративно-состязательные сети (GAN) для синтеза рентгеновских снимков в тёмном поле, с квантификацией как алеаторной, так и эпистемической неопределённости.

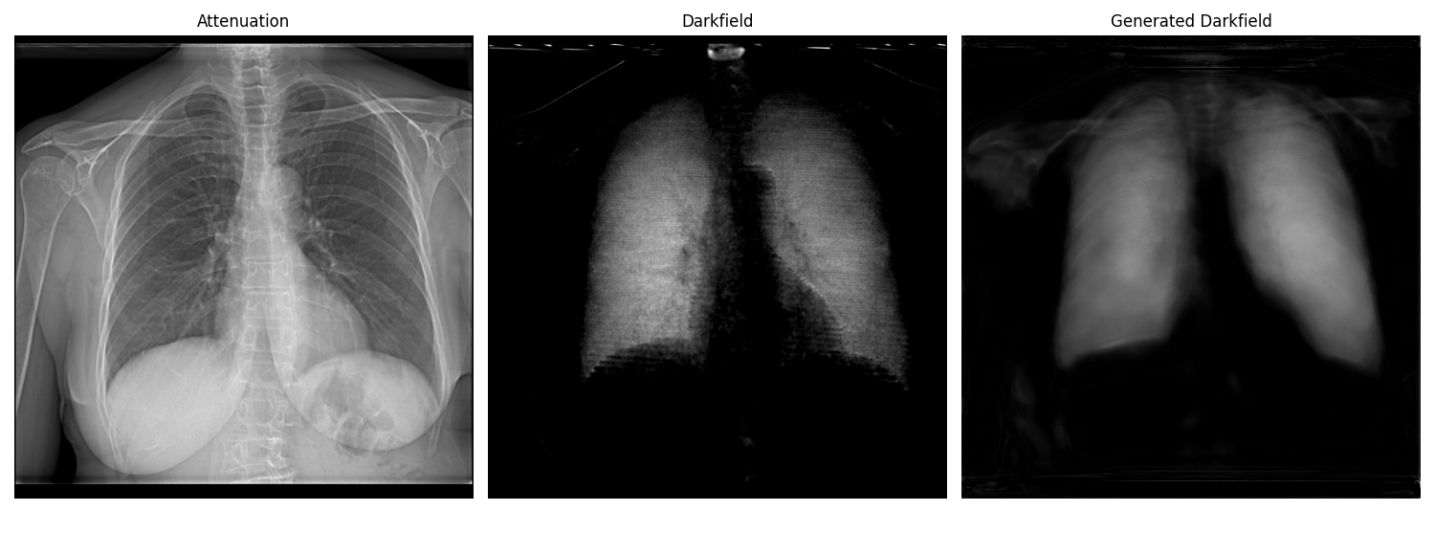

Несмотря на возрастающую потребность в неинвазивной диагностике микроструктурных изменений тканей, данные рентгеновской темпографии остаются ограниченными. В данной работе, посвященной ‘Uncertainty-guided Generation of Dark-field Radiographs’, представлена первая система, способная генерировать изображения темпографической рентгенографии непосредственно из стандартных рентгеновских снимков, используя генеративно-состязательную сеть (GAN) с учетом неопределенности. Внедрение как алеаторной, так и эпистемической неопределенности позволяет повысить надежность и интерпретируемость синтезируемых изображений. Открывает ли это новые перспективы для клинического применения и дальнейшего развития методов диагностики на основе искусственного интеллекта?

За гранью поглощения: Ограничения традиционной рентгенографии

Стандартная рентгенография, основанная на измерении ослабления рентгеновского излучения при прохождении через ткани, предоставляет ограниченное представление о микроструктуре. Этот метод эффективно выявляет плотные образования, однако часто упускает из виду незначительные, но критически важные изменения, происходящие на уровне ткани. В частности, тонкие структурные изменения, такие как начальные стадии фиброза или небольшие отеки, могут быть невидимы при обычной рентгенографии, поскольку ослабление излучения не всегда достаточно чувствительно к таким нюансам. Это ограничивает возможности ранней диагностики и точной оценки состояния тканей, подчеркивая необходимость разработки более чувствительных методов визуализации, способных улавливать микроскопические изменения.

Стандартная рентгенография, основанная на ослаблении рентгеновского излучения при прохождении через ткани, демонстрирует высокую эффективность в обнаружении плотных структур, таких как костные переломы или инородные тела. Однако, при ранних стадиях заболеваний, когда изменения в тканях еще незначительны и не сопровождаются значительным изменением плотности, традиционная рентгенография оказывается недостаточно чувствительной. Это создает серьезные диагностические трудности, поскольку упускаются важные микроструктурные изменения, предшествующие заметным патологическим процессам. Неспособность к детализированному анализу тканей ограничивает возможности ранней диагностики и мониторинга эффективности лечения, подчеркивая необходимость развития более чувствительных методов визуализации.

Рентгенография в тёмном поле представляет собой перспективное дополнение к традиционным методам визуализации, позволяя выявлять микроструктурные особенности тканей, недоступные для стандартной рентгенографии, основанной на поглощении. В отличие от оценки плотности, этот метод регистрирует рассеяние рентгеновских лучей, что дает информацию о размере и распределении микроструктурных элементов. Однако, интерпретация изображений, полученных с помощью рентгенографии в тёмном поле, требует применения сложных алгоритмов обработки изображений для фильтрации шумов и выделения значимых структурных признаков. Эти алгоритмы, включающие в себя методы улучшения контрастности и сегментации изображений, необходимы для точной диагностики и количественной оценки микроструктурных изменений в тканях, что открывает новые возможности для ранней диагностики заболеваний и мониторинга эффективности лечения.

Глубокое обучение: Восстановление деталей и интерпретация изображений

Глубокое обучение предоставляет эффективные инструменты для реконструкции и интерпретации сложных рентгеновских изображений, что позволяет улучшить визуализацию тонких деталей и структур. Методы глубокого обучения способны извлекать и усиливать важные признаки, которые могут быть не видны при стандартной обработке изображений. Это особенно важно в медицинской диагностике, где точное определение мельчайших изменений может иметь решающее значение. Возможность автоматизированного анализа и реконструкции изображений снижает нагрузку на специалистов и повышает точность диагностики, позволяя выявлять патологии на ранних стадиях.

Эффективность алгоритмов глубокого обучения в задачах обработки изображений, в частности, реконструкции и улучшения качества, напрямую зависит от объема и качества обучающих данных. Недостаток больших, размеченных наборов данных является распространенной проблемой, ограничивающей производительность моделей. В связи с этим, генерация синтетических данных становится критически важным методом аугментации данных, позволяющим увеличить разнообразие обучающей выборки и повысить обобщающую способность алгоритмов, компенсируя недостаток реальных данных.

Для оценки точности реконструкции изображений используются стандартные метрики качества, такие как среднеквадратичная ошибка (MSE), отношение сигнал/шум (PSNR) и индекс структурного сходства (SSIM). В рамках предложенной системы наблюдается снижение значения MSE и увеличение PSNR на последовательных этапах обработки, что свидетельствует о повышении достоверности реконструируемого изображения. Уменьшение MSE указывает на снижение разницы между реконструированным и исходным изображением, в то время как увеличение PSNR отражает улучшение соотношения между полезным сигналом и шумом. MSE = \frac{1}{n} \sum_{i=1}^{n} (I_i - K_i)^2, PSNR = 10 \log_{10}(\frac{MAX^2}{MSE}), где I_i — значение пикселя исходного изображения, K_i — значение пикселя реконструированного изображения, а MAX — максимальное возможное значение пикселя.

В финальной стадии работы предложенной системы показатель структурного подобия (SSIM) составил 0.5. Данный результат указывает на умеренную структурную схожесть между сгенерированными и реальными изображениями в тёмном поле. Значение SSIM варьируется от -1 до 1, где 1 означает полную структурную схожесть, 0 — отсутствие корреляции, а отрицательные значения — отрицательную корреляцию. Значение 0.5 свидетельствует о том, что, хотя некоторые структурные элементы удается воспроизвести, значительные различия между сгенерированными и реальными изображениями сохраняются, что требует дальнейшей оптимизации модели для повышения точности реконструкции.

Квантификация неопределенности: Надежность и достоверность анализа

Квантификация неопределенности является критически важным этапом при оценке надежности анализа изображений, основанного на глубоком обучении. Невозможность различать истинный сигнал от шума или артефактов может приводить к ошибочным результатам и, как следствие, к неправильным решениям. Оценка неопределенности позволяет не только выявлять ненадежные прогнозы, но и предоставляет информацию о степени доверия к результатам анализа, что особенно важно в критически важных приложениях, таких как медицинская диагностика или автономное вождение. Без количественной оценки неопределенности невозможно объективно оценить пригодность модели для конкретной задачи и обеспечить ее безопасное и эффективное использование.

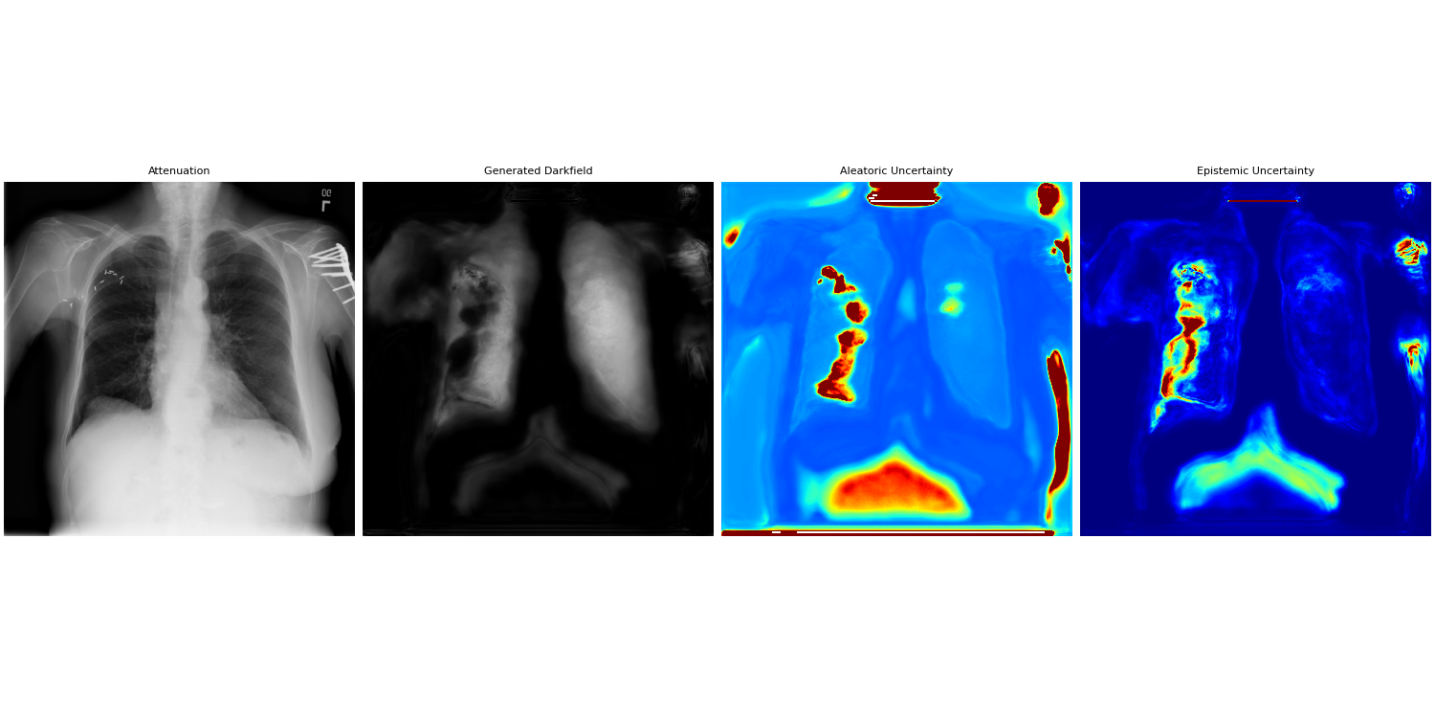

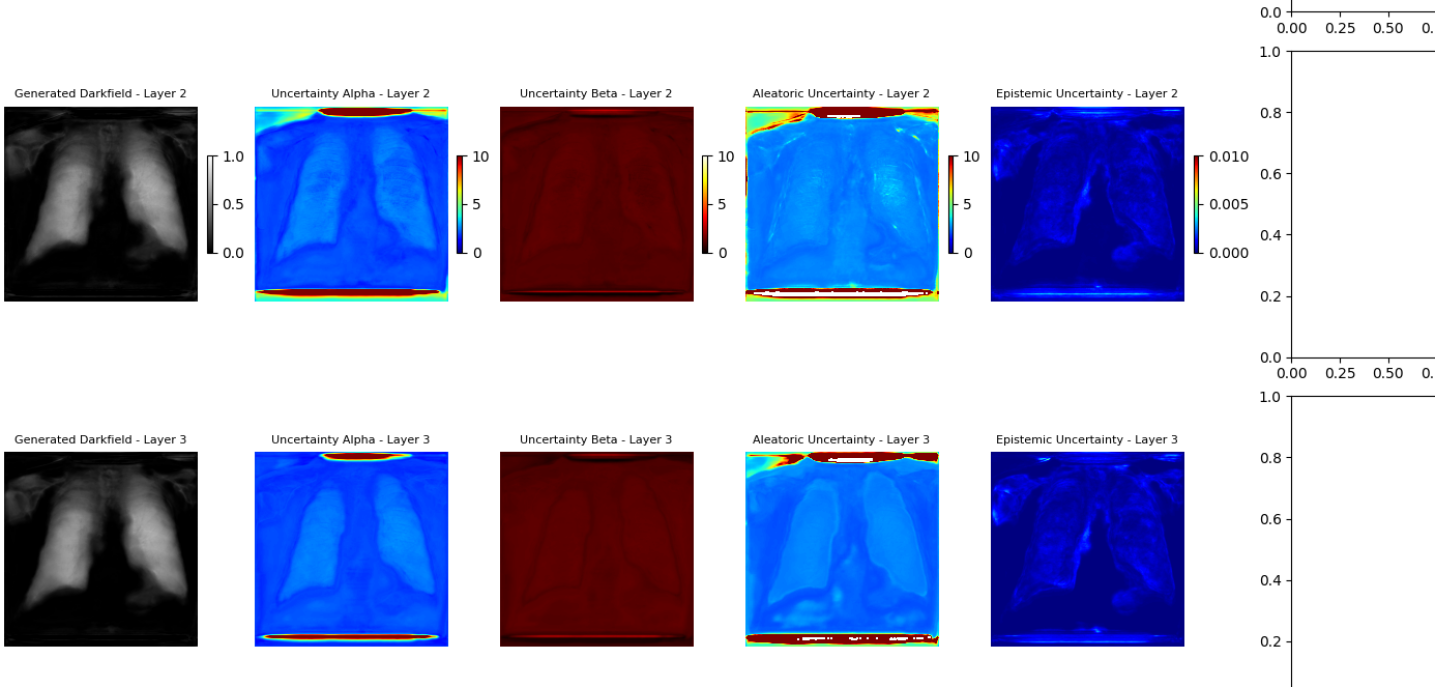

Количественная оценка неопределенности в задачах анализа изображений с использованием глубокого обучения достигается за счет моделирования двух основных типов неопределенности: алеаторической и эпистемической. Алеаторическая неопределенность ( \sigma^2 ) отражает присущий шум в данных, который неизбежно присутствует даже при идеальном знании модели; это неотъемлемая часть самого процесса измерения или генерации данных. Эпистемическая неопределенность, напротив, связана с недостатком знаний у модели, то есть с ограничениями в обучении и неполнотой данных, используемых для построения модели. Оценка обоих типов неопределенности критически важна для надежной интерпретации результатов и принятия обоснованных решений, особенно в областях, где ошибки могут иметь серьезные последствия.

Для моделирования алеаторической неопределенности, связанной с присущим шумом в данных, используется обобщенное гауссовское распределение (Generalized Gaussian Distribution — GGD). Оно позволяет более гибко описывать распределение ошибок по сравнению со стандартным нормальным распределением, особенно в случаях, когда данные содержат выбросы или ненормальные шумы. Для оценки эпистемической неопределенности, возникающей из-за ограниченности знаний модели, применяется метод Монте-Карло Дропаут (Monte Carlo Dropout). Этот метод заключается в случайном отключении нейронов во время процесса предсказания, что позволяет получить несколько различных результатов для одного и того же входного изображения. Дисперсия этих результатов служит мерой эпистемической неопределенности, отражающей неуверенность модели в своих предсказаниях.

Генеративно-состязательная сеть (GAN) с управлением на основе неопределенности использует оценки как алеаторной, так и эпистемической неопределенности для итеративного улучшения процесса реконструкции изображений. В частности, оценки неопределенности используются для динамической корректировки стратегии обучения GAN, уделяя больше внимания областям изображения, где модель проявляет наибольшую неуверенность. Это достигается путем включения показателей неопределенности в функцию потерь, что позволяет сети сосредотачиваться на уменьшении неопределенности в процессе генерации, тем самым повышая как качество реконструированных изображений, так и уверенность модели в их корректности. Итеративный процесс, называемый прогрессивным, позволяет сети постепенно улучшать реконструкцию, начиная с низкого разрешения и увеличивая его по мере уменьшения неопределенности.

Подтверждение обобщения и производительности в реальных условиях

Эффективность предложенного подхода подтверждается не только результатами, полученными на обучающей выборке, но и его способностью к обобщению на независимые наборы данных, в частности, на широко известном NIH Chest X-ray Dataset. Это демонстрирует, что модель способна успешно применять полученные знания к новым, ранее не виденным изображениям, что является критически важным для практического применения в реальных клинических условиях. Способность к обобщению свидетельствует о том, что модель не просто «запоминает» обучающие данные, а действительно извлекает полезные признаки и закономерности, необходимые для точной реконструкции и анализа медицинских изображений. Такая устойчивость к новым данным повышает надежность и универсальность системы, делая ее потенциально полезной для широкого спектра задач, связанных с диагностикой заболеваний легких.

Внедрение прогрессивного обучения в структуру генеративно-состязательной сети (GAN) позволяет постепенно улучшать качество и надежность модели. Этот подход предполагает последовательное усложнение задачи обучения, начиная с простых примеров и постепенно переходя к более сложным. Такой метод позволяет сети не только эффективно усваивать информацию, но и избегать переобучения, что особенно важно при работе с медицинскими изображениями. Благодаря прогрессивному обучению, модель демонстрирует повышенную устойчивость к шумам и артефактам, а также улучшенную способность к обобщению, что напрямую влияет на точность диагностики и снижает вероятность ложных результатов. Постепенная оптимизация позволяет достичь более высокого уровня детализации и реалистичности реконструируемых изображений, что критически важно для клинического применения.

В рамках данной работы особое внимание уделено реалистичности реконструируемых изображений, достигаемой за счет использования функции потерь, названной Residual Consistency Loss. Эта функция стимулирует генерацию не только точной анатомической структуры, но и правдоподобного шума и текстуры, характерных для медицинских изображений. В отличие от подходов, фокусирующихся исключительно на структурном сходстве, Residual Consistency Loss позволяет воссоздать детали, которые важны для клинической интерпретации, такие как тонкие градации серого и незначительные артефакты, обычно присутствующие на рентгеновских снимках. Подобный подход значительно повышает визуальную достоверность реконструируемых изображений, делая их более полезными для врачей-рентгенологов и способствуя более точной диагностике.

Разработанная система представляет собой более надежный и информативный диагностический инструмент, способный значительно улучшить результаты лечения пациентов и снизить количество диагностических ошибок. Внедрение данной технологии позволяет врачам получать более четкие и детализированные изображения, что облегчает выявление даже незначительных патологий. Повышенная точность диагностики, в свою очередь, способствует более своевременному и эффективному назначению лечения, что критически важно для улучшения прогноза заболеваний. Потенциал системы заключается в снижении нагрузки на медицинский персонал и повышении качества оказываемой медицинской помощи, что делает ее перспективным направлением развития современной медицинской визуализации.

Исследование демонстрирует неизбежную диалектику между теорией и практикой. Создание синтетических рентгеновских изображений с учётом неопределённости — это попытка обуздать хаос, но всегда найдётся способ сломать даже самую элегантную модель. Авторы стремятся к надёжности и интерпретируемости, вводя понятия алеаторной и эпистемической неопределённости. Однако, как гласит известная фраза Пола Эрдеша: «Не существует красивой теоремы, которую нельзя было бы доказать ещё раз». Это отнюдь не умаляет ценность работы, но напоминает о том, что каждая «революционная» технология завтра станет техдолгом. Задача не в создании идеальной модели, а в создании компромисса, пережившего деплой.

Что дальше?

Представленный подход к генерации рентгеновских изображений в тёмном поле, безусловно, добавляет ещё один слой абстракции между физической реальностью и получаемым изображением. Каждый новый алгоритм, обещающий «улучшение» качества, неизбежно порождает новые артефакты, которые предстоит обнаруживать и исправлять. Оценка неопределённости, как алеаторной, так и эпистемической, — шаг в правильном направлении, но не стоит забывать: даже самая точная оценка погрешности не отменяет фундаментальную проблему — достоверность исходных данных.

В перспективе, вероятно, возникнет потребность в ещё более сложных генеративных моделях, способных учитывать не только статистические особенности, но и физические ограничения, присущие процессу формирования рентгеновского излучения. Но и это лишь отсрочит неизбежное: в конечном итоге, система непрерывной интеграции станет храмом, где инженеры молятся, чтобы ничего не сломалось после каждого обновления. Документация, как обычно, останется мифом, придуманным менеджерами.

Попытки количественно оценить «неопределённость» в данных — это, конечно, похвально. Однако, история показывает, что каждая «революционная» технология завтра превратится в технический долг. Вместо того, чтобы гоняться за идеальной моделью, возможно, стоит сосредоточиться на разработке более устойчивых и отказоустойчивых систем обработки изображений, способных справляться с непредсказуемыми данными без необходимости их «улучшения».

Оригинал статьи: https://arxiv.org/pdf/2601.15859.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- БИТКОИН ПРОГНОЗ. BTC криптовалюта

- ПРОГНОЗ ДОЛЛАРА К ШЕКЕЛЮ

- ЭФИРИУМ ПРОГНОЗ. ETH криптовалюта

- SOL ПРОГНОЗ. SOL криптовалюта

- SAROS ПРОГНОЗ. SAROS криптовалюта

- ДОГЕКОИН ПРОГНОЗ. DOGE криптовалюта

- РИППЛ ПРОГНОЗ. XRP криптовалюта

- FARTCOIN ПРОГНОЗ. FARTCOIN криптовалюта

- ZEC ПРОГНОЗ. ZEC криптовалюта

- ПРОГНОЗ ЕВРО К ШЕКЕЛЮ

2026-01-23 17:28