Автор: Денис Аветисян

Исследователи представляют RealHD — обширный и качественный набор данных, призванный значительно улучшить точность и надежность обнаружения изображений, сгенерированных нейросетями.

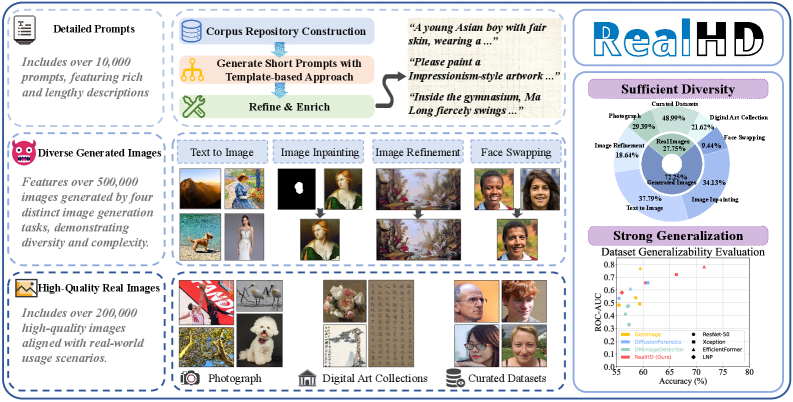

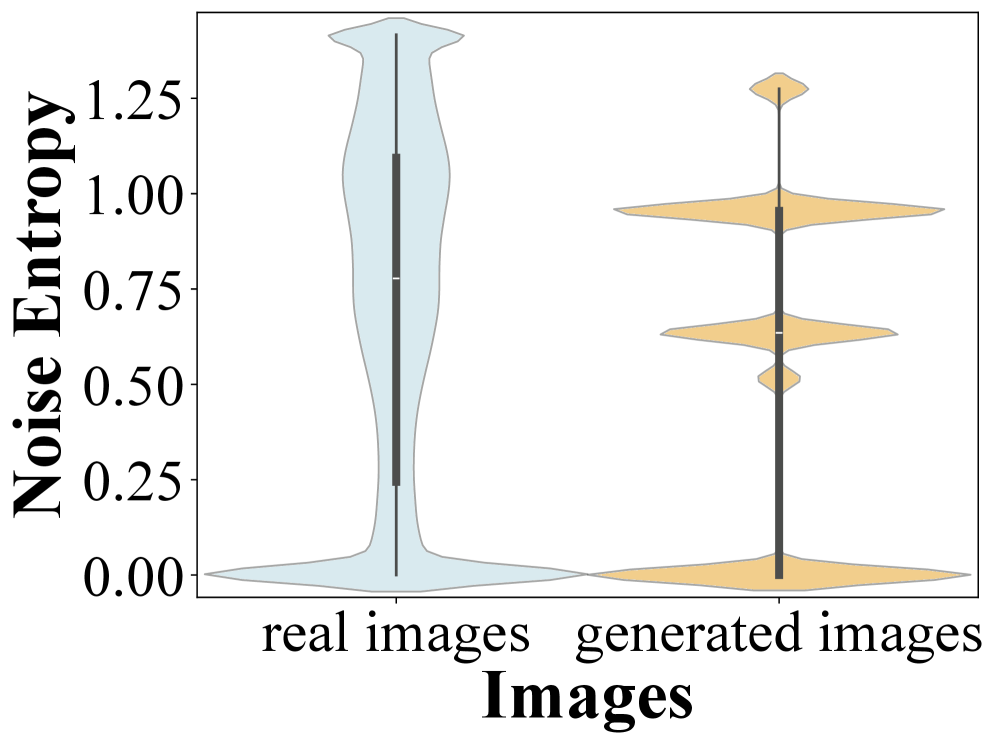

Представлен RealHD, датасет для оценки и повышения обобщающей способности методов обнаружения изображений, созданных с использованием диффузионных моделей, на основе анализа энтропии шума.

Быстрое развитие генеративных моделей искусственного интеллекта ставит под вопрос достоверность цифровых изображений и требует разработки надежных методов их аутентификации. В данной работе, представленной в статье ‘RealHD: A High-Quality Dataset for Robust Detection of State-of-the-Art AI-Generated Images’, предложен масштабный и высококачественный набор данных, предназначенный для обучения моделей, способных отличать реалистичные изображения, сгенерированные ИИ, от настоящих. Предложенный датасет, включающий более 730 000 изображений, и основанный на анализе энтропии шума, демонстрирует значительное повышение обобщающей способности моделей детектирования. Не откроет ли это новые горизонты для развития надежных методов выявления поддельных изображений и обеспечения доверия к визуальному контенту в цифровой среде?

Раскрытие Реальности: Вызовы в Эпоху AI-Генерируемых Изображений

Современные генеративные модели, такие как Stable Diffusion, демонстрируют впечатляющий прогресс в создании фотореалистичных изображений, что приводит к размытию границ между подлинными фотографиями и синтетическим контентом. Эти модели, основанные на диффузионных процессах и глубоком обучении, способны генерировать изображения с высокой степенью детализации и художественной выразительности, практически неотличимые от созданных человеком или запечатленных камерой. Сложность заключается в том, что традиционные методы обнаружения, полагающиеся на анализ артефактов сжатия или несоответствий в освещении, оказываются неэффективными против изображений, сгенерированных столь продвинутыми алгоритмами. В результате, распознавание подлинности контента становится все более сложной задачей, требующей разработки принципиально новых подходов к обнаружению манипуляций и аутентификации цифровых изображений.

Традиционные методы выявления контента, сгенерированного искусственным интеллектом, демонстрируют растущую неэффективность в связи с усовершенствованием генеративных моделей. Алгоритмы, основанные на анализе статистических артефактов или несоответствий в пиксельной структуре, всё чаще оказываются неспособными отличить реалистичные изображения, созданные нейросетями, от фотографий, сделанных человеком. Это создает серьезную потребность в разработке новых, более устойчивых методов обнаружения, использующих, например, анализ частотных характеристик, изучение метаданных или применение методов машинного обучения, способных выявлять тонкие, невидимые для человеческого глаза, признаки искусственного происхождения изображения. Разработка таких инструментов становится критически важной для борьбы с распространением дезинформации и поддержания доверия к визуальному контенту в цифровой среде.

Распространение синтетических медиа представляет собой растущую угрозу, охватывающую широкий спектр рисков — от распространения дезинформации и манипулирования общественным мнением до создания убедительных, но фальшивых изображений и видео, известных как дипфейки. Эти технологии позволяют создавать контент, который крайне сложно отличить от реальности, что подрывает доверие к визуальной информации и создает возможности для злоупотреблений в политике, экономике и социальной сфере. В связи с этим, разработка надежных методов аутентификации контента, способных достоверно определять происхождение и подлинность изображений и видео, становится критически важной задачей для обеспечения информационной безопасности и защиты от манипуляций.

RealHD: Новый Эталон для Обнаружения AI-Генерируемых Изображений

Набор данных RealHD состоит из более чем 730 000 изображений высокого качества, тщательно отобранных для обеспечения разнообразия представленных сцен и методов генерации. Курация включала в себя выбор изображений, представляющих широкий спектр объектов, освещения и композиций, а также использование различных алгоритмов генерации, включая, но не ограничиваясь, диффузионные модели и GAN. Данный подход направлен на создание комплексной и репрезентативной выборки, позволяющей адекватно оценить эффективность алгоритмов обнаружения сгенерированных изображений в различных условиях и при использовании различных технологий.

Набор данных RealHD использует генеративные модели, такие как Flux и Stable Diffusion, для создания синтетических изображений, что позволяет сформировать сложную и реалистичную тестовую среду. Использование данных, сгенерированных современными алгоритмами, гарантирует, что алгоритмы обнаружения будут испытываться на изображениях, максимально приближенных к тем, которые могут встретиться в реальных условиях. Это позволяет более точно оценить их способность различать настоящие и сгенерированные изображения, а также выявить слабые места в существующих методах.

Набор данных RealHD расширяет существующие бенчмарки, такие как GenImage и DiffusionForensics, обеспечивая более полную и надежную основу для оценки алгоритмов обнаружения сгенерированных изображений. Включение данных из этих источников, а также создание нового контента, позволяет RealHD эффективно проверять способность моделей к обобщению — то есть, к корректной работе с изображениями, созданными различными генеративными моделями и в различных условиях. Результаты тестирования на RealHD демонстрируют значительное повышение обобщающей способности моделей по сравнению с использованием только GenImage или DiffusionForensics, что подтверждает его ценность как более продвинутого эталона.

Различение Реальности: Методы Обнаружения Синтетических Изображений

Алгоритмы, такие как LNP (Learned Noise Patterns), используют изученные паттерны шума для разграничения реальных и сгенерированных изображений. В основе метода лежит предположение, что реальные изображения содержат уникальные шумовые характеристики, обусловленные особенностями сенсоров и процессов обработки, в то время как сгенерированные изображения, как правило, демонстрируют отличные от них паттерны шума. LNP анализирует статистические свойства шума в изображении и сравнивает их с предварительно изученными характеристиками реальных и сгенерированных изображений, позволяя таким образом выявлять признаки синтетического контента. Эффективность данного подхода зависит от качества обучения модели и разнообразия обучающей выборки, охватывающей различные типы реальных и сгенерированных изображений.

Метод анализа взаимосвязей соседних пикселей (NPR) основан на изучении локальных структур изображения для выявления несоответствий, характерных для синтетического контента. Данный подход предполагает, что в реальных изображениях наблюдается определенная статистическая закономерность в распределении значений соседних пикселей, обусловленная физическими процессами формирования изображения. В синтетических изображениях, созданных генеративными моделями, эта закономерность может нарушаться, проявляясь в виде аномалий в корреляции значений соседних пикселей или неестественных переходов между ними. Анализ NPR позволяет выявлять эти аномалии, предоставляя информацию о вероятной искусственности изображения.

При оценке эффективности алгоритма Xception для обнаружения синтетических изображений, наблюдается значительная разница в точности в зависимости от используемого набора данных. На наборе GenImage Xception демонстрирует высокую точность — 99.00%, однако при использовании более сложного набора RealHD точность снижается до 85.21%. Для повышения эффективности обнаружения предлагается интеграция метода анализа энтропии шума с архитектурой Xception, что позволяет увеличить точность на 15.90 процентных пункта и улучшить показатель AUC на 5.00 единиц. Данные результаты подчеркивают необходимость разработки и применения более устойчивых методов для выявления синтетических изображений в условиях повышенной сложности.

Надежность и Обобщение: Обеспечение Достоверного Обнаружения

Для оценки устойчивости алгоритмов обнаружения к реальным условиям эксплуатации, применяется намеренная деградация изображений с использованием методов сжатия, таких как JPEG. Этот подход позволяет имитировать потерю качества, возникающую при передаче и хранении изображений в повседневных сценариях. Применение JPEG-компрессии с различными степенями сжатия позволяет оценить, насколько хорошо алгоритм сохраняет точность обнаружения объектов при снижении разрешения и появлении артефактов. Использование подобных тестов позволяет выявить слабые места в алгоритмах и разработать более надежные решения, способные эффективно работать даже с изображениями низкого качества, что критически важно для практического применения в различных областях, включая системы видеонаблюдения и автоматизированный анализ изображений.

Для повышения реалистичности и сложности синтетических изображений, используемых в обучении алгоритмов обнаружения, применяются методы восстановления изображений, такие как Image Inpainting и Image Refinement. Image Inpainting позволяет воссоздавать недостающие или поврежденные части изображения, делая его более правдоподобным. В свою очередь, Image Refinement направлен на улучшение качества уже существующего изображения, устраняя артефакты и повышая детализацию. Сочетание этих методов создает синтетические данные, максимально приближенные к реальным условиям, что позволяет алгоритмам лучше обобщать полученные знания и демонстрировать более надежную работу в сложных ситуациях, например, при плохом освещении или частичной окклюзии объектов.

Исследования, сравнивающие производительность FatFormer и SAAN с базовыми моделями, выявили значительный потенциал для повышения точности обнаружения и оценки эстетических характеристик изображений. Особого внимания заслужили результаты, полученные на наборе данных RealHD, который продемонстрировал наивысшие баллы по эстетике при оценке с использованием SAAN. Это свидетельствует о превосходном качестве генерируемых изображений и способности SAAN более точно оценивать их визуальную привлекательность, что открывает новые возможности для применения в областях, требующих высокой реалистичности и эстетической ценности контента.

Перспективы Развития: К Универсальной Аутентификации Контента

Дальнейшее изучение методов обнаружения, основанных на анализе шума изображения, представляется перспективным направлением в борьбе с манипуляциями цифрового контента. Исследования, использующие энтропию изображения и алгоритм Non-Local Means (NLM), демонстрируют потенциал в выявлении следов редактирования и подделок, поскольку любой процесс изменения изображения неизбежно вносит изменения в структуру шума. Особенный интерес представляет возможность использования уникальных “отпечатков” шума, формирующихся при захвате изображения сенсором камеры, для подтверждения его подлинности. Углубленное изучение характеристик этих “отпечатков” и разработка алгоритмов, устойчивых к различным видам обработки, могут привести к созданию более надежных и эффективных инструментов для аутентификации цифрового контента и защиты от распространения дезинформации.

Современные технологии манипулирования изображениями и видео, в частности, технология “face swapping” (подмена лиц), представляют серьезную угрозу для достоверности визуальной информации. Исследования показывают, что отличить подлинное изображение от искусно созданного фейка становится все сложнее, что ведет к распространению дезинформации и подрыву доверия к визуальным источникам. Разработка эффективных методов обнаружения подобных манипуляций, основанных на анализе мельчайших артефактов, несоответствий освещения или анатомических неточностей, становится критически важной задачей. Успешное решение этой проблемы позволит не только идентифицировать сфабрикованные изображения, но и предотвратить их дальнейшее распространение, обеспечивая тем самым целостность визуального контента и защиту от манипуляций.

Разработка универсальных стандартов аутентификации контента представляется критически важной задачей в эпоху стремительного развития технологий создания синтетических медиа. Для эффективной борьбы с распространением дезинформации и подделок необходим согласованный подход к проверке подлинности цифровых материалов. Ключевым элементом в реализации этой концепции является создание всеобъемлющих датасетов, таких как RealHD, предоставляющих широкий спектр реальных и синтезированных изображений и видео. Эти датасеты служат основой для обучения алгоритмов обнаружения манипуляций, позволяя им различать подлинный контент от поддельного с высокой точностью. Внедрение единых стандартов, основанных на таких датасетах, обеспечит возможность верификации контента различными платформами и инструментами, тем самым значительно повышая уровень доверия к цифровой информации и защищая общество от потенциальных рисков, связанных с распространением фейковых новостей и дипфейков.

Исследование демонстрирует важность анализа закономерностей в данных для повышения эффективности систем обнаружения. Как отмечает Джеффри Хинтон: «Попытки создать совершенные системы искусственного интеллекта обречены на неудачу, если мы не поймем, как данные влияют на их работу». Представленный датасет RealHD и предложенный метод, основанный на анализе энтропии шума, служат ярким примером этого принципа. Внимательное изучение характеристик шума, генерируемого различными моделями, позволяет более точно выявлять искусственно созданные изображения и значительно улучшает обобщающую способность алгоритмов, что особенно важно в контексте быстрого развития diffusion models и необходимости надежных инструментов для image forensics.

Куда двигаться дальше?

Представленный набор данных RealHD, подобно микроскопу, позволяет рассмотреть детали, ранее скрытые в потоке искусственно сгенерированных изображений. Однако, увеличение разрешения не всегда означает полное понимание. Очевидно, что текущие методы, основанные на анализе энтропии шума, демонстрируют улучшенную обобщающую способность, но это лишь один аспект сложной проблемы. Неизбежно возникнет вопрос о создании “контр-шума” — алгоритмов, способных намеренно искажать следы генерации, маскируя искусственное происхождение изображений.

Более глубокое исследование требует смещения фокуса с обнаружения артефактов к пониманию фундаментальных различий между “естественным” и “искусственным” восприятием. Необходимо учитывать не только статистические особенности, но и семантические несоответствия, контекстуальные аномалии, которые могут указывать на манипуляцию. Подобный подход требует интеграции методов компьютерного зрения с когнитивной психологией и даже философией изображения.

В конечном счете, задача обнаружения AI-генерированных изображений — это не просто техническая головоломка, а отражение нашей собственной способности к критическому мышлению и распознаванию реальности. И, подобно любому инструменту познания, эта область исследований будет развиваться, пока существует потребность в отделении истины от иллюзии.

Оригинал статьи: https://arxiv.org/pdf/2602.10546.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- БИТКОИН ПРОГНОЗ. BTC криптовалюта

- ПРОГНОЗ ДОЛЛАРА К ШЕКЕЛЮ

- ЭФИРИУМ ПРОГНОЗ. ETH криптовалюта

- SOL ПРОГНОЗ. SOL криптовалюта

- РИППЛ ПРОГНОЗ. XRP криптовалюта

- ДОГЕКОИН ПРОГНОЗ. DOGE криптовалюта

- SAROS ПРОГНОЗ. SAROS криптовалюта

- SUI ПРОГНОЗ. SUI криптовалюта

- FARTCOIN ПРОГНОЗ. FARTCOIN криптовалюта

- HYPE ПРОГНОЗ. HYPE криптовалюта

2026-02-12 17:26