Автор: Денис Аветисян

Новое исследование показывает, что, вопреки распространенному мнению, активные атаки инверсии градиента в федеративном обучении могут быть надежно обнаружены непосредственно клиентами.

Ищешь ракеты? Это не к нам. У нас тут скучный, медленный, но надёжный, как швейцарские часы, фундаментальный анализ.

Бесплатный Телеграм канал

Анализ поведения модели и статистических аномалий позволяет выявлять активные атаки инверсии градиента (GIA) и обеспечивать защиту данных в федеративном обучении.

Несмотря на заявленные преимущества федеративного обучения в плане конфиденциальности, обмен градиентами между участниками может быть уязвим для атак инверсии градиента. В работе ‘On the Detectability of Active Gradient Inversion Attacks in Federated Learning’ проводится всесторонний анализ современных активных атак данного типа, в которых злоумышленник манипулирует глобальной моделью для восстановления локальных данных клиентов. Исследование показывает, что, вопреки утверждениям о скрытности, эти атаки обнаружимы на стороне клиента путем анализа статистически маловероятных структур весов и аномалий в динамике потерь и градиентов. Смогут ли предложенные методы клиентской детекции обеспечить надежную защиту от атак инверсии градиента в реальных сценариях федеративного обучения?

Эволюция Угроз: Федеративное Обучение и Атаки на Конфиденциальность

Распределенное машинное обучение, в частности федеративное обучение (FL), представляет перспективный подход к сохранению конфиденциальности данных. Однако FL вносит новые уязвимости, связанные с обменом моделями между участниками. Атаки восстановления градиента (GIA) используют эти обновления для реконструкции конфиденциальных данных, подрывая приватность. В отличие от традиционных угроз, GIA эксплуатируют структуру алгоритма обучения. Традиционные механизмы обеспечения приватности часто недостаточны для противодействия сложным атакам GIA, требуя новых методов защиты. Защита должна адаптироваться, подобно течению времени, стремящемуся к старению любой системы.

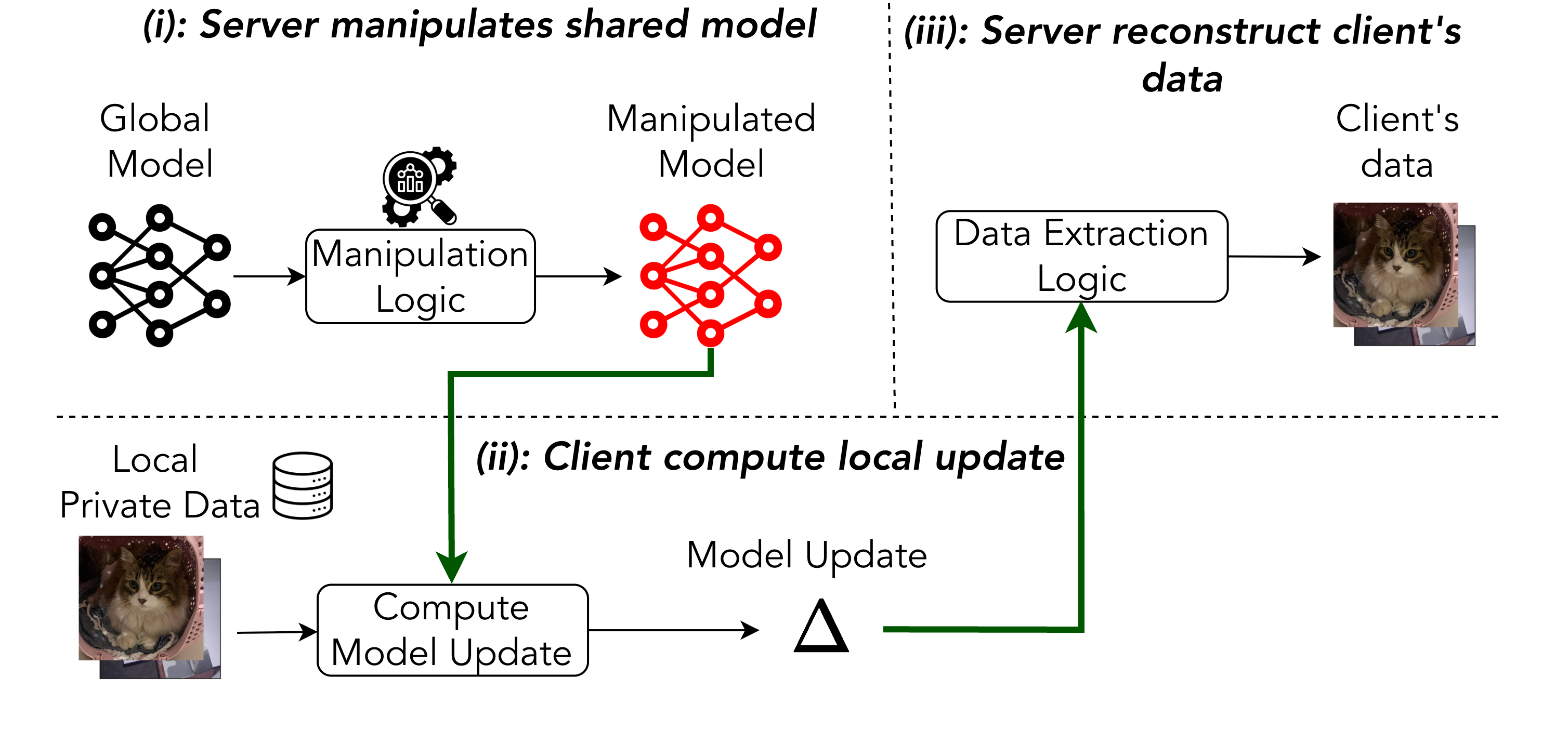

Пассивные и Активные Атаки: Спектр Угроз

Пассивные GIA, ограничиваясь наблюдением градиентов, представляют собой базовую модель угроз в FL. Активные GIA, напротив, активно манипулируют глобальной моделью для повышения способности к реконструкции данных. Техники, такие как Binning Property Attack и Paired Weight Attack, стратегически изменяют параметры модели, что может привести к утечке информации или ухудшению производительности. Эффективность этих атак подчеркивает необходимость надежных механизмов защиты от злонамеренных манипуляций.

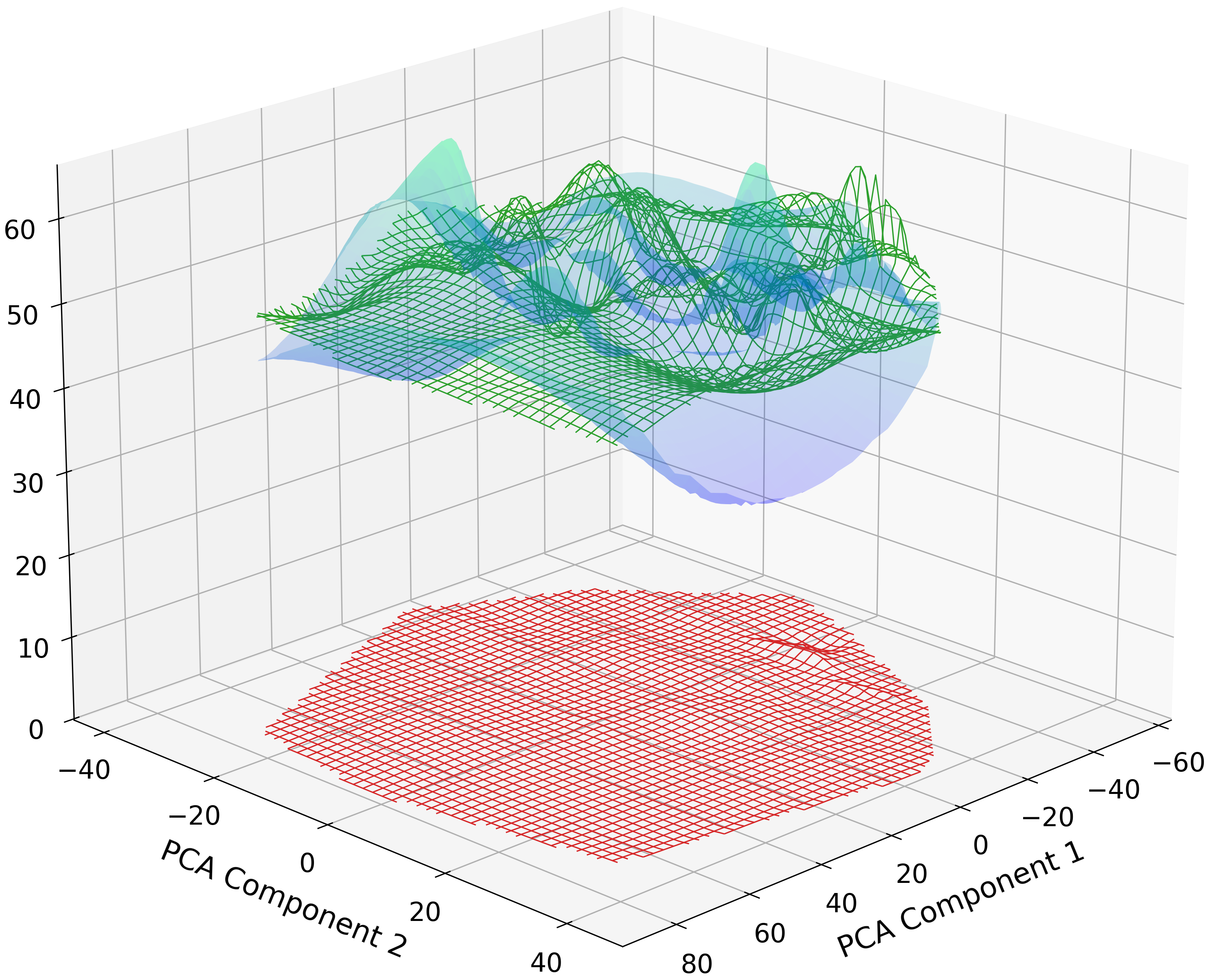

![Визуализация потери разнообразия нейронов с помощью 3D PCA показывает, что доброкачественные нейроны (синий цвет) формируют рассеянное облако, указывающее на разнообразие признаков, в то время как все нейроны модели, подвергшиеся манипуляциям согласно Shi et al. [14], коллапсируют в единую точку (красный цвет), демонстрируя, что атака заставляет нейроны приобретать идентичные представления.](https://arxiv.org/html/2511.10502v1/figures/neuron_diversity.png)

Выявление Манипуляций: Методы Обнаружения

Анализ функции потерь и характеристик градиента – перспективное направление для обнаружения атак на модели машинного обучения (GIAs). Исследование аномального поведения модели позволяет выявить манипуляции. Анализ расхождений модели предполагает сравнение последовательных обновлений для выявления значительных отклонений. Эти методы анализируют различные аспекты процесса обучения для дифференциации между законными обновлениями и злонамеренными манипуляциями, способствуя повышению устойчивости и безопасности.

Передовые Атаки и Ограничения Современных Метрик

Современные атаки, использующие генеративный ИИ (GIAs), такие как SEER и Geminio, демонстрируют повышенную сложность. Эти системы применяют усовершенствованные стратегии для целенаправленной реконструкции данных, превосходя простые атаки. Они используют секретную дезагрегацию и запросы на естественном языке, обходя стандартные механизмы защиты. Распространенные метрики скрытности, такие как D-SNR, оказались неэффективными при оценке этих атак, указывая на необходимость разработки более надежных критериев оценки.

![ROC-кривая, оценивающая производительность детектора в настройке Cross-Silo с использованием ResNet18 под атакой Shi et al. [14], демонстрирует эффективность обнаружения манипуляций.](https://arxiv.org/html/2511.10502v1/figures/roc_curve.png)

Надежное Федеративное Обучение: Перспективы Развития

Представленная работа демонстрирует эффективное обнаружение вредоносных обновлений на стороне клиента (AUC 0.9741). Метод характеризуется низким уровнем ложноположительных срабатываний (FPR 0.037) и почти полным уровнем истинноположительных срабатываний (TPR ~1.0). Рекомендуется исследовать более надежные алгоритмы агрегации (FedSGD, FedAVG) и применение дифференциальной приватности и безопасных вычислений с участием нескольких сторон. Разработка адаптивных механизмов защиты, способных динамически реагировать на меняющиеся стратегии атак, имеет решающее значение. Подобно тому, как время выявляет скрытые дефекты любой структуры, эти методы обнажают уязвимости в кажущейся безопасности распределенных систем.

Исследование показывает, что даже кажущиеся невидимыми активные атаки инверсии градиента (GIA) в федеративном обучении могут быть выявлены клиентами посредством анализа поведения модели и статистических аномалий. Это подтверждает идею о том, что системы, пусть и со временем подвергающиеся изменениям, способны демонстрировать признаки своей деградации или атак. Как однажды заметил Пол Эрдёш: «Математика – это не игра, в которой нужно быть умным, а искусство быть терпеливым». Подобно терпеливому математику, анализирующему сложные уравнения, клиенты в федеративном обучении могут выявить скрытые угрозы, наблюдая за изменениями в модели и выявляя отклонения от нормы. Задержка в обнаружении этих атак, как и задержка в исправлении ошибок, является своего рода налогом на амбиции – амбиции построить надежную и безопасную систему федеративного обучения.

Что впереди?

Представленная работа демонстрирует, что даже самые изощренные атаки, стремящиеся к незаметному извлечению данных в условиях федеративного обучения, оставляют следы. Эти следы, подобно отпечаткам на песке времени, обнаруживаются благодаря внимательному анализу поведения модели. Однако, подобно тени, атаки эволюционируют, и совершенствование методов обнаружения становится непрерывной гонкой. Важно понимать, что версионирование моделей – это не просто техническая необходимость, но и форма памяти, позволяющая отследить изменения и выявить аномалии, сигнализирующие о несанкционированном вмешательстве.

Очевидно, что акцент должен быть смещен с пассивного обнаружения атак на активные методы противодействия. Необходимо исследовать возможности динамической адаптации моделей, способных нейтрализовать угрозы на ранних стадиях. Стрела времени всегда указывает на необходимость рефакторинга – устаревшие методы защиты становятся уязвимыми. Изучение методов дифференциальной приватности и гомоморфного шифрования представляется перспективным направлением, однако их практическая реализация требует значительных вычислительных ресурсов и компромиссов в отношении точности модели.

В конечном счете, задача защиты данных в условиях федеративного обучения – это не столько техническая проблема, сколько философский вопрос о балансе между приватностью, точностью и вычислительной эффективностью. Все системы стареют – вопрос лишь в том, делают ли они это достойно, сохраняя конфиденциальность и надежность данных в изменчивом потоке времени.

Оригинал статьи: https://arxiv.org/pdf/2511.10502.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- БИТКОИН ПРОГНОЗ. BTC криптовалюта

- ПРОГНОЗ ДОЛЛАРА К ШЕКЕЛЮ

- ЭФИРИУМ ПРОГНОЗ. ETH криптовалюта

- SOL ПРОГНОЗ. SOL криптовалюта

- ZEC ПРОГНОЗ. ZEC криптовалюта

- SAROS ПРОГНОЗ. SAROS криптовалюта

- STRK ПРОГНОЗ. STRK криптовалюта

- ДОГЕКОИН ПРОГНОЗ. DOGE криптовалюта

- FARTCOIN ПРОГНОЗ. FARTCOIN криптовалюта

- ПРОГНОЗ ЕВРО К ШЕКЕЛЮ

2025-11-14 18:00