Автор: Денис Аветисян

Новый подход позволяет отслеживать намерения пользователя в диалоге и выявлять сложные, многоходовые попытки обмануть или спровоцировать языковую модель.

Предложена система DeepContext, использующая рекуррентные нейронные сети для отслеживания контекста и обнаружения изменений в намерениях пользователя в многооборотном взаимодействии.

Несмотря на значительный прогресс в возможностях больших языковых моделей (LLM), существующие механизмы защиты зачастую не учитывают контекст многооборотного диалога. В статье ‘DeepContext: Stateful Real-Time Detection of Multi-Turn Adversarial Intent Drift in LLMs’ представлен новый подход к обнаружению скрытых злонамеренных намерений, проявляющихся в последовательности запросов. Разработанная система DeepContext, использующая рекуррентные нейронные сети для отслеживания эволюции намерений пользователя, демонстрирует превосходство над статичными решениями, достигая F1-оценки 0.84. Не откроет ли учет временной динамики запросов путь к созданию более надежных и эффективных систем безопасности для LLM?

Взломщики учатся говорить: угроза многоходовых атак

Современные большие языковые модели (БЯМ) становятся все более уязвимыми для сложных атак, особенно тех, которые разворачиваются в несколько этапов диалога. В отличие от простых, однократных попыток обмана, многоходовые атаки позволяют злоумышленникам постепенно, незаметно манипулировать моделью, обходя встроенные механизмы защиты. Данный подход основан на постепенном внедрении вредоносного контекста в беседу, что позволяет обойти фильтры, настроенные на выявление явных признаков опасного контента. Уязвимость возрастает, поскольку БЯМ, как правило, ориентированы на поддержание связного диалога, что делает их восприимчивыми к тонким изменениям в контексте, направленным на достижение нежелаемого результата. Подобные атаки представляют серьезную угрозу, поскольку могут приводить к генерации дезинформации, разжиганию ненависти или даже раскрытию конфиденциальной информации.

Традиционные механизмы безопасности, применяемые к большим языковым моделям, зачастую рассматривают каждое взаимодействие как отдельное событие, не учитывая контекст предыдущих реплик. Это создает существенную уязвимость, поскольку злоумышленники могут постепенно, в течение нескольких раундов диалога, незаметно подтолкнуть модель к генерации вредоносного или нежелательного контента. Подобная стратегия, известная как многоходовая атака, обходит стандартные фильтры, которые эффективны лишь при анализе единичных запросов. Модель, не способная отслеживать и анализировать всю историю беседы, становится восприимчивой к манипуляциям, которые в отдельности могут казаться безобидными, но в совокупности приводят к непредсказуемым и опасным результатам. Таким образом, игнорирование контекста диалога существенно ослабляет защиту больших языковых моделей от целенаправленных атак.

Бесполезные заплатки: ограничения существующих защит

Бессодержательные защиты, такие как конкатенация истории переписки (Transcript Concatenation), предпринимают попытки противодействия многооборотным атакам путем повторной передачи всей истории диалога модели. Однако данный подход характеризуется значительными вычислительными затратами и неэффективностью. Передача полного контекста с каждым новым запросом требует больших объемов памяти и процессорного времени, что снижает скорость обработки и увеличивает стоимость развертывания. Эффективность метода обратно пропорциональна длине диалога, что делает его неприменимым в сценариях с продолжительными беседами. В результате, несмотря на кажущуюся простоту реализации, конкатенация истории переписки не является масштабируемым решением для защиты от многооборотных атак.

Подход, основанный на последовательной передаче полной истории диалога, страдает от принципиального недостатка — неспособности к пониманию эволюции намерений в ходе беседы. Простое наращивание контекста не позволяет модели выявлять изменения в целях пользователя и, как следствие, эффективно противостоять манипуляциям. Модель обрабатывает каждое новое сообщение как изолированное, не учитывая предшествующую динамику и возможные скрытые цели, что делает её уязвимой для атак, направленных на постепенное изменение поведения.

Атаки, такие как Crescendo Attack и Foot-In-The-Door (FITD), используют уязвимость, связанную с постепенным изменением поведения языковой модели (LLM) в течение многооборотного диалога. Crescendo Attack характеризуется последовательным увеличением интенсивности запросов, направленных на обход защитных механизмов. Foot-In-The-Door (FITD) же, напротив, начинается с безобидных запросов, постепенно усложняя их и внедряя вредоносные инструкции. Обе стратегии эксплуатируют неспособность существующих безсодержательных защит (например, конкатенации истории диалога) к адекватному отслеживанию и интерпретации меняющегося намерения пользователя, что позволяет злоумышленнику незаметно манипулировать LLM и достигать поставленных целей.

DeepContext: отслеживание намерений во времени

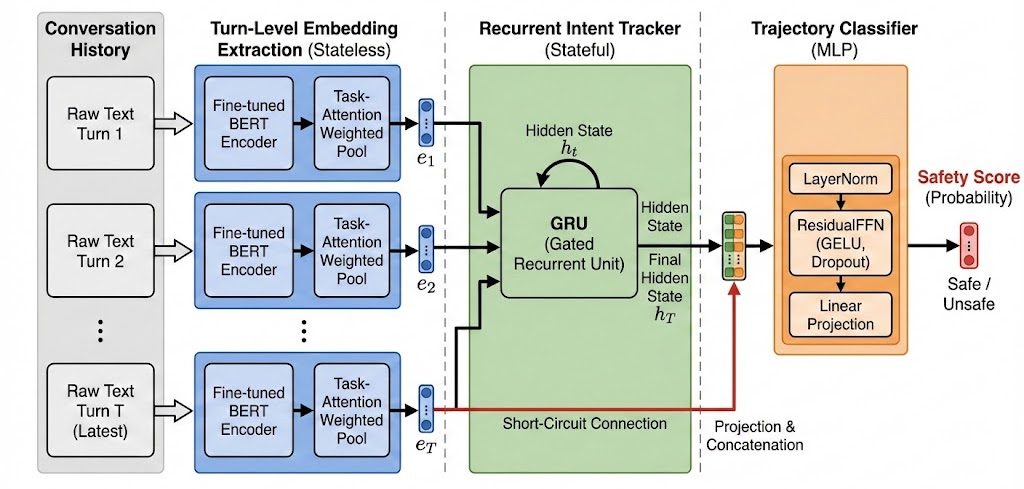

В основе DeepContext лежит рекуррентная нейронная сеть (RNN), используемая для поддержания устойчивого скрытого состояния, отражающего контекст текущего диалога. Это скрытое состояние служит своего рода «памятью» системы, позволяя ей учитывать предыдущие реплики пользователя и сохранять информацию о развитии беседы. В отличие от моделей, обрабатывающих каждое высказывание изолированно, RNN обеспечивает последовательную обработку информации, что критически важно для понимания многооборотного диалога и отслеживания изменений в намерениях пользователя на протяжении всей беседы. Постоянное обновление этого скрытого состояния на каждом шаге позволяет системе учитывать долгосрочные зависимости и строить более точные прогнозы относительно текущих и будущих реплик.

В DeepContext для эффективного отслеживания контекста диалога и выявления изменений в намерении пользователя (так называемого «смещения намерения» или Intent Drift) используется рекуррентная нейронная сеть (RNN) с блоками Gated Recurrent Units (GRU). GRU представляют собой упрощенную версию LSTM, что позволяет снизить вычислительные затраты и ускорить обучение модели без существенной потери точности. Использование GRU позволяет сети сохранять информацию о предыдущих репликах в скрытом состоянии, которое обновляется с каждой новой репликой, что обеспечивает учет долгосрочного контекста и выявление даже незначительных изменений в цели пользователя.

В основе DeepContext лежит использование взвешенных вложений с механизмом внимания к задачам (Task-Attention Weighted Embeddings). Данный подход позволяет системе приоритизировать релевантные политики безопасности и семантические токены, что существенно повышает эффективность обнаружения попыток обхода ограничений в многооборотном диалоге. В ходе тестирования DeepContext продемонстрировал передовые результаты, достигнув показателя F1 в 0.84 при обнаружении многошаговых атак, направленных на обход системы безопасности.

Повышенная надежность и горизонты развития

DeepContext знаменует собой важный шаг в развитии концепции “Stateful Defense” — защиты, учитывающей контекст диалога. В отличие от традиционных, “stateless” подходов, которые анализируют каждый запрос изолированно, DeepContext стремится к более глубокому пониманию динамики беседы. Это достигается за счет сохранения и анализа истории взаимодействия, что позволяет системе более точно идентифицировать вредоносные запросы, замаскированные под естественную речь. Такой подход позволяет не просто реагировать на текущий запрос, но и предвидеть потенциальные атаки, основываясь на предыдущем поведении пользователя и эволюции диалога. В результате, система демонстрирует повышенную устойчивость к сложным и адаптивным атакам, которые легко обходят “stateless” механизмы защиты, представляя собой более надежное решение для обеспечения безопасности в интерактивных системах.

Современные автоматизированные атаки, такие как AutoAdv, демонстрируют растущую сложность и изощренность в обходе систем защиты диалоговых моделей. Однако, представленная система DeepContext показала значительную эффективность в противодействии этим угрозам, достигнув среднего времени обнаружения (MTTD) в 4.24 хода диалога. Этот показатель существенно ниже, чем у других протестированных моделей, что свидетельствует о более высокой устойчивости DeepContext к автоматизированным атакам и ее способности оперативно выявлять и нейтрализовать враждебные манипуляции в ходе беседы. Данный результат подчеркивает важность разработки систем, способных быстро адаптироваться к новым векторам атак и обеспечивать надежную защиту в динамичной среде диалоговых взаимодействий.

Система DeepContext демонстрирует впечатляющую производительность, обеспечивая задержку менее 20 миллисекунд при использовании GPU T4, что подтверждает её пригодность для приложений, требующих обработки в реальном времени. Наряду с этим, система достигает показателя F1 в 0.84, превосходя существующие методы защиты от атак на диалоговые системы. В дальнейшем планируется усовершенствовать механизмы внимания, используемые DeepContext, и исследовать более эффективные способы поддержания и интерпретации контекста беседы, что позволит ещё больше повысить надежность и оперативность системы в условиях постоянно усложняющихся угроз.

В этой работе описывается DeepContext, система, отслеживающая намерения пользователя в многоходовом диалоге. Идея, конечно, не нова, но реализация — типичный пример того, как сложные вещи усложняются. Авторы пытаются защитить большие языковые модели от атак, отслеживая изменение намерений. Вспоминается известная фраза Линуса Торвальдса: «Если у вас нет времени на автоматическое тестирование, у вас не будет времени на отладку». Здесь та же история: попытка заранее отследить злонамеренные запросы, чтобы избежать последствий. DeepContext — это, по сути, автоматизированное тестирование намерений, и, скорее всего, всегда найдётся способ обойти эту систему, как и любую другую. Безопасность — это бесконечная гонка вооружений, и каждая «революционная» защита завтра станет лишь очередным элементом техдолга.

Что дальше?

Представленный подход, отслеживающий намерения пользователя посредством рекуррентных нейронных сетей, безусловно, добавляет ещё один уровень сложности в вечную гонку между защитой и атакой. Однако, следует помнить: каждая «государственная» система неизбежно накапливает технический долг. Сохранение контекста — это лишь временное решение, поскольку противники всегда найдут способ обойти механизм отслеживания или использовать накопленную информацию против системы. Улучшение обнаружения многоходовых атак — это хорошо, но не стоит забывать, что главная проблема заключается в самой архитектуре больших языковых моделей, склонных к генерации правдоподобной, но дезинформирующей информации.

Очевидно, что внимание сместится в сторону более эффективных методов обучения моделей устойчивости к атакам, а не просто обнаружения последствий. Необходимо исследовать способы интеграции механизмов отслеживания намерений непосредственно в процесс обучения, а не как отдельный модуль защиты. Нам не нужно больше микросервисов для отслеживания контекста — нам нужно меньше иллюзий относительно способности моделей понимать истинные намерения пользователя.

В конечном итоге, представленное исследование — это ещё один шаг на пути к созданию более безопасных больших языковых моделей, но это лишь временная передышка. Следует признать, что любая архитектура со временем превращается в анекдот, а постоянное совершенствование методов защиты — это бесконечный процесс, обреченный на повторение.

Оригинал статьи: https://arxiv.org/pdf/2602.16935.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- ПРОГНОЗ ДОЛЛАРА К ШЕКЕЛЮ

- БИТКОИН ПРОГНОЗ. BTC криптовалюта

- ЭФИРИУМ ПРОГНОЗ. ETH криптовалюта

- SOL ПРОГНОЗ. SOL криптовалюта

- РИППЛ ПРОГНОЗ. XRP криптовалюта

- SAROS ПРОГНОЗ. SAROS криптовалюта

- ДОГЕКОИН ПРОГНОЗ. DOGE криптовалюта

- OM ПРОГНОЗ. OM криптовалюта

- SUI ПРОГНОЗ. SUI криптовалюта

- FARTCOIN ПРОГНОЗ. FARTCOIN криптовалюта

2026-02-22 02:38