Автор: Денис Аветисян

Новое исследование показывает, что способность больших языковых моделей эффективно выявлять фишинговые атаки сильно зависит от качества и разнообразия обучающих данных.

Читаем отчёты, пьём кофе, ждём дивиденды. Если тебе надоел хайп и ты ищешь скучную, но стабильную гавань — добро пожаловать.

Бесплатный Телеграм канал

Кросс-архитектурный анализ выявил причины обобщения неудач в моделях, обученных для обнаружения фишинга, и продемонстрировал возможности интерпретируемых методов, таких как SHAP и анализ внимания.

Несмотря на впечатляющие успехи в специализированных задачах, большие языковые модели (LLM) часто демонстрируют хрупкость при обобщении на новые данные. В работе «Диагностика сбоев обобщения в тонко настроенных LLM: кросс-архитектурное исследование на задаче обнаружения фишинга» представлен многоуровневый диагностический фреймворк, позволяющий выявить причины этих сбоев. Исследование показывает, что разнообразие данных и архитектура модели играют ключевую роль в достижении надежного обобщения, а также выявляет специфические уязвимости отдельных архитектур. Можно ли разработать универсальную методологию валидации, учитывающую взаимосвязь между архитектурой, данными и стратегией обучения для создания действительно надежного искусственного интеллекта?

Хрупкость тонкой настройки: Корень проблемы

Несмотря на впечатляющие возможности, демонстрируемые большими языковыми моделями (LLM), они остаются уязвимыми к обобщающим ошибкам при столкновении с незнакомыми данными. Способность LLM генерировать связный и правдоподобный текст не гарантирует надежную работу в условиях, отличающихся от тех, на которых они обучались. Эта проблема возникает из-за того, что модели часто опираются на статистические закономерности в обучающих данных, а не на истинное понимание языка и мира. В результате, даже незначительные отклонения во входных данных могут приводить к непредсказуемым и ошибочным результатам, что ограничивает их применимость в реальных задачах, требующих надежной и адаптивной работы с информацией.

Стандартная процедура дообучения больших языковых моделей, несмотря на свою эффективность в начальной адаптации к новым задачам, часто приводит к созданию хрупких моделей, уязвимых к изменениям в данных и намеренно искаженным текстам. Данное явление обусловлено тем, что модель чрезмерно полагается на поверхностные закономерности в обучающем наборе, не развивая устойчивых навыков логического мышления и обобщения. В результате, даже незначительные отклонения в структуре или стиле входных данных, например, переход к другому домену или появление небольших изменений в тексте, могут существенно снизить производительность модели и привести к непредсказуемым ошибкам. Эта проблема особенно актуальна в реальных приложениях, где данные часто являются шумными и непостоянными, что требует разработки более надежных и устойчивых методов обучения.

Уязвимость больших языковых моделей, несмотря на их впечатляющие способности, объясняется склонностью к чрезмерной зависимости от поверхностных закономерностей в данных. Вместо глубокого понимания смысла и контекста, модели часто выучивают статистические связи между словами, что делает их хрупкими перед незначительными изменениями во входных данных или переходом к новым предметным областям. Отсутствие развитых способностей к логическому выводу и абстрактному мышлению не позволяет моделям обобщать знания и эффективно справляться с задачами, требующими критического анализа и применения принципов рассуждения. В результате, даже небольшие отклонения от привычных паттернов могут приводить к существенным ошибкам и непредсказуемым результатам, ограничивая надежность и применимость этих моделей в реальных сценариях.

Анализ корпусов данных, таких как электронная переписка Enron и фишинговые письма, выявил значительный уровень шума в разметке — от 17 до 22 процентов. Данный феномен, когда метки классов присвоены неверно или неоднозначно, существенно усугубляет проблемы обобщения в больших языковых моделях. Ошибочная разметка заставляет модель учиться на ложных корреляциях, что приводит к снижению надежности и предсказуемости результатов, особенно при работе с данными, отличающимися от тренировочного набора. В итоге, модели, обученные на зашумленных данных, демонстрируют хрупкость и уязвимость в реальных приложениях, где точность и надежность имеют первостепенное значение.

Стратегии повышения устойчивости: За рамками стандартной тонкой настройки

Аугментация данных представляет собой метод улучшения обобщающей способности моделей путем искусственного расширения обучающего набора данных и увеличения его разнообразия. Этот подход заключается в создании модифицированных версий существующих данных, например, путем применения случайных преобразований к изображениям (повороты, масштабирование, изменения яркости) или внесения незначительных изменений в текст (синонимизация, перефразирование). Цель состоит в том, чтобы модель столкнулась с большим количеством вариаций входных данных, что позволяет ей лучше адаптироваться к новым, ранее не встречавшимся примерам и снизить риск переобучения. Эффективность аугментации данных напрямую зависит от выбора подходящих преобразований, соответствующих специфике задачи и типу данных.

Метод обучения с учебным планом (Curriculum Learning) предполагает постепенное увеличение сложности обучающих примеров в процессе тренировки модели. Изначально модель обучается на простых примерах, что позволяет ей быстрее освоить базовые закономерности и избежать переобучения на сложных, но редких данных. По мере улучшения производительности модели, сложность примеров увеличивается, что способствует более эффективному обобщению и повышению устойчивости к шуму и вариациям в данных. Такой подход позволяет модели последовательно строить знания, что приводит к более надежному и робастному обучению, особенно в задачах с высокой сложностью или ограниченным объемом размеченных данных.

Предварительное обучение с адаптацией к домену (Domain-Adaptive Pre-training) использует неразмеченные данные из целевой области применения для уменьшения расхождения между распределениями данных, на которых модель обучается, и данными, которые она будет обрабатывать в процессе эксплуатации. Этот подход позволяет модели лучше обобщать знания на новые, специфичные для целевого домена примеры, улучшая производительность в условиях, отличных от исходных данных обучения. Процесс заключается в продолжении предварительного обучения модели на большом корпусе неразмеченных данных, релевантных целевой области, что позволяет ей адаптировать свои представления к особенностям этой области без необходимости ручной разметки данных.

Методика QLoRA (Quantization-aware Low-Rank Adaptation) позволяет проводить адаптацию больших языковых моделей (LLM) с минимальными вычислительными затратами. В отличие от стандартной тонкой настройки, которая обновляет все параметры модели, QLoRA замораживает предварительно обученные веса и вводит небольшое количество обучаемых параметров низкого ранга. Это достигается путем квантования весов модели до 4-битной точности и добавления адаптеров низкого ранга, что существенно снижает потребность в памяти GPU и позволяет адаптировать LLM на одном GPU. Экспериментальные данные показывают, что QLoRA обеспечивает сопоставимую или даже лучшую производительность по сравнению с полной тонкой настройкой, при этом требуя значительно меньше ресурсов.

Оценка на реалистичных данных: Сравнительный анализ

Для оценки эффективности различных больших языковых моделей (LLM) — Mistral, Gemma 2 9B и Llama 3.1 8B — был проведен ряд экспериментов с использованием стандартных методов дообучения. Процесс дообучения включал в себя настройку предварительно обученных моделей на специфических наборах данных для улучшения их производительности в задачах классификации и анализа текста. Применялись общепринятые алгоритмы оптимизации и техники регуляризации для предотвращения переобучения и обеспечения обобщающей способности моделей. Стандартные методы дообучения позволили обеспечить сопоставимость результатов и объективную оценку преимуществ и недостатков каждой модели.

Для оценки производительности моделей на различных типах электронных писем и в условиях меняющегося ландшафта угроз, тестирование проводилось на трех корпусах данных: SpamAssassin, Enron и Modern Phishing. Корпус SpamAssassin содержит набор сообщений, помеченных как спам или не спам, представляя классическую задачу фильтрации. Корпус Enron состоит из архива электронных писем сотрудников Enron, обеспечивая данные для анализа корпоративной коммуникации и выявления аномалий. Корпус Modern Phishing включает в себя современные примеры фишинговых атак, позволяя оценить способность моделей к обнаружению и классификации актуальных угроз. Использование этих трех корпусов обеспечило всестороннюю оценку производительности моделей в различных сценариях и с разными стилями электронных писем.

Сравнительный анализ показал, что модель Gemma 2 9B достигла показателя F1 в 0.9132 на объединенном наборе данных Generalist, превзойдя модель Llama 3.1 8B, настроенную как специалист. Это указывает на более высокую эффективность общего подхода к обучению, когда модель способна эффективно работать с разнообразными типами данных без узкой специализации. Превосходство Gemma 2 9B подтверждает, что общая способность к обобщению данных может быть более предпочтительной для задач классификации электронных писем, чем глубокая специализация на конкретных характеристиках.

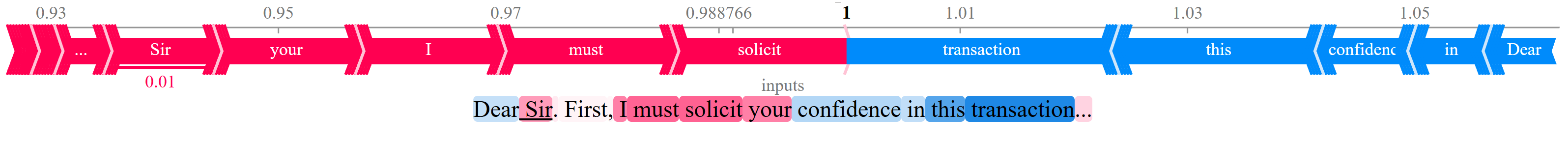

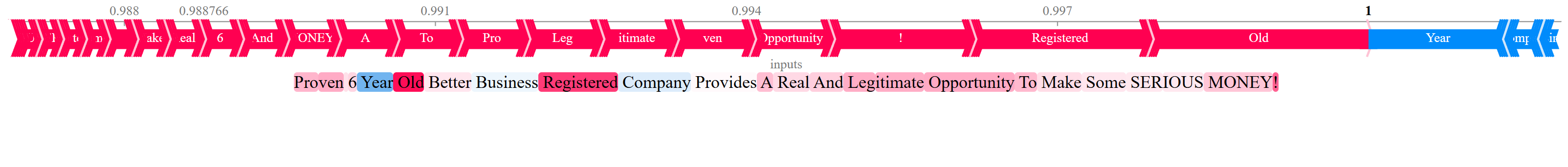

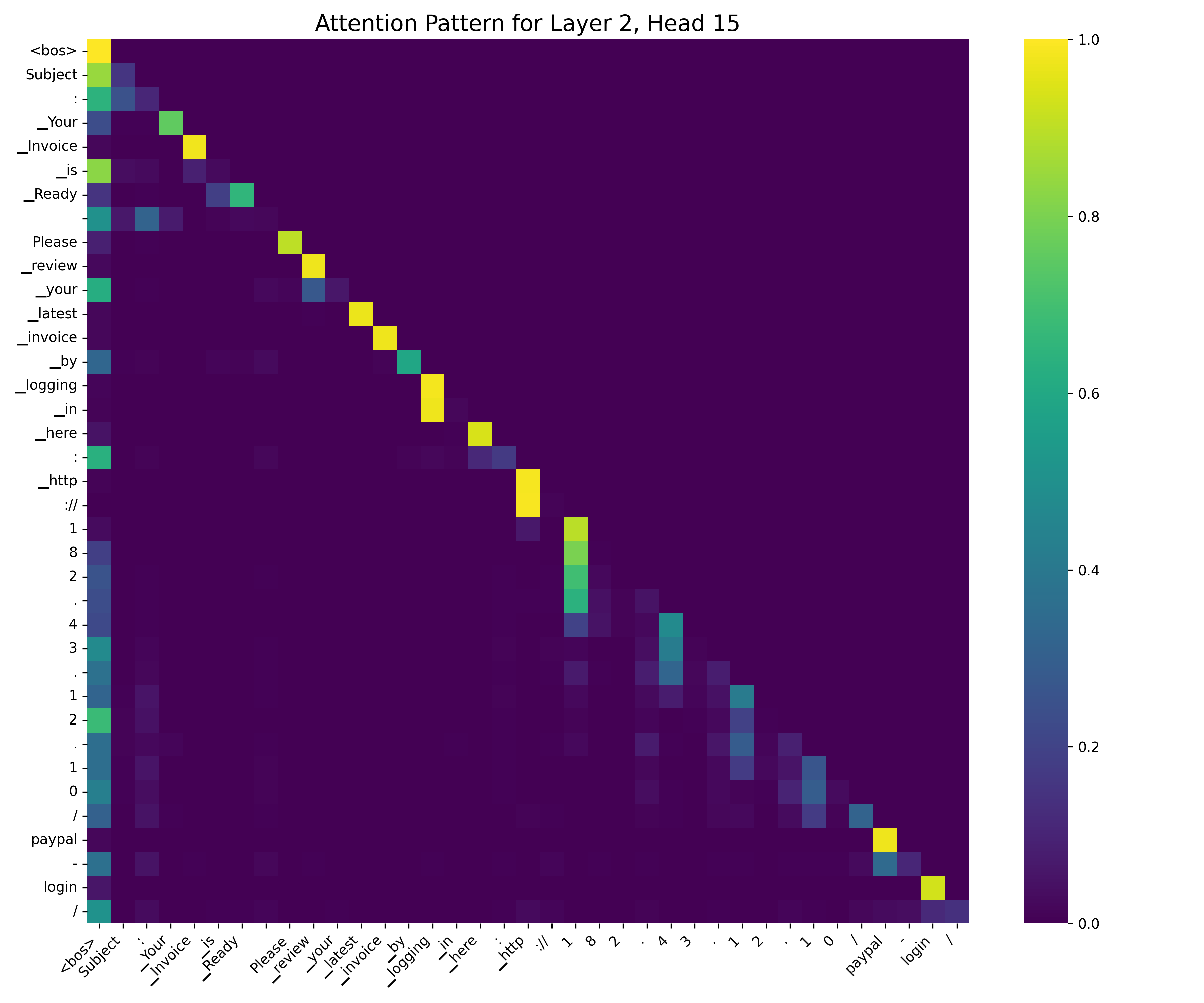

Для интерпретации предсказаний моделей и выявления ключевых признаков, влияющих на производительность, использовались значения SHAP (SHapley Additive exPlanations). Этот метод позволяет оценить вклад каждого признака в конкретное предсказание, предоставляя информацию о том, какие слова или характеристики электронных писем наиболее сильно влияют на классификацию как спама или фишинга. Анализ значений SHAP выявил наиболее значимые признаки, позволяя понять логику работы моделей и определить, на какие аспекты контента они ориентируются при принятии решений. Полученные данные способствуют более глубокому пониманию поведения моделей и повышению доверия к их предсказаниям.

Последствия и будущие направления: Создание устойчивого ИИ

Наблюдаемые уязвимости современных моделей искусственного интеллекта подчеркивают необходимость переосмысления приоритетов в области разработки. Долгое время ключевым показателем успеха считалась высокая точность на стандартных наборах данных, однако реальный мир характеризуется изменчивостью и непредсказуемостью. В связи с этим, все большее внимание уделяется способности моделей к обобщению — то есть, к эффективной работе с данными, отличными от тех, на которых они обучались. Недостаточно просто достичь высоких результатов в лабораторных условиях; необходимо создавать системы, способные адаптироваться к новым ситуациям и сохранять надежность в непредсказуемой среде. Такой подход позволит перейти от узкоспециализированных систем к более универсальным и устойчивым решениям, способным решать широкий спектр задач в реальном мире.

Архитектуры “Смесь экспертов” представляют собой перспективный подход к повышению устойчивости искусственного интеллекта. Вместо использования одной универсальной модели, данный подход предполагает наличие нескольких специализированных подмоделей — “экспертов”, каждая из которых обучена для обработки определенного типа входных данных или решения конкретной задачи. При поступлении нового запроса, система динамически определяет, какие эксперты наиболее подходят для его обработки, и объединяет их прогнозы. Такая модульная структура позволяет модели более эффективно справляться с разнообразными и сложными сценариями, а также снижает вероятность ошибок, вызванных нетипичными или зашумленными данными. В отличие от монолитных моделей, подверженных “катастрофическому забыванию” при обучении на новых данных, “Смесь экспертов” способна гибко адаптироваться и сохранять высокую производительность в различных условиях, обеспечивая более надежную и устойчивую работу системы.

Метод тонкой настройки с использованием цепочки рассуждений (Chain-of-Thought Fine-tuning) демонстрирует значительный потенциал в усилении способности искусственного интеллекта к логическому мышлению и преодолении тенденции к поверхностному сопоставлению образов. Суть подхода заключается в обучении модели не просто выдавать конечный ответ, а последовательно излагать этапы рассуждений, приводящие к этому ответу. Это позволяет ИИ не полагаться на статистические закономерности в данных, а действительно понимать суть задачи и применять знания к новым, незнакомым ситуациям. В результате, модели, обученные с использованием цепочки рассуждений, демонстрируют повышенную устойчивость к обманчивым примерам и способны генерировать более надежные и обоснованные решения, приближая искусственный интеллект к человеческому уровню когнитивных способностей.

Дальнейшие исследования в области методов увеличения данных, стратегий адаптации к различным предметным областям и методов состязательного обучения имеют решающее значение для создания действительно устойчивых систем искусственного интеллекта. Использование техник увеличения данных позволяет искусственно расширить обучающую выборку, повышая обобщающую способность моделей и их устойчивость к новым, ранее не встречавшимся данным. Стратегии адаптации к различным предметным областям позволяют эффективно переносить знания, полученные в одной области, в другую, сокращая потребность в больших объемах размеченных данных для каждой новой задачи. Наконец, состязательное обучение, путем намеренного создания «враждебных» примеров, помогает моделям научиться распознавать и игнорировать незначительные изменения во входных данных, тем самым повышая их надежность и устойчивость к атакам и шуму.

Исследование демонстрирует, что кажущаяся надежность моделей обработки естественного языка в обнаружении фишинга обманчива. Часто, эти системы учатся не распознавать саму суть угрозы, а улавливать поверхностные закономерности в обучающих данных. Это напоминает о мудрости Грейс Хоппер: «Лучший способ предсказать будущее — создать его». Подобно тому, как архитектурный выбор в системе предвещает будущие сбои, так и состав обучающей выборки предопределяет способность модели к обобщению. Недостаточное разнообразие данных, как показывает статья, делает систему хрупкой и подверженной ошибкам, даже при высокой точности на тестовом наборе. Система, лишенная возможности «видеть» за пределы узкого набора примеров, обречена повторять ошибки, замаскированные под успехом.

Что дальше?

Настоящая работа лишь осторожно касается поверхности сложной экосистемы, которой становятся большие языковые модели, внедряемые в задачи вроде обнаружения фишинга. Очевидно, что недостаточно просто обучить модель на большем количестве данных; необходимо культивировать разнообразие, подобно садовнику, ухаживающему за редкими растениями. Проблемы, связанные с шумом в обучающих данных, не решаются увеличением их объема, а требуют более тонких методов очистки и, возможно, принципиально иных подходов к формированию обучающих выборок.

Анализ механизмов внимания и использование методов интерпретируемости, таких как SHAP, дают лишь проблески в «черный ящик», но не раскрывают всей сложности принимаемых моделью решений. Следующим шагом видится не столько поиск «объяснимого ИИ», сколько развитие инструментов, позволяющих предсказывать хрупкость этих систем, их склонность к внезапному отказу при малейшем отклонении от привычных условий. Каждый архитектурный выбор — это, по сути, пророчество о будущем сбое, и задача исследователя — научиться читать эти предсказания.

В конечном итоге, устойчивость системы не в изоляции её компонентов, а в их способности прощать ошибки друг друга. Модели, способные к самодиагностике и адаптации к новым угрозам, представляются не просто желательными, но и необходимыми для обеспечения безопасности в постоянно меняющемся цифровом мире. И, возможно, самое важное — помнить, что система — это не машина, а сад, требующий постоянного ухода и внимания.

Оригинал статьи: https://arxiv.org/pdf/2601.10524.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- БИТКОИН ПРОГНОЗ. BTC криптовалюта

- ПРОГНОЗ ДОЛЛАРА К ШЕКЕЛЮ

- ЭФИРИУМ ПРОГНОЗ. ETH криптовалюта

- SOL ПРОГНОЗ. SOL криптовалюта

- SAROS ПРОГНОЗ. SAROS криптовалюта

- ПРОГНОЗ ЕВРО К ШЕКЕЛЮ

- ДОГЕКОИН ПРОГНОЗ. DOGE криптовалюта

- ZEC ПРОГНОЗ. ZEC криптовалюта

- РИППЛ ПРОГНОЗ. XRP криптовалюта

- PEPE ПРОГНОЗ. PEPE криптовалюта

2026-01-18 14:41