Автор: Денис Аветисян

Новое исследование демонстрирует возможность выявления текстов, созданных или отредактированных с помощью искусственного интеллекта, в турецких СМИ.

В работе представлена модель на основе BERT, обученная на турецком языке, для точной классификации контента, созданного с использованием больших языковых моделей.

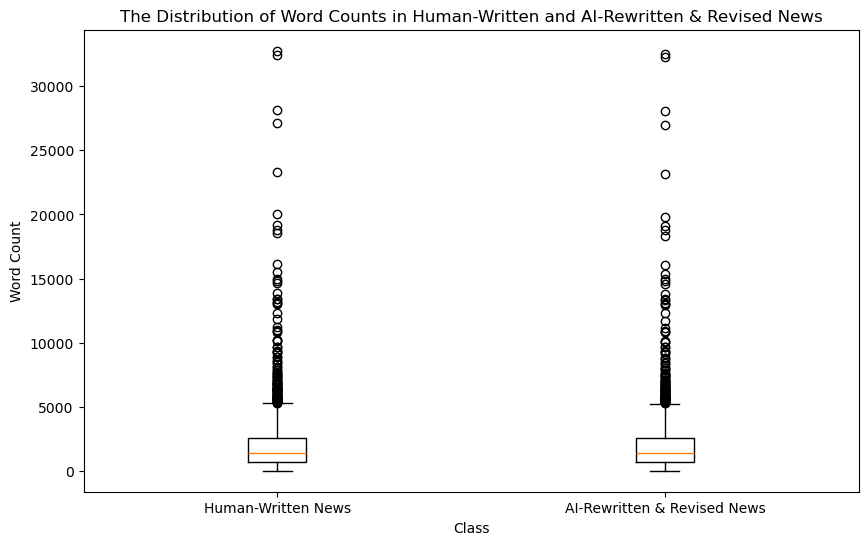

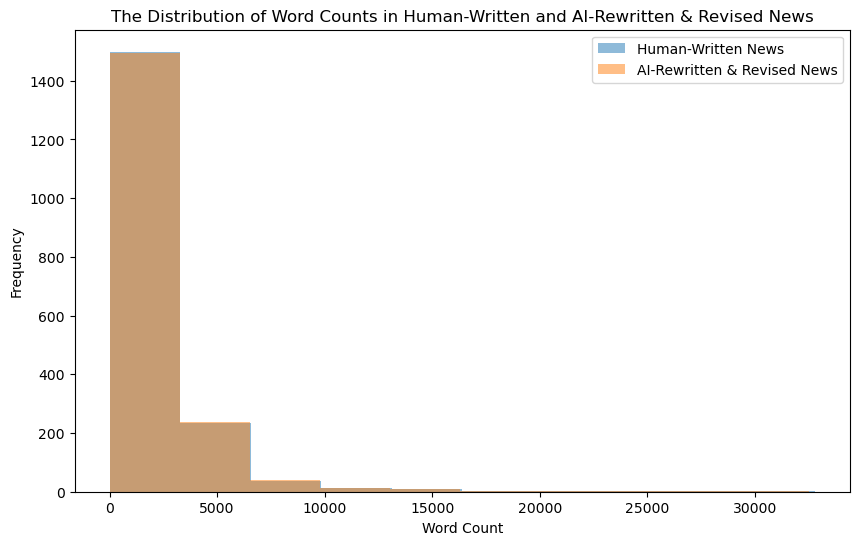

Несмотря на растущие опасения по поводу распространения контента, сгенерированного искусственным интеллектом, эмпирическая оценка этого явления в неанглоязычных медиа остается ограниченной. В настоящей работе, ‘From Perceptions To Evidence: Detecting AI-Generated Content In Turkish News Media With A Fine-Tuned Bert Classifier’, предпринята попытка заполнить этот пробел путем разработки и применения специализированной турецкой модели BERT для выявления новостных статей, подвергшихся переработке с помощью больших языковых моделей. Достигнута высокая точность классификации — 0.9708 по метрике F1 — и выявлена доля контента, переработанного ИИ, в среднем около 2.5%. Каковы перспективы масштабирования подобных моделей для мониторинга и обеспечения прозрачности в медиа-ландшафте других языков и регионов?

Разоблачение Искусственного: Вызовы Автоматизированных Новостей

Распространение контента, созданного искусственным интеллектом, особенно в сфере новостей, представляет собой серьезную угрозу для целостности медиапространства. Автоматизированные системы генерации текстов позволяют создавать статьи, внешне неотличимые от написанных человеком, что затрудняет выявление дезинформации и манипуляций. Этот процесс подрывает доверие к новостным источникам, поскольку становится все сложнее определить подлинность информации и авторство материалов. Увеличение объема AI-генерируемого контента требует разработки новых методов проверки и верификации, способных эффективно различать тексты, созданные человеком, и тексты, сгенерированные алгоритмами, для поддержания качества и достоверности новостного потока.

Традиционные методы проверки новостных источников и фактчекинга сталкиваются с растущими трудностями в связи с развитием искусственного интеллекта. Раньше достаточно было проверить репутацию издания или сопоставить информацию из нескольких источников, однако современные генеративные модели способны создавать тексты, практически неотличимые от написанных человеком. Это затрудняет выявление манипуляций и фальсификаций, поскольку даже опытные журналисты и фактчекеры могут ошибочно принять сгенерированный текст за подлинный. Использование AI для автоматизации фактчекинга также сталкивается с проблемами, поскольку модели могут быть обмануты специально разработанными для дезинформации текстами или не способны учесть контекст и нюансы, важные для оценки достоверности информации. Таким образом, существующие инструменты и подходы нуждаются в существенной модернизации и адаптации к новым условиям, чтобы эффективно противостоять распространению ложных новостей, созданных с помощью искусственного интеллекта.

Крайне важно уметь различать новости, созданные человеком, и те, что сгенерированы искусственным интеллектом, поскольку это напрямую влияет на общественное доверие и борьбу с дезинформацией. Анализ турецких медиа показал, что приблизительно 2,5% новостных статей в период с 2023 по 2026 год были переписаны или отредактированы с использованием искусственного интеллекта. Этот показатель демонстрирует значительный масштаб проблемы и подчеркивает необходимость разработки эффективных методов обнаружения контента, созданного машинами, для сохранения целостности информационного пространства и предотвращения манипулирования общественным мнением.

BERT в Действии: Классификация Автора как Решение

В данном исследовании для бинарной классификации новостных статей была использована архитектура BERT — мощная предварительно обученная языковая модель, основанная на механизме трансформеров. BERT позволяет учитывать контекст каждого слова в предложении, что обеспечивает более точное понимание смысла текста по сравнению с традиционными методами обработки естественного языка. Предварительное обучение модели на большом корпусе текстов позволяет ей извлекать общие языковые закономерности, а последующая тонкая настройка на специализированном наборе данных (в данном случае, новостных статьях) адаптирует модель к конкретной задаче классификации.

Для повышения производительности при обработке турецкого текста в рамках задачи классификации авторства была применена предобученная модель BERT, адаптированная специально для турецкого языка — DBMDZ BERT Base Turkish Cased. Данная модель подверглась тонкой настройке (fine-tuning) с использованием размеченного набора данных, что позволило ей учитывать лингвистические особенности и нюансы турецкого языка, нетривиальные для стандартных моделей, обученных на других языках. Процесс тонкой настройки включает в себя корректировку весов модели на основе размеченных данных, что оптимизирует её способность к распознаванию специфических паттернов, характерных для турецких текстов.

Для эффективной обработки турецкого языка в модели BERT был использован метод токенизации WordPiece. В отличие от традиционных методов, разбивающих текст на слова, WordPiece разбивает слова на подслова, основываясь на частоте их встречаемости в корпусе данных. Это особенно важно для агглютинативного языка, такого как турецкий, где к корню слова добавляются многочисленные суффиксы и префиксы. Использование WordPiece позволяет модели обрабатывать даже редко встречающиеся морфемы и эффективно представлять семантическое значение слов, что повышает точность классификации авторства.

Процесс дообучения модели BERT на размеченном корпусе турецких новостных статей позволил адаптировать её к специфическим лингвистическим особенностям турецкого языка и стилю новостной журналистики. Данная адаптация значительно повысила точность определения контента, сгенерированного искусственным интеллектом, достигнув показателя в 97.92% на тестовом наборе данных. Это свидетельствует о высокой эффективности подхода к выявлению ИИ-генерируемого текста в турецком сегменте новостного пространства.

![Предварительное обучение и последующая тонкая настройка являются ключевыми этапами в процессе обучения модели BERT[10].](https://arxiv.org/html/2602.13504v1/bert.png)

Валидация Модели: Подтверждение Эффективности и Точности

Для оценки способности модели к точной классификации новых, ранее не встречавшихся данных, была проведена внешняя валидация. Этот процесс включал в себя тестирование модели на отдельном наборе данных, не использовавшемся при обучении и настройке. Успешное прохождение внешней валидации подтверждает обобщающую способность модели, то есть её способность эффективно работать с данными, отличающимися от тех, на которых она была обучена, что является критически важным для практического применения в реальных условиях.

Модель продемонстрировала высокую эффективность в различении новостных статей на турецком языке, написанных человеком и сгенерированных искусственным интеллектом, достигнув значения метрики F1 в 97.08% на независимом тестовом наборе данных. Этот показатель указывает на сбалансированную точность и полноту классификации, что подтверждает способность модели к обобщению и корректной идентификации источников новостного контента. Использование метрики F1 позволило оценить производительность модели с учетом как ложноположительных, так и ложноотрицательных результатов, обеспечивая комплексную оценку ее эффективности.

Для обработки длинных текстов новостных статей были исследованы методы Sliding-Window и Longformer. Sliding-Window предполагает разделение текста на фрагменты фиксированной длины с последующим анализом каждого фрагмента, что позволяет обрабатывать тексты, превышающие максимальную длину, поддерживаемую моделью. Longformer, в свою очередь, представляет собой архитектуру трансформера, оптимизированную для работы с длинными последовательностями, благодаря использованию механизмов внимания, масштабирующихся линейно с длиной входной последовательности. Применение данных техник позволило повысить точность классификации и эффективно обрабатывать полнотекстовые новостные статьи на турецком языке.

Ответственность в Эпоху ИИ: Вклад в Прозрачность Медиа

Данное исследование вносит значительный вклад в развивающуюся область вычислительной медиа-ответственности, предлагая эффективный инструмент для выявления новостных материалов, созданных с использованием искусственного интеллекта. Разработанная методика позволяет автоматизированно анализировать текстовый контент и определять вероятность его генерации нейронными сетями, что особенно актуально в условиях растущей доли AI-контента в информационном пространстве. Возможность достоверного определения авторства новостей позволяет решать ряд критически важных задач, включая контроль за распространением предвзятой информации и обеспечение объективности новостного освещения. Предложенный подход представляет собой важный шаг к созданию более прозрачной и ответственной медиа-экосистемы, способствуя укреплению доверия общественности к новостным источникам.

Выявление контента, созданного искусственным интеллектом, приобретает критическое значение в контексте обеспечения объективности и беспристрастности новостных сообщений. Автоматизированное создание новостей, несмотря на свою эффективность, несёт в себе риск воспроизведения и усиления существующих предрассудков и стереотипов, заложенных в алгоритмах и обучающих данных. Тщательный анализ и обнаружение контента, сгенерированного ИИ, позволяет выявить потенциальные искажения, оценить степень влияния автоматизации на редакционную политику и, в конечном итоге, гарантировать, что новостные сообщения отражают разнообразные точки зрения и основаны на проверенных фактах. Отсутствие прозрачности в отношении использования ИИ в журналистике может привести к подрыву доверия аудитории и распространению необъективной информации, что подчеркивает важность разработки инструментов и методов для идентификации и оценки сгенерированного контента.

Исследование подчеркивает фундаментальную важность прозрачности в современной медиа-сфере и необходимость четкой маркировки контента, созданного с использованием искусственного интеллекта. Отсутствие такой маркировки создает риски для общественного восприятия информации, поскольку потребители могут не осознавать, что перед ними результат работы алгоритмов, а не журналистского расследования или экспертной оценки. Четкая идентификация AI-генерируемых материалов позволяет читателям критически оценивать представленные факты и учитывать потенциальные предубеждения, заложенные в алгоритмы. Подобная практика не только способствует повышению медиаграмотности, но и укрепляет доверие к новостным источникам, демонстрируя их приверженность этичным принципам и открытости в отношении используемых технологий.

Разработанные методики представляют собой эффективный инструмент в борьбе с распространением дезинформации и поддержанием доверия к источникам новостей. Они позволяют автоматизированно выявлять контент, созданный искусственным интеллектом, что критически важно в условиях растущей доли сгенерированных текстов в информационном пространстве. Благодаря возможности масштабирования и адаптации к различным форматам медиа, эти методы могут быть интегрированы в системы мониторинга новостного потока, что позволяет оперативно обнаруживать и маркировать потенциально вводящую в заблуждение информацию. Повышая прозрачность происхождения новостей, данная технология способствует укреплению общественного доверия к медиа и снижению влияния манипулятивных практик.

Исследование показывает, что даже в тщательно выверенном информационном потоке присутствуют следы автоматизированной обработки. Подобная работа требует предельной ясности и строгости, поскольку обнаружение искусственно созданного контента — задача, требующая исключения любой двусмысленности. Как говорил Карл Фридрих Гаусс: «Если бы я должен был выбрать одно слово, чтобы описать математику, я бы выбрал порядок». Этот принцип порядка и точности применителен и к анализу текстов: выявление признаков машинного вмешательства требует систематического подхода и исключения субъективных оценок. Аккуратность в определении границ между человеческим и машинным творчеством становится критически важной для обеспечения информационной честности.

Куда Ведет Этот Путь?

Представленная работа, продемонстрировавшая возможность выявления текстов, обработанных языковыми моделями, в турецком информационном пространстве, лишь слегка приоткрывает завесу над более глубокой проблемой. Достигнутая точность, несомненно, обнадечивает, однако она не устраняет фундаментального вопроса: что есть «подлинность» в эпоху, когда границы между человеческим и машинным творчеством становятся все более размытыми? Вместо гонки за процентами точности, необходимо переосмыслить критерии оценки информации, смещая акцент с обнаружения «подделок» на понимание степени влияния алгоритмов на формирование общественного мнения.

Представляется, что дальнейшие исследования должны сосредоточиться не только на совершенствовании классификаторов, но и на анализе причин появления контента, созданного или измененного искусственным интеллектом. Более того, необходимо учитывать контекст: не каждая правка, сделанная алгоритмом, является злонамеренной. Иногда это просто следствие оптимизации процессов, а иногда — проявление небрежности. Попытки автоматического обнаружения, таким образом, неизбежно сталкиваются с этическими дилеммами, требующими вдумчивого подхода.

Совершенство в этой области, если оно вообще достижимо, заключается не в создании идеального детектора, а в исчезновении необходимости в нем. Иными словами, подлинная цель — создание информационной среды, где прозрачность и ответственность являются нормой, а не исключением. В конечном итоге, каждое усложнение алгоритма — это признание несовершенства самой системы.

Оригинал статьи: https://arxiv.org/pdf/2602.13504.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- БИТКОИН ПРОГНОЗ. BTC криптовалюта

- ПРОГНОЗ ДОЛЛАРА К ШЕКЕЛЮ

- SOL ПРОГНОЗ. SOL криптовалюта

- ЭФИРИУМ ПРОГНОЗ. ETH криптовалюта

- РИППЛ ПРОГНОЗ. XRP криптовалюта

- ДОГЕКОИН ПРОГНОЗ. DOGE криптовалюта

- SUI ПРОГНОЗ. SUI криптовалюта

- SAROS ПРОГНОЗ. SAROS криптовалюта

- FARTCOIN ПРОГНОЗ. FARTCOIN криптовалюта

- HYPE ПРОГНОЗ. HYPE криптовалюта

2026-02-17 10:13