Автор: Денис Аветисян

Новое исследование показывает, что самообъяснимые графовые нейросети могут выдавать правдоподобные, но совершенно бесполезные объяснения своих решений.

Ищешь ракеты? Это не к нам. У нас тут скучный, медленный, но надёжный, как швейцарские часы, фундаментальный анализ.

Бесплатный Телеграм канал

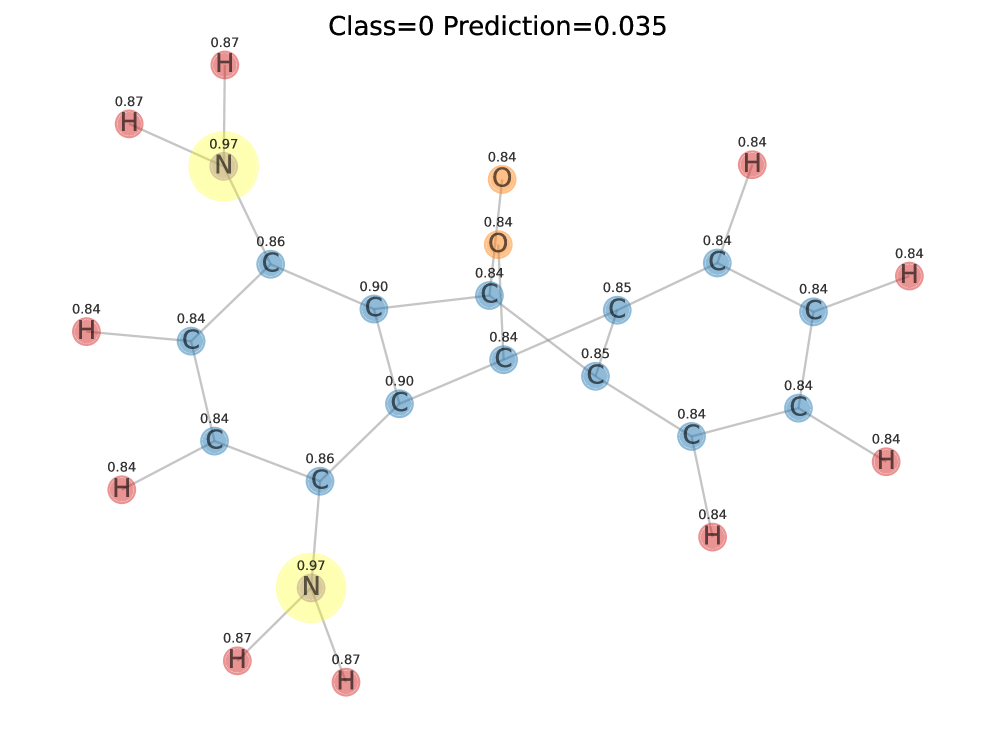

Работа предлагает новый способ выявления неверных объяснений в моделях графового машинного обучения и демонстрирует, как манипулировать этими объяснениями.

Несмотря на возрастающую популярность самообъяснимых графовых нейронных сетей (SE-GNN), их объяснения не всегда отражают реальные механизмы принятия решений. В работе ‘GNN Explanations that do not Explain and How to find Them’ показано, что SE-GNN могут генерировать правдоподобные, но при этом неверные объяснения, сохраняя при этом высокую точность классификации. Авторы выявили критическую проблему — способность моделей к генерации «дегенерированных» объяснений, которые могут маскировать использование конфиденциальных атрибутов или возникать естественным образом. Возможно ли разработать надежные метрики, способные выявлять подобные несоответствия и обеспечивать прозрачность работы графовых нейронных сетей?

Вызов Доверия к Графовым Предсказаниям

Графовые нейронные сети (ГНС) демонстрируют впечатляющие результаты в задачах классификации графов, превосходя традиционные методы анализа сетевых данных. Однако, высокая точность предсказаний часто сопровождается недостаточной прозрачностью работы этих моделей. Поскольку ГНС оперируют сложными взаимосвязями между узлами и ребрами графа, понять, какие именно факторы привели к конкретному решению, представляет значительную трудность. Отсутствие интерпретируемости вызывает обоснованные опасения относительно надежности ГНС в критически важных приложениях, где требуется не только точный результат, но и возможность проверки и обоснования принятого решения. Это особенно актуально в областях, таких как медицина, финансы и безопасность, где неверные или необъяснимые предсказания могут иметь серьезные последствия.

Достижение высокой точности в предсказаниях графовых нейронных сетей (GNN) само по себе недостаточно для надежного применения в реальных задачах. Критически важно понимать причины, по которым модель приходит к определенному выводу. В областях, требующих высокой степени доверия, таких как медицина или финансы, недостаточно просто получить правильный ответ; необходимо, чтобы этот ответ был подкреплен логичной и прозрачной цепочкой рассуждений. Отсутствие объяснимости может привести к принятию ошибочных решений, особенно в случаях, когда данные содержат скрытые закономерности или смещения. Поэтому, разработка методов, позволяющих интерпретировать внутреннюю логику GNN, является ключевой задачей для обеспечения надежности и ответственности этих моделей в критически важных приложениях.

Существующие методы интерпретации графовых нейронных сетей (GNN) часто сталкиваются с серьезной проблемой: отличить подлинно значимые объяснения предсказаний от тех, что являются лишь отражением внутренних предубеждений самой модели. Попытки выявить наиболее влиятельные узлы или связи в графе могут приводить к ложным выводам, если эти факторы не связаны с реальными причинами предсказания, а являются артефактами процесса обучения или структурными особенностями данных. Это особенно критично в областях, где важна обоснованность решений, например, в медицине или финансах, поскольку полагаться на объяснения, основанные на предвзятости, может привести к ошибочным и даже опасным последствиям. Разработка методов, способных достоверно отделять истинные факторы влияния от ложных, остается важной задачей для обеспечения надежности и доверия к графовым нейронным сетям.

Ловушки Недобросовестных Объяснений

Наивные объяснения, выделяющие признаки, коррелирующие с предсказанием модели, могут вводить в заблуждение, поскольку не отражают истинные причинно-следственные связи, влияющие на принятие решения. Выделенные признаки могут быть просто сопутствующими факторами, а не ключевыми элементами, определяющими выход модели. Это означает, что изменение или удаление этих коррелирующих признаков не обязательно приведет к изменению предсказания модели, что указывает на их нерелевантность для фактического процесса принятия решения. Такие объяснения, хотя и кажутся правдоподобными, могут привести к неверным выводам о работе модели и ее логике.

Наличие «якорных множеств» — тривиальных подграфов, общих для всех графов в наборе данных — приводит к формированию неинформативных объяснений, лишенных дискриминационной способности. Эти подграфы, будучи повсеместно присутствующими, не позволяют выделить признаки, действительно влияющие на решение модели графовой нейронной сети (GNN). В результате, объяснения, основанные на якорных множествах, не отражают специфические особенности, отличающие один граф от другого, и не могут быть использованы для понимания логики принятия решений моделью. Это приводит к формированию «вырожденных» объяснений, которые формально указывают на некоторые элементы графа, но не несут полезной информации для интерпретации.

Наборы данных RBGV, MNISTsp, MUTAG и SST2P демонстрируют широкую распространенность неверных объяснений, особенно при использовании простых моделей графовых нейронных сетей (GNN). Исследования на этих наборах данных показывают, что даже при высокой точности предсказаний, объяснения, выделяемые стандартными методами, часто включают в себя признаки, не являющиеся истинно причинными для принятого моделью решения. В частности, наблюдается, что простые модели склонны полагаться на тривиальные подграфы или корреляции в данных, что приводит к объяснениям, не отражающим реальную логику работы сети и не обобщающимся на новые данные. Это указывает на систематическую проблему в интерпретируемости GNN, требующую разработки более надежных методов объяснения.

Неверные объяснения, предоставляемые современными графовыми нейронными сетями (GNN), не следует рассматривать как случайный шум или артефакты. Анализ на наборах данных RBGV, MNISTsp, MUTAG и SST2P демонстрирует, что эти объяснения представляют собой фундаментальное ограничение в способности GNN предоставлять достоверную и причинно обоснованную интерпретацию своих решений. Проблема заключается не в качестве алгоритмов объяснения, а в самой архитектуре и принципах работы GNN, которые могут опираться на корреляции, а не на истинные причинно-следственные связи в данных. Это указывает на необходимость разработки новых методов интерпретации или, возможно, принципиально новых архитектур GNN, способных предоставлять более надежные объяснения.

К Строгой Оценке Достоверности: На Пути к Доказательству

Метрики достоверности, такие как Suf, RFid и CF, предназначены для количественной оценки соответствия между объяснением и фактическим процессом принятия решения моделью графовой нейронной сети (GNN). Эти метрики анализируют, насколько изменения в объяснении (например, удаление или маскировка определенных элементов графа) влияют на предсказание модели. Высокие значения метрик указывают на то, что объяснение точно отражает факторы, которые GNN использует для классификации, в то время как низкие значения свидетельствуют о несоответствии и потенциальной неверности объяснения. Анализ, проводимый с помощью этих метрик, позволяет оценить, насколько объяснение действительно отражает логику работы модели, а не является просто набором случайно выбранных элементов графа.

Тест на достаточность расширения (EST) предполагает проверку, приводят ли все суперграфы объяснения к тому же предсказанию, что и исходный граф. В отличие от оценки только самого объяснения, EST анализирует все возможные расширения этого объяснения путем добавления дополнительных ребер или узлов. Если любое расширение приводит к иному предсказанию, это указывает на ненадёжность исходного объяснения, поскольку небольшое изменение в структуре приводит к изменению результата классификации. Таким образом, EST обеспечивает более строгую оценку, выявляя объяснения, которые не являются устойчивыми и, следовательно, не отражают истинный процесс принятия решений графовой нейронной сетью (GNN).

Результаты экспериментов демонстрируют, что тест Extension Sufficiency Test (EST) эффективно отбраковывает объяснения, не обладающие дискриминативной силой по классам. Достигнутый коэффициент отбраковки составляет ≥50%, что указывает на способность EST выявлять объяснения, которые не отражают реальные факторы, влияющие на принятие решения графовой нейронной сетью (GNN). Этот показатель значительно превосходит результаты, полученные с использованием традиционных метрик, таких как Fidelity и RFidelity, которые демонстрируют коэффициент отбраковки лишь около ≈2%, указывая на их ограниченную способность к надежному выявлению неверных объяснений.

Традиционные метрики, такие как Fidelity и RFidelity, демонстрируют низкую эффективность в выявлении неверных объяснений, показывая коэффициент отклонения (rejection ratio) всего около 2%. Это указывает на то, что данные метрики не способны надежно идентифицировать случаи, когда объяснение не отражает фактический процесс принятия решения моделью. Низкий коэффициент отклонения свидетельствует о высокой вероятности ложноположительных результатов, когда неверные объяснения ошибочно принимаются за верные, что снижает доверие к анализу объяснимости графовых нейронных сетей (GNN).

Эффективный экстрактор объяснений является критически важным компонентом, поскольку он выделяет подграфы, которые графовая нейронная сеть (GNN) считает наиболее значимыми для своей классификации. Этот процесс предполагает определение подмножества ребер и узлов, оказывающих наибольшее влияние на принятое моделью решение. Качество извлеченного подграфа напрямую влияет на интерпретируемость и надежность объяснения. Различные методы экстракции, такие как основанные на градиентах или на вычислении важности признаков, могут использоваться для определения этих ключевых элементов графа, и выбор подходящего метода зависит от конкретной архитектуры GNN и поставленной задачи.

Комбинирование метрик оценки достоверности, таких как Suf, RFid, CF и, в особенности, Extension Sufficiency Test (EST), позволяет проводить более глубокий анализ качества объяснений работы графовых нейронных сетей (GNN). Использование EST в сочетании с эффективным извлечением подграфов, определяющих значимость признаков, обеспечивает возможность выявления и отбраковки неверных объяснений, что подтверждается достижением коэффициента отбраковки не менее 50%. Такой подход, в отличие от традиционных метрик, как Fidelity и RFidelity, демонстрирующих крайне низкий коэффициент отбраковки (около 2%), способствует разработке более надежных и интерпретируемых GNN, повышая доверие к принимаемым ими решениям и обеспечивая возможность более эффективной отладки и верификации моделей.

Испытание на Прочность: Роль Манипуляций и Оценка Устойчивости

Исследования показали, что даже кажущиеся достоверными объяснения, генерируемые графовыми нейронными сетями, могут быть удивительно хрупкими и подверженными воздействию намеренных искажений. Атаки, основанные на манипуляциях, демонстрируют, что незначительные, едва заметные изменения во входных данных могут привести к существенным изменениям в объяснениях, не затрагивая при этом точность предсказаний модели. Этот феномен указывает на то, что существующие метрики оценки достоверности объяснений могут быть недостаточно надежными, поскольку они не способны выявить такие скрытые уязвимости. Таким образом, важно понимать, что высокая точность модели не гарантирует и достоверность её объяснений, а оценка надежности требует более сложных и устойчивых методов.

Исследователи активно используют целенаправленное создание вводящих в заблуждение объяснений для выявления уязвимостей в метриках, оценивающих достоверность объяснений работы графовых нейронных сетей (GNN). Этот подход позволяет продемонстрировать, что даже кажущиеся правдоподобными объяснения могут быть легко скомпрометированы незначительными изменениями входных данных или самой модели. Создавая искусственные объяснения, которые кажутся логичными, но на самом деле не отражают истинные причины принятого решения, ученые выявляют несостоятельность существующих методов оценки. Такие манипуляции выявляют случаи, когда метрики «верности» (faithfulness) ошибочно признают ложные объяснения как достоверные, подчеркивая необходимость разработки более надежных и устойчивых к обману методов извлечения и оценки объяснений для GNN.

Исследования демонстрируют, что надежность оценки интерпретируемости графовых нейронных сетей (GNN) требует особого внимания к устойчивости метрик. Простота, с которой можно искусственно создать вводящие в заблуждение объяснения, подчеркивает уязвимость существующих методов оценки. Таким образом, крайне важно разрабатывать и применять метрики, которые не поддаются манипуляциям и способны достоверно отражать истинную связь между входными данными, предсказаниями модели и предоставляемыми объяснениями. Недостаточная устойчивость метрик может привести к ошибочной уверенности в надежности GNN, что особенно критично в приложениях, где важна прозрачность и доверие к принимаемым решениям. Поэтому, акцент на разработке устойчивых метрик является ключевым шагом на пути к созданию действительно надежных и объяснимых графовых нейронных сетей.

Действительно надежная графовая нейронная сеть (GNN) не может ограничиваться лишь высокой точностью предсказаний. Не менее важна способность предоставлять объяснения, которые не только достоверно отражают логику принятия решений, но и остаются устойчивыми к намеренным искажениям и манипуляциям. Такая устойчивость, или резилиентность, объяснений является ключевым фактором доверия к модели, поскольку демонстрирует, что ее рассуждения не подвержены влиянию незначительных, но целенаправленных изменений во входных данных или в самом процессе объяснения. Исследования показывают, что даже кажущиеся адекватными объяснения могут оказаться хрупкими, если не подвергаются строгой проверке на устойчивость. В конечном итоге, только сочетание высокой точности и надежных, резилиентных объяснений позволяет говорить о по-настоящему заслуживающей доверия GNN.

Исследование показывает, что самообъяснимые графовые нейронные сети (SE-GNN) могут генерировать неверные объяснения, несмотря на высокую точность классификации графов. Это подчеркивает важность оценки не только производительности модели, но и достоверности предоставляемых ею объяснений. В этом контексте, слова Винтона Серфа особенно актуальны: «Я беспокоюсь о том, что люди считают, что Интернет — это фактическая реальность, а не просто набор инструментов». Подобно тому, как Интернет может создавать иллюзию реальности, SE-GNN могут создавать иллюзию объяснимости, маскируя истинные причины принятия решений. Предложенная в статье метрика позволяет выявить эти неверные объяснения, что является важным шагом к созданию действительно прозрачных и надежных систем искусственного интеллекта.

Что дальше?

Представленная работа обнажает парадокс самообъяснимых графовых нейронных сетей: видимость объяснения не гарантирует его соответствия истинному процессу принятия решений. Высокая точность, достигнутая при неверных объяснениях, является не триумфом, а скорее элегантной демонстрацией возможности обмана. Необходимость поиска метрик, выявляющих эту неверность, — это не просто техническая задача, но и философский вызов. Ведь что есть объяснение, если оно не отражает суть явления?

Будущие исследования должны сосредоточиться на разработке более строгих критериев оценки объяснений, выходящих за рамки простой корреляции между объяснением и предсказанием. Необходимо исследовать возможность создания объяснений, устойчивых к адверсарным атакам и манипуляциям, — иначе любая кажущаяся прозрачность окажется иллюзией. Поиск алгоритмов, которые не просто «работают», но и обладают внутренней математической чистотой, представляется задачей нетривиальной, но необходимой.

В конечном итоге, истинная элегантность в области машинного обучения заключается не в достижении высокой точности любой ценой, а в создании моделей, которые не только предсказывают, но и позволяют понять — с математической строгостью — почему они это делают. Это — путь к созданию не просто интеллектуальных машин, но и машин, которые можно по-настоящему доверить.

Оригинал статьи: https://arxiv.org/pdf/2601.20815.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- БИТКОИН ПРОГНОЗ. BTC криптовалюта

- ПРОГНОЗ ДОЛЛАРА К ШЕКЕЛЮ

- SOL ПРОГНОЗ. SOL криптовалюта

- ЭФИРИУМ ПРОГНОЗ. ETH криптовалюта

- SAROS ПРОГНОЗ. SAROS криптовалюта

- AXS ПРОГНОЗ. AXS криптовалюта

- ПРОГНОЗ ДОЛЛАРА К ЗЛОТОМУ

- FARTCOIN ПРОГНОЗ. FARTCOIN криптовалюта

- ДОГЕКОИН ПРОГНОЗ. DOGE криптовалюта

- РИППЛ ПРОГНОЗ. XRP криптовалюта

2026-01-29 13:27