Автор: Денис Аветисян

Новое исследование показывает, что современные модели искусственного интеллекта могут эффективно выявлять дезинформацию о климате, если использовать дополнительные источники информации.

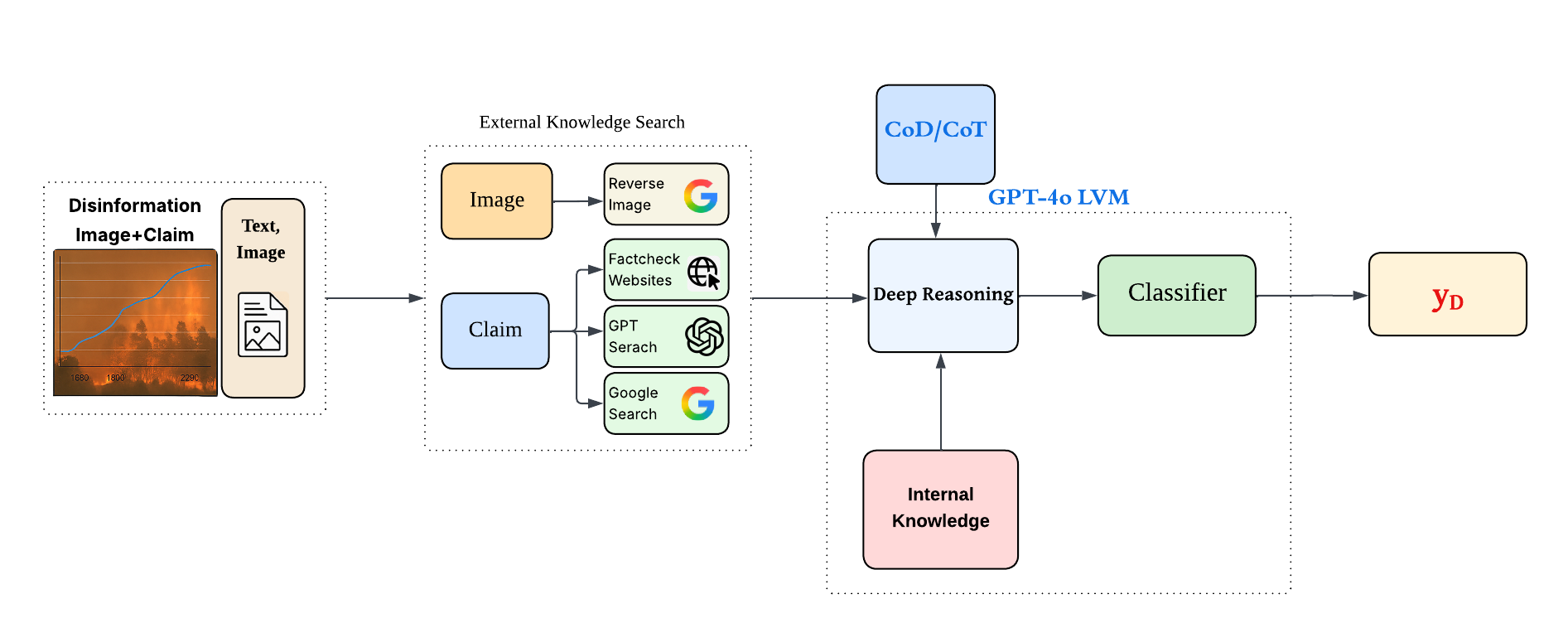

Интеграция поиска по изображениям, веб-поиска и проверок фактов значительно повышает точность обнаружения мультимодальной дезинформации о климате с помощью GPT-4o.

Распространение дезинформации, особенно в мультимодальном формате, представляет собой серьезную проблему для объективного восприятия климатических изменений. В работе под названием ‘Multimodal Climate Disinformation Detection: Integrating Vision-Language Models with External Knowledge Sources’ предложен подход, направленный на повышение эффективности обнаружения ложных утверждений, связанных с климатом. Ключевым результатом исследования является демонстрация того, что комбинирование возможностей современных моделей обработки изображений и текста с актуальной информацией из внешних источников — таких как результаты обратного поиска изображений и базы данных проверок фактов — значительно улучшает точность выявления дезинформации. Возможно ли дальнейшее расширение подобных систем для автоматического мониторинга и нейтрализации потоков недостоверной информации в режиме реального времени?

Иллюзия Истины: Распространение Климатической Дезинформации

Наблюдается тревожная тенденция: параллельно с усилением климатических изменений растет и объем дезинформации, направленной на подрыв доверия к научным данным и препятствование эффективным мерам по борьбе с глобальным потеплением. Эта дезинформация, распространяемая через различные каналы коммуникации, создает путаницу в общественном сознании и формирует ложное представление о масштабах и причинах климатического кризиса. Подобные действия не только замедляют прогресс в решении одной из самых важных проблем современности, но и подрывают усилия по построению устойчивого будущего, создавая серьезные препятствия для принятия обоснованных решений и реализации необходимых изменений.

Дезинформация, касающаяся изменения климата, всё чаще приобретает форму мультимодального контента — комбинации изображений и текста, что значительно усложняет её выявление. В отличие от простых текстовых заявлений, подобные материалы эксплуатируют визуальное восприятие и эмоциональное воздействие, позволяя манипулировать аудиторией более эффективно. Сложность заключается в том, что для оценки достоверности необходимо анализировать не только содержание текста, но и контекст изображения, его соответствие заявленным фактам и возможные скрытые смыслы. Автоматизированные системы обнаружения дезинформации сталкиваются с трудностями при интерпретации взаимосвязи между визуальной и текстовой информацией, что требует разработки новых алгоритмов, способных учитывать семантические нюансы и контекстуальные особенности мультимодальных данных. Такой подход позволит более точно идентифицировать и нейтрализовать ложные нарративы, распространяемые в сети.

Традиционные методы проверки фактов, несмотря на свою важность, все чаще оказываются неспособными справиться с лавиной дезинформации о климате. Современные кампании по распространению ложных сведений отличаются не только огромным объемом, но и возрастающей сложностью, используя манипуляции с изображениями, контекстом и эмоциональным воздействием. В то время как фактчекеры тратят время на опровержение одного утверждения, появляются десятки новых, часто замаскированных под правдоподобные сообщения. Этот дисбаланс между скоростью распространения дезинформации и возможностями её проверки создает серьезную угрозу для общественного понимания климатических изменений и препятствует принятию эффективных мер по борьбе с ними. Необходимы инновационные подходы, включающие автоматизированные инструменты анализа и более широкое вовлечение общественности в процесс выявления и опровержения ложных сведений.

За Пределами Внутренних Знаний: Использование Внешних Источников

Визуально-языковые модели (VLM) представляют собой перспективную отправную точку для систем выявления дезинформации, однако их эффективность ограничена зависимостью от внутренних знаний, накопленных в процессе обучения. Эти модели, оперируя исключительно собственной базой данных, зачастую не способны проверить актуальность или достоверность информации, представленной на изображениях или в тексте. Вследствие этого, VLM могут ошибочно подтверждать ложные утверждения или неверно интерпретировать контекст, особенно в случаях, когда дезинформация касается новых событий или использует малоизвестные факты, отсутствующие в их внутренней базе знаний. Недостаточность внутренних знаний делает VLM уязвимыми для манипуляций и снижает их надежность в качестве инструментов борьбы с распространением недостоверной информации.

Ключевым направлением повышения надежности моделей обработки изображений и текста (VLMs) является расширение их возможностей за счет доступа и анализа внешних источников информации. Вместо полагания исключительно на внутренние знания, модели могут использовать результаты веб-поиска, данные с сайтов проверки фактов и другие общедоступные ресурсы. Это позволяет им сопоставлять утверждения, содержащиеся в изображениях и текстах, с проверенными данными, выявлять несоответствия и повышать точность оценки достоверности информации. Интеграция внешних знаний позволяет VLM преодолеть ограничения, связанные с неполнотой или устарелостью внутренних баз данных, и более эффективно противостоять дезинформации.

Модели, такие как GPT-4o, способны оценивать достоверность утверждений, используя методы веб-поиска и обратного поиска изображений для получения контекстной информации. Веб-поиск позволяет извлекать актуальные данные из интернета, подтверждающие или опровергающие исходное утверждение. Обратный поиск изображений позволяет определить источник изображения и проверить его соответствие заявленному контексту, выявляя случаи манипуляций или использования изображений вне контекста. Комбинирование этих методов обеспечивает доступ к внешним источникам информации, необходимым для проверки фактов и повышения надежности оценки правдивости утверждений, что выходит за рамки возможностей, основанных исключительно на внутренних знаниях модели.

Фреймворк CMIE (Claim Matching with Information Extraction) и модель ERNIE2.0 предлагают архитектуры для эффективной интеграции внешних источников информации в процесс рассуждений при проверке достоверности утверждений. Согласно исследованиям, объединение четырех внешних источников — веб-поиска, обратного поиска изображений, баз данных фактчекинга и специализированных баз знаний — позволяет достичь нулевого процента отказов в определении правдивости утверждений. CMIE осуществляет сопоставление утверждений с извлеченной информацией, а ERNIE2.0 использует предварительно обученное знание и механизмы внимания для эффективного анализа и оценки релевантности полученных данных, обеспечивая более точную и надежную проверку фактов.

Рассуждения с Доказательствами: Многоступенчатый Подход

Эффективное рассуждение не ограничивается простым обнаружением ключевых слов; оно требует последовательного процесса анализа представленных доказательств и формулирования обоснованных выводов. Этот процесс включает в себя идентификацию релевантных данных, оценку их достоверности и надежности, а также логическое сопоставление этих данных с рассматриваемым утверждением. Простое совпадение ключевых слов не гарантирует истинности или обоснованности вывода, поскольку игнорирует контекст, нюансы и возможные искажения в представленных данных. Таким образом, для достижения надежных результатов необходимо систематическое и многоэтапное рассмотрение доказательной базы.

Методы промптинга, такие как Chain-of-Thought (CoT) и Chain-of-Draft (CoD), стимулируют языковые модели к последовательному изложению хода рассуждений, а не просто выдаче конечного ответа. CoT предполагает побуждение модели к генерации промежуточных шагов логических умозаключений, что позволяет проследить логику от исходных данных к выводу. Chain-of-Draft (CoD) идет дальше, предлагая модели генерировать несколько вариантов рассуждений, а затем выбирать наиболее убедительный. Применение этих техник повышает прозрачность процесса принятия решений моделью и, как следствие, увеличивает надежность и обоснованность полученных результатов.

Применение стратегий промптинга, таких как Chain-of-Thought (CoT) и Chain-of-Draft (CoD), позволяет направлять модель GPT-4o на проведение тщательной оценки утверждений, связанных с изменением климата. Эти методы стимулируют модель к последовательному изложению процесса рассуждений, что позволяет более эффективно анализировать представленные данные и аргументы. В частности, CoT требует от модели последовательного представления шагов логического вывода, а CoD предполагает генерацию нескольких вариантов ответа с последующим их уточнением, что повышает надежность и обоснованность полученных заключений при оценке климатических заявлений.

Набор данных CLiME, включающий аннотации мультимодального контента, представляет собой ценный ресурс для обучения и оценки возможностей логического мышления. Данный набор содержит информацию, представленную в различных форматах — текст, изображения и графики — что позволяет моделям анализировать данные комплексно. Аннотации включают в себя не только сами факты, но и обоснования, лежащие в основе утверждений, что необходимо для обучения моделей построению логических цепочек и оценке достоверности информации. Использование CLiME позволяет оценить способность моделей к обработке и сопоставлению разнородных данных, а также к выявлению противоречий и построению обоснованных выводов в контексте климатических изменений.

Оценка и Усиление Обнаружения Дезинформации

Тщательная оценка является основополагающим этапом в подтверждении эффективности любой предложенной методики. Без строгого и всестороннего анализа невозможно достоверно установить, насколько успешно разработанный подход способен решать поставленные задачи и превосходить существующие аналоги. В данном исследовании, акцент на строгой оценке позволил не только количественно измерить улучшение в обнаружении дезинформации, но и выявить слабые места, требующие дальнейшей доработки. Использование стандартизированных наборов данных и метрик обеспечивает объективность и воспроизводимость результатов, что критически важно для научного прогресса и практического применения разработанных технологий.

Для объективной оценки эффективности систем обнаружения дезинформации используются стандартизированные наборы данных, такие как DECEPTIONDECODED. Этот подход позволяет измерить способность модели анализировать представленные доказательства и выявлять скрытые намерения, направленные на введение в заблуждение. DECEPTIONDECODED предоставляет унифицированный фреймворк, что обеспечивает сопоставимость результатов различных моделей и позволяет точно определить, насколько хорошо система способна отличать правдивую информацию от манипулятивной, основываясь на фактических данных и логических аргументах. Использование подобных бенчмарков критически важно для развития надежных и прозрачных систем борьбы с распространением ложной информации.

Для повышения доверия и ответственности систем обнаружения дезинформации применяются методы, такие как LIME (Local Interpretable Model-agnostic Explanations). LIME позволяет выявить, какие конкретно элементы входных данных — слова, фразы или визуальные признаки — оказали наибольшее влияние на принятое моделью решение. Анализируя эти локальные объяснения, исследователи и пользователи могут лучше понять логику работы системы, выявить потенциальные предвзятости и убедиться в обоснованности ее выводов. Прозрачность, обеспечиваемая LIME, не только способствует более глубокому пониманию процессов принятия решений искусственным интеллектом, но и позволяет оперативно выявлять и корректировать ошибки, укрепляя тем самым доверие к технологиям обнаружения дезинформации.

Проведенные эксперименты, включающие анализ более двух миллионов токенов по 500 различным запросам, показали, что интеграция внешних источников знаний с моделью GPT-4o значительно повышает эффективность обнаружения мультимодальной дезинформации, касающейся климатических изменений. Данный подход позволяет модели не только анализировать текстовую информацию, но и учитывать факты, полученные из проверенных источников, что существенно снижает вероятность ошибочной идентификации правдивой информации как ложной и наоборот. Полученные результаты демонстрируют, что использование внешних знаний является ключевым фактором в борьбе с распространением климатической дезинформации и повышает надежность систем автоматического обнаружения ложной информации.

Исследование демонстрирует, что эффективность выявления мультимодальной дезинформации о климате значительно возрастает при интеграции внешних источников знаний. Авторы подчеркивают важность не полагаться исключительно на внутренние знания модели, а использовать проверенные данные из сети, включая обратный поиск изображений и фактчекинг. Это соответствует принципу, который часто озвучивает Линус Торвальдс: «Совершенство достигается не когда нечего добавить, а когда нечего убрать». В данном контексте, добавление внешних источников знаний позволяет «убрать» излишнюю неопределенность и повысить точность обнаружения ложной информации, упрощая и очищая процесс анализа.

Что дальше?

Представленная работа выявила закономерную, но часто игнорируемую истину: даже самые сложные языковые модели нуждаются в опоре на проверенные факты. Иллюзия всезнания, свойственная некоторым системам искусственного интеллекта, рассеивается при столкновении с конкретными, верифицируемыми данными. Улучшение обнаружения дезинформации о климате — это лишь частный случай более широкой проблемы: доверия к информации, генерируемой машинами.

Необходимо признать, что интеграция внешних источников знаний — не панацея. Поиск обратных изображений и веб-поиск подвержены собственным искажениям и манипуляциям. Будущие исследования должны сосредоточиться на оценке надежности этих источников и разработке методов выявления предвзятости. Важнее, однако, признать границы применимости любой автоматизированной системы. Точность — иллюзия, а погрешность — факт.

Следующим этапом представляется не столько создание «идеального» детектора дезинформации, сколько разработка инструментов, позволяющих пользователям критически оценивать информацию, независимо от ее источника. В конечном итоге, ответственность за истину лежит не на алгоритмах, а на людях. Стремление к совершенству — лишь оправдание для бесконечных улучшений, а ясность — это милосердие.

Оригинал статьи: https://arxiv.org/pdf/2601.16108.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- БИТКОИН ПРОГНОЗ. BTC криптовалюта

- ПРОГНОЗ ДОЛЛАРА К ШЕКЕЛЮ

- MYX ПРОГНОЗ. MYX криптовалюта

- ЭФИРИУМ ПРОГНОЗ. ETH криптовалюта

- SOL ПРОГНОЗ. SOL криптовалюта

- Золото прогноз

- ПРОГНОЗ ДОЛЛАРА К ЗЛОТОМУ

- ДОГЕКОИН ПРОГНОЗ. DOGE криптовалюта

- SAROS ПРОГНОЗ. SAROS криптовалюта

- РИППЛ ПРОГНОЗ. XRP криптовалюта

2026-01-25 21:44