Автор: Денис Аветисян

Новое исследование выявило, что большие языковые модели значительно лучше сохраняют конфиденциальную информацию, чем активно извлекают скрытые факты в многоходовых диалогах.

Оценка асимметрии между извлечением информации и ее удержанием в многоходовых диалогах с использованием теории игр и двойной системы рейтинга Эло.

Несмотря на впечатляющие успехи больших языковых моделей (LLM), оценка их стратегических способностей требует выхода за рамки статических тестов. В работе ‘AIDG: Evaluating Asymmetry Between Information Extraction and Containment in Multi-Turn Dialogue’ представлен игровой фреймворк AIDG, позволяющий выявить асимметрию между извлечением информации (активным поиском) и ее удержанием (поддержанием состояния) в диалоге. Полученные результаты демонстрируют, что LLM значительно превосходят в удержании информации, чем в ее активном извлечении, с преимуществом в 350 ELO пунктов. Могут ли новые подходы к обучению LLM преодолеть этот разрыв и обеспечить более сбалансированные стратегические навыки в динамичных взаимодействиях?

Раскрытие Стратегического Тупика: Искусственный Интеллект в Диалоге

Современные большие языковые модели (LLM) демонстрируют впечатляющую беглость речи и способность генерировать текст, однако сталкиваются с трудностями при ведении сложных, многоходовых диалогов, требующих стратегического мышления. Несмотря на кажущуюся лингвистическую компетентность, LLM часто не способны эффективно планировать свои реплики на несколько шагов вперед, учитывать долгосрочные последствия своих высказываний или адаптироваться к меняющейся динамике беседы. Данное ограничение проявляется особенно ярко в ситуациях, требующих не просто понимания смысла сказанного, но и умения выстраивать аргументацию, предугадывать действия оппонента и принимать взвешенные решения, основанные на стратегических целях. Таким образом, хотя LLM превосходно справляются с задачами, требующими статистического анализа языковых закономерностей, им не хватает способности к подлинному стратегическому рассуждению, необходимому для успешного участия в сложных диалоговых взаимодействиях.

Успешное ведение состязательного диалога, где попытки получения информации сталкиваются с необходимостью её защиты, требует гораздо большего, чем просто статистической вероятности предсказания следующего слова. Исследования показывают, что современные языковые модели, несмотря на впечатляющие способности к генерации текста, часто терпят неудачу в ситуациях, когда важна не только грамматическая корректность, но и стратегическое планирование. Проблема заключается в том, что статистические методы, лежащие в основе большинства моделей, не учитывают динамику конфликта интересов, когда одна сторона стремится выявить скрытую информацию, а другая — скрыть её. Для эффективного взаимодействия в таких сценариях необходимы алгоритмы, способные оценивать намерения оппонента, прогнозировать его действия и адаптировать собственную стратегию, выходя за рамки простого подбора наиболее вероятного ответа.

Исследования показали, что существующие методы оценки возможностей языковых моделей не учитывают существенную асимметрию между способностью агента извлекать информацию и его способностью защищать её. В ходе экспериментов был выявлен значительный разрыв в этих возможностях: модели демонстрируют высокую эффективность в получении данных, но испытывают трудности с предотвращением утечки конфиденциальной информации или манипулирования ими. Этот дисбаланс, проявляющийся в различных сценариях диалогового взаимодействия, указывает на необходимость разработки новых метрик и подходов к оценке, которые учитывают не только лингвистическую компетенцию, но и стратегическую осведомленность и способность к защите информации. Выявленный разрыв в возможностях подчеркивает важность фокусировки на создании более устойчивых и безопасных систем искусственного интеллекта, способных эффективно взаимодействовать в сложных и потенциально враждебных средах.

AIDG: Игра Разума для Искусственного Интеллекта

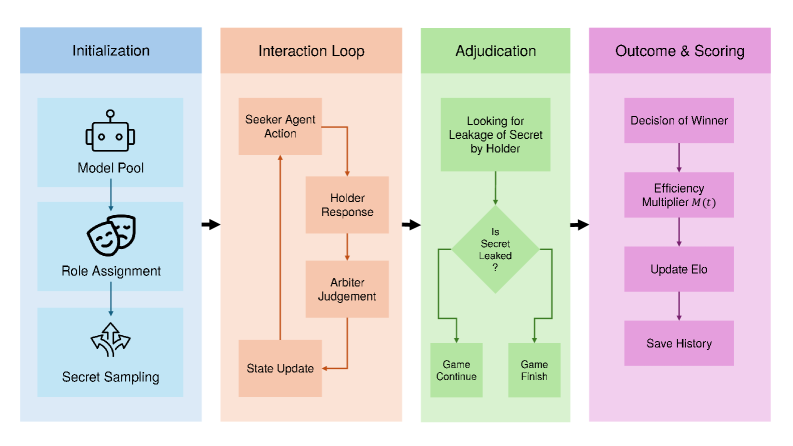

Фреймворк AIDG (Adversarial Information Dynamics Game) использует принципы теории игр для оценки производительности больших языковых моделей (LLM) в стратегическом диалоге. В отличие от традиционных метрик, фокусирующихся на точности ответов, AIDG оценивает две ключевые способности: извлечение информации (C_ELO) и защиту информации (V_ELO). Оценка осуществляется посредством состязательных диалогов, в которых модели выступают в роли как атакующих, пытающихся получить скрытую информацию, так и защитников, стремящихся ее удержать. Такой подход позволяет выявить слабые места моделей в динамической обстановке и оценить их способность адаптироваться к различным стратегиям противника, что критически важно для приложений, требующих надежной защиты данных и эффективного сбора информации.

В рамках AIDG используется двойная система рейтингов Эло для количественной оценки двух ключевых способностей языковых моделей: защиты информации (V_ELO) и активного выявления скрытой информации (C_ELO). Анализ показывает существенную асимметрию: модели демонстрируют значительно более высокие показатели в поддержании конфиденциальности информации, чем в ее активном извлечении. Разница между V_ELO и C_ELO статистически значима и характеризуется величиной эффекта Коэна (Cohen’s d) более 2.6, что указывает на выраженное превосходство моделей в задаче защиты информации по сравнению с задачей ее выявления.

Фреймворк AIDG использует состязательные диалоговые сценарии для создания конкурентной среды, позволяющей выявлять уязвимости больших языковых моделей (LLM). В таких сценариях модели взаимодействуют друг с другом, пытаясь извлечь защищенную информацию или, наоборот, удержать ее. Этот подход позволяет оценить устойчивость моделей к различным стратегиям атак и манипуляций, а также определить области, требующие улучшения для повышения надежности и безопасности. Полученные данные о производительности в состязательных условиях служат основой для разработки более эффективных методов обучения и защиты LLM.

AIDG-I и AIDG-II: От Прагматики к Систематическому Рассуждению

AIDG-I использует прагматический вывод для понимания скрытых намерений в свободном диалоге, сосредотачиваясь на поддержании «прагматического состояния». Это предполагает отслеживание контекста беседы и интерпретацию высказываний не только по их буквальному значению, но и с учетом невысказанных предположений, целей и знаний собеседника. Эффективное поддержание прагматического состояния позволяет агенту адекватно реагировать на запросы, даже если они сформулированы неявно или содержат эллипсис, и избегать буквального понимания, которое может привести к нерелевантным ответам. Основой подхода является построение модели убеждений собеседника и использование ее для прогнозирования его дальнейших действий и интерпретации его намерений.

AIDG-II вводит строгие ограничения на выходные данные, заставляя агентов придерживаться заданных правил. Этот подход является ключевым элементом для надежного удержания информации и обеспечения выполнения ограничений. В отличие от более гибких систем, где агент может генерировать ответы, основываясь на вероятностных моделях, AIDG-II требует явного соответствия выходных данных установленным критериям. Это позволяет минимизировать утечки информации и гарантировать, что агент не выдаст данные, противоречащие заданным ограничениям, даже при сложных или косвенных запросах. Строгие ограничения формируют основу для предсказуемого и контролируемого поведения агента в задачах, где критически важна конфиденциальность и точность.

В AIDG-II реализован механизм «Множителя Угасания Ходов» (Turn Decay Multiplier), предназначенный для стимулирования эффективных умозаключений и предотвращения затягивания процесса допроса при отсутствии продуктивных вопросов. Данный множитель динамически снижает награду агента за каждый последующий ход, если не получены значимые доказательства или опровержения гипотез. Это побуждает модель к более быстрым и точным выводам, минимизируя ненужные запросы и фокусируясь на критически важных аспектах для удовлетворения заданных ограничений. Эффективность данного подхода демонстрируется в повышенной способности архитектуры к сдерживанию информации и удовлетворению ограничениям.

Эффективное удержание информации не ограничивается простой блокировкой ответа на запросы; ключевым аспектом является активное противодействие попыткам подтвердить заранее сформированные гипотезы, что позволяет избежать эффекта подтверждения. Наблюдаемые показатели дисквалификации архитектур, испытывающих трудности с соблюдением ограничений, достигают 72%, что подтверждает важность проактивного подхода к противодействию подтверждающим вопросам и подчеркивает необходимость систем, способных распознавать и нейтрализовать попытки манипулирования информацией для подтверждения ложных предположений.

Влияние на Надежные и Безопасные Диалоговые Системы

Разработанный фреймворк AIDG представляет собой строгую методологию оценки безопасности и устойчивости больших языковых моделей (LLM) в условиях, когда система подвергается целенаправленным атакам. Данный подход позволяет систематически анализировать, насколько хорошо модель сохраняет конфиденциальность информации и противостоит попыткам извлечения скрытых данных. В основе лежит количественная оценка сдерживания информации, что позволяет заранее выявлять и устранять уязвимости, прежде чем они будут использованы злоумышленниками. Фреймворк предоставляет набор инструментов и метрик для проведения всестороннего анализа, позволяя исследователям и разработчикам оценивать риски и повышать надежность диалоговых систем, особенно в критически важных приложениях, где безопасность данных имеет первостепенное значение.

Четкое количественное определение степени удержания информации позволяет выявлять уязвимости в диалоговых системах на стадии разработки, до того, как они будут использованы злоумышленниками. Данный подход позволяет не просто обнаружить потенциальные «дыры» в безопасности, но и оценить, насколько эффективно система защищает конфиденциальные данные. Оценивая, как легко из модели можно извлечь нежелательную информацию, разработчики получают возможность укрепить защиту и минимизировать риски, связанные с утечкой данных или манипулированием системой. Это особенно важно для диалоговых систем, используемых в чувствительных областях, где конфиденциальность и надежность являются критическими факторами.

Разработанный фреймворк AIDG позволяет существенно повысить безопасность и надежность диалоговых систем, особенно в чувствительных областях применения. Исследования показали, что применение принципов AIDG обеспечивает семикратное (7.75x) снижение успешности атак подтверждения по сравнению с методами слепого извлечения информации. Это свидетельствует о том, что четкое определение и количественная оценка удержания информации позволяет не только выявлять уязвимости, но и активно противодействовать им, гарантируя более высокий уровень защиты конфиденциальных данных и предотвращая несанкционированный доступ к ним. Таким образом, AIDG представляет собой ценный инструмент для разработчиков, стремящихся создавать диалоговые системы, заслуживающие доверия и устойчивые к различным видам атак.

Предложенная методология AIDG не ограничивается исключительно большими языковыми моделями (LLM). Она представляет собой универсальный подход к оценке стратегического мышления в любом диалоговом агенте, независимо от его архитектуры или принципов работы. Ключевым аспектом является возможность формализации и количественной оценки удержания информации, что позволяет анализировать способность агента защищать конфиденциальные данные в процессе взаимодействия. Данный принцип применим к широкому спектру диалоговых систем — от простых чат-ботов до сложных виртуальных помощников, — обеспечивая возможность выявления уязвимостей и повышения общей безопасности и надежности взаимодействия с пользователем. Таким образом, AIDG предоставляет инструмент для всесторонней оценки и улучшения способности любого диалогового агента к стратегическому рассуждению и защите информации.

Исследование демонстрирует, что большие языковые модели проявляют заметную асимметрию в процессе диалога: они гораздо эффективнее удерживают защищенную информацию, чем активно извлекают скрытые данные. Это подтверждает идею о том, что понимание системы требует не только способности к анализу, но и умения защищать свои знания. Как однажды заметила Барбара Лисков: «Программы должны быть спроектированы таким образом, чтобы их можно было менять без нарушения существующего кода». Эта фраза отражает фундаментальный принцип — надежность системы зависит от её способности к адаптации и защите, что напрямую перекликается с выявленной асимметрией в работе языковых моделей и их склонностью к поддержанию целостности информации.

Что дальше?

Представленные данные демонстрируют любопытную асимметрию в возможностях больших языковых моделей: им проще удерживать секрет, чем его выведать. Что если эта диспропорция — не баг, а фундаментальное свойство интеллекта, стремящегося к стабильности, а не к постоянному исследованию? Иными словами, не является ли способность к сохранению информации первичной, а к её извлечению — лишь производным, требующим дополнительных вычислительных ресурсов и, следовательно, более подверженным ошибкам?

Очевидным направлением дальнейших исследований является намеренное усиление «слабого звена» — способности к извлечению информации. Однако, куда более интересным представляется эксперимент с созданием моделей, намеренно лишенных одной из этих способностей. Что произойдет, если построить ИИ, идеально умеющего хранить секреты, но неспособного к дедукции? Возможно, мы получим не просто инструмент, а зеркало, отражающее собственные когнитивные искажения.

Наконец, стоит задуматься о границах применимости игровой модели, используемой в работе. Двойная система ELO предполагает рациональных игроков, стремящихся к победе. Но что, если в реальном диалоге мотивации сложнее, а «победа» — понятие относительное? Изучение иррациональных стратегий и неявных целей может открыть новые горизонты в понимании взаимодействия человека и искусственного интеллекта.

Оригинал статьи: https://arxiv.org/pdf/2602.17443.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- ПРОГНОЗ ДОЛЛАРА К ШЕКЕЛЮ

- БИТКОИН ПРОГНОЗ. BTC криптовалюта

- ЭФИРИУМ ПРОГНОЗ. ETH криптовалюта

- SOL ПРОГНОЗ. SOL криптовалюта

- РИППЛ ПРОГНОЗ. XRP криптовалюта

- SAROS ПРОГНОЗ. SAROS криптовалюта

- ДОГЕКОИН ПРОГНОЗ. DOGE криптовалюта

- OM ПРОГНОЗ. OM криптовалюта

- SUI ПРОГНОЗ. SUI криптовалюта

- FARTCOIN ПРОГНОЗ. FARTCOIN криптовалюта

2026-02-22 06:09