Автор: Денис Аветисян

Новое исследование посвящено использованию нанокристаллов целлюлозы для повышения прочности и термостойкости биопластиков, открывая путь к экологически устойчивой альтернативе традиционным полимерам.

Исследование влияния целлюлозных нанокристаллов на механические и термические свойства полимерных нанокомпозитов для создания экологически чистых материалов.

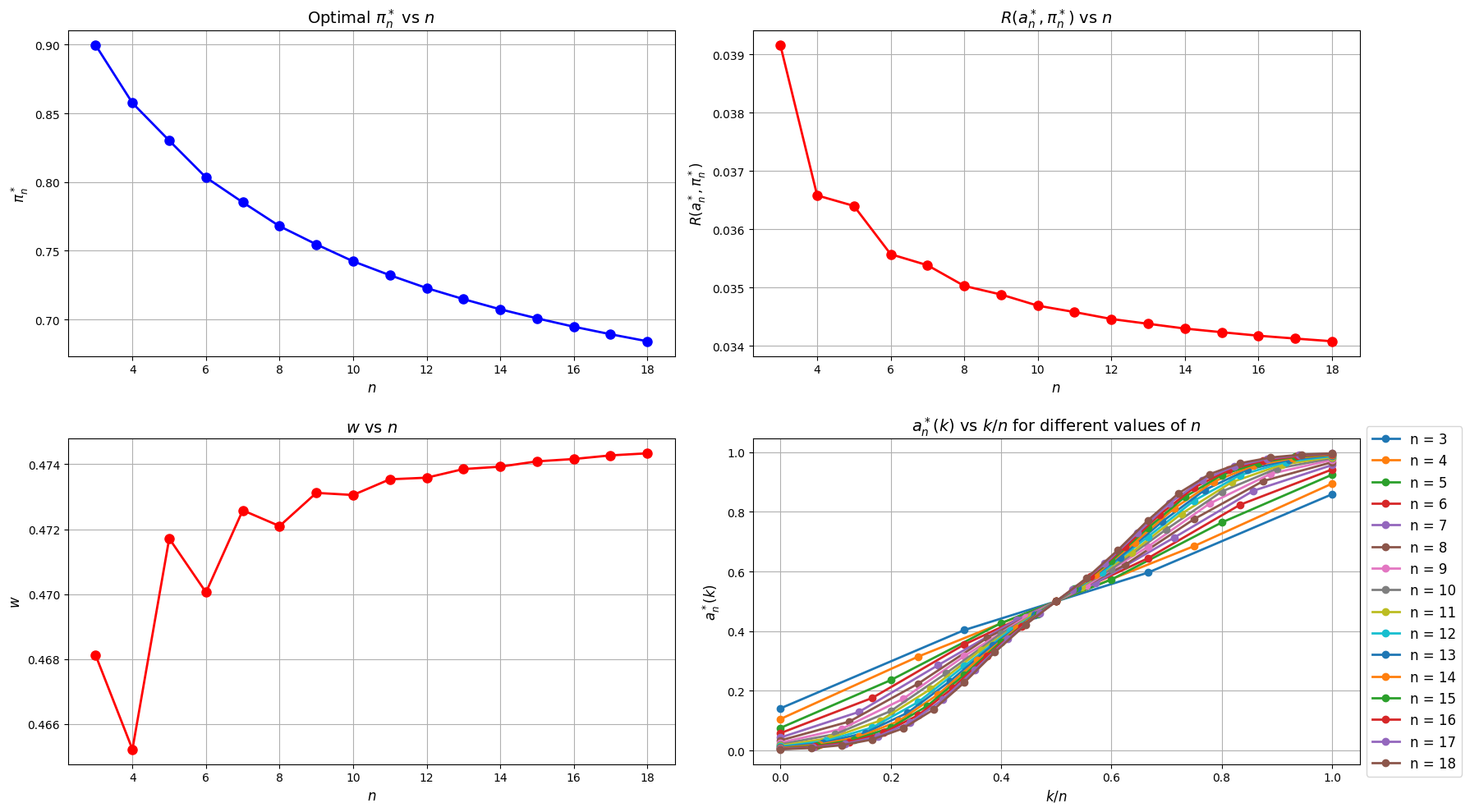

Несмотря на растущие объемы данных, процесс обучения принятия решений в условиях неопределенности и потенциально недоброкачественной информации остается сложной задачей. В работе ‘Learning Against Nature: Minimax Regret and the Price of Robustness’ разработана теоретическая основа для робастного обучения и формирования убеждений, рассматривающая взаимодействие агента и «Природы», выбирающей данные для максимизации сожаления агента. Показано, что оптимальная стратегия «Природы» заключается в создании неоднозначности, масштабируемой как 1/\sqrt{n}, что приводит к строго положительному сожалению даже при бесконечном объеме данных, однако, при наличии информативного сигнала, агент все же способен к обучению, хотя и с замедленной скоростью и систематической ошибкой. Какова цена робастности в задачах принятия решений и какие практические последствия имеет предложенная модель для разработки алгоритмов обучения в реальных условиях?

Иллюзии и Потенциал: Взгляд на Большие Языковые Модели

Современные большие языковые модели демонстрируют впечатляющие возможности в решении широкого спектра задач, кардинально меняя область обработки естественного языка. От автоматического перевода и создания текстов различного формата до ответов на вопросы и написания компьютерного кода — эти модели способны выполнять сложные лингвистические операции с уровнем точности, ранее недостижимым. Их способность анализировать огромные объемы текстовых данных и выявлять закономерности позволяет им генерировать связные, грамматически правильные и контекстуально релевантные тексты, открывая новые горизонты в автоматизации контента, поддержке клиентов и научных исследованиях. По сути, большие языковые модели представляют собой значительный шаг вперед в создании искусственного интеллекта, способного понимать и генерировать человеческий язык.

Большие языковые модели, несмотря на впечатляющие возможности, подвержены феномену, известному как «галлюцинации» — спонтанному генерированию фактологически неверной или бессмысленной информации. Это ограничение существенно снижает надежность таких моделей в критически важных приложениях, где точность данных имеет первостепенное значение. В отличие от традиционных систем, основанных на четких правилах и базах знаний, LLM оперируют вероятностями и статистическими закономерностями, что может приводить к правдоподобно звучащим, но совершенно ложным утверждениям. Исследователи активно работают над методами выявления и смягчения «галлюцинаций», включая улучшение качества обучающих данных, разработку механизмов проверки фактов и внедрение систем, способных оценивать степень достоверности генерируемого текста.

Существенным ограничением современных больших языковых моделей является их способность к логическому мышлению, особенно в ситуациях, требующих последовательного, многоступенчатого вывода. Исследования показывают, что, несмотря на впечатляющую способность генерировать связный текст, модели часто испытывают трудности при решении задач, требующих не простого поиска информации, а анализа, сопоставления фактов и построения логических цепочек. В частности, при решении комплексных задач, требующих нескольких этапов рассуждений, модели склонны к ошибкам, неспособности учесть все факторы или к принятию нелогичных решений. Это связано с тем, что модели обучаются на огромных объемах текста, выявляя статистические закономерности, но не обладают реальным пониманием смысла и причинно-следственных связей, что препятствует надежному выполнению сложных выводов и аналитических задач.

Масштаб современных больших языковых моделей (БЯМ) вызывает всё больше вопросов относительно их устойчивости и доступности. Для обучения и функционирования этих систем требуются колоссальные вычислительные ресурсы, огромные объемы данных и значительное энергопотребление. Это создает серьезные препятствия для исследователей и организаций с ограниченными ресурсами, фактически формируя барьер для входа в область разработки БЯМ. Более того, высокая стоимость обучения и развертывания ставит под сомнение экологическую устойчивость данной технологии, поскольку увеличивает углеродный след, связанный с информационными технологиями. Необходимость поиска более эффективных архитектур и методов обучения, а также развитие технологий, позволяющих снизить потребность в вычислительных ресурсах, становится критически важной задачей для обеспечения широкого доступа к преимуществам БЯМ и минимизации их негативного воздействия на окружающую среду.

Усиление Рассуждений: Методы для Повышения Эффективности

Метод “Chain-of-Thought Prompting” (Цепочка Мыслей) повышает способность больших языковых моделей (LLM) к рассуждениям за счет стимулирования явного изложения промежуточных шагов логической цепочки. Вместо прямого запроса ответа, LLM предлагается последовательно объяснить процесс достижения решения, что позволяет модели более эффективно использовать имеющиеся знания и избегать ошибок, возникающих при прямом прогнозировании. Этот подход особенно полезен при решении сложных задач, требующих многоступенчатых рассуждений, таких как математические задачи или логические головоломки. Исследования показывают, что даже относительно небольшие модели могут значительно улучшить свои результаты в задачах, требующих рассуждений, при использовании “Chain-of-Thought Prompting”.

Тонкая настройка на инструкциях (Instruction Tuning) представляет собой метод улучшения производительности больших языковых моделей (LLM) посредством обучения на разнообразном наборе инструкций и соответствующих ответов. Этот процесс позволяет модели обобщать знания и применять их к новым, ранее не встречавшимся задачам. В отличие от предварительного обучения на больших объемах неструктурированного текста, Instruction Tuning фокусируется на обучении модели понимать и следовать конкретным указаниям, что существенно повышает ее способность к решению задач, требующих логических выводов и адаптации к различным форматам запросов. Эффективность данной техники проявляется в улучшении результатов на широком спектре задач, включая ответы на вопросы, генерацию текста и выполнение команд.

Метод генерации с расширением извлечением (Retrieval-Augmented Generation, RAG) снижает вероятность галлюцинаций в больших языковых моделях (LLM) за счет сопоставления генерируемых ответов с извлеченными и верифицированными документами. Вместо того чтобы полагаться исключительно на параметры модели и внутренние знания, RAG сначала извлекает релевантную информацию из внешнего источника знаний (например, базы данных, корпуса документов) на основе запроса пользователя. Затем эта извлеченная информация используется в качестве контекста для генерации ответа, что позволяет модели обосновывать свои утверждения и уменьшать вероятность генерации неточной или вымышленной информации. Таким образом, RAG обеспечивает более надежные и проверяемые ответы, особенно в областях, требующих высокой точности и фактической обоснованности.

Современные исследования показывают, что способность больших языковых моделей (LLM) к рассуждениям определяется не только количеством параметров, но и способом обработки информации. Методы, такие как Chain-of-Thought Prompting, Instruction Tuning и Retrieval-Augmented Generation (RAG), демонстрируют значительное улучшение результатов даже у моделей с относительно небольшим размером. Это указывает на то, что оптимизация процессов обработки данных, включая явное представление этапов рассуждений, обучение на разнообразных инструкциях и использование внешних источников информации, играет ключевую роль в повышении логических способностей LLM, а не только увеличение вычислительных ресурсов.

Обучение с Ограниченными Данными: Подходы Few-Shot и Zero-Shot

Метод обучения с небольшим количеством примеров (Few-Shot Learning) позволяет большим языковым моделям (LLM) выполнять задачи, имея в распоряжении лишь ограниченное число обучающих данных — как правило, от одного до нескольких десятков примеров. Этот подход демонстрирует значительную способность к обобщению, позволяя моделям применять полученные знания к новым, ранее не встречавшимся данным. В отличие от традиционного обучения, требующего больших объемов размеченных данных, Few-Shot Learning эффективно использует предварительно полученные знания и способность к адаптации, что делает его особенно ценным в ситуациях, когда получение большого количества размеченных данных затруднено или невозможно. Успех Few-Shot Learning зависит от архитектуры модели и качества предварительного обучения, позволяющих эффективно экстраполировать знания на новые задачи.

Обучение с нулевыми примерами (Zero-Shot Learning) позволяет большим языковым моделям (LLM) выполнять задачи, для которых не было предоставлено ни одного обучающего примера. Вместо этого, модели используют знания, полученные в процессе предварительного обучения на обширных корпусах данных, для обобщения и применения к новым, невидимым задачам. Успех данного подхода зависит от способности модели к пониманию семантической близости между новыми задачами и информацией, уже содержащейся в её параметрах, что позволяет ей эффективно экстраполировать знания и выдавать релевантные результаты без необходимости явной адаптации.

Парадигмы обучения с малым количеством данных и без данных (few-shot и zero-shot learning) особенно ценны в ситуациях, когда размеченные данные ограничены или недоступны. Это открывает возможности для применения больших языковых моделей (LLM) в широком спектре областей, включая обработку редких языков, медицинскую диагностику с ограниченным количеством данных о пациентах, разработку специализированных чат-ботов для нишевых тем, а также автоматизацию задач в областях, где сбор и разметка данных являются дорогостоящими или трудоемкими. Возможность обобщения знаний, полученных в процессе предварительного обучения на больших корпусах текста, позволяет LLM эффективно адаптироваться к новым задачам даже при минимальном количестве примеров или их полном отсутствии.

Успешная реализация подходов обучения с небольшим количеством данных (few-shot и zero-shot) напрямую зависит от способности модели к логическому выводу, основанному на здравом смысле (commonsense reasoning) и символьном рассуждении (symbolic reasoning). Здравый смысл подразумевает использование накопленных знаний о мире для интерпретации информации и принятия решений в неоднозначных ситуациях. Символьное рассуждение, в свою очередь, включает в себя манипулирование абстрактными символами и правилами для вывода новых фактов или решений. Эффективное комбинирование этих двух типов рассуждений позволяет моделям обобщать знания, полученные в процессе предварительного обучения, и применять их к новым задачам даже при отсутствии или ограниченном количестве размеченных данных. Недостаточное развитие этих способностей приводит к ошибкам в интерпретации контекста и неверным выводам.

Путь к Эффективным и Согласованным Рассуждениям

Эффективность использования параметров является ключевым фактором для успешного внедрения больших языковых моделей (LLM) на устройствах с ограниченными ресурсами, таких как смартфоны или встраиваемые системы. Сокращение количества параметров, необходимых для функционирования модели, напрямую влияет на снижение требований к вычислительной мощности, объему памяти и энергопотреблению. Это не только делает LLM более доступными для широкого круга пользователей, но и существенно уменьшает их экологический след, поскольку требует меньше энергии для обучения и эксплуатации. Исследования в области параметрической эффективности направлены на разработку методов, позволяющих достичь сопоставимой производительности при значительно меньшем количестве параметров, используя такие подходы, как квантизация, прунинг и дистилляция знаний. В конечном итоге, оптимизация использования параметров открывает путь к более устойчивому и демократичному развитию искусственного интеллекта.

Совершенствование технологий, лежащих в основе больших языковых моделей, открывает перспективы для расширения доступа к мощным возможностям рассуждения для значительно более широкого круга пользователей и приложений. Ранее сложные задачи, требовавшие значительных вычислительных ресурсов, становятся доступными на устройствах с ограниченными возможностями, что стимулирует инновации в различных областях — от персональных ассистентов и образовательных платформ до специализированных инструментов для анализа данных и научных исследований. Это расширение доступа не только демократизирует технологии, но и способствует решению широкого спектра проблем, предоставляя инструменты для эффективного решения задач, которые ранее были недоступны для многих. В результате, потенциал больших языковых моделей для повышения производительности, улучшения качества жизни и стимулирования научного прогресса становится все более очевидным.

Ключевым фактором, определяющим будущее больших языковых моделей (LLM), является их соответствие человеческим ценностям и намерениям — процесс, известный как “выравнивание”. Успех LLM заключается не только в способности генерировать текст или решать сложные задачи, но и в том, чтобы их цели и поведение были предсказуемыми, безопасными и соответствовали этическим нормам. Достижение этого выравнивания требует разработки сложных механизмов, гарантирующих, что модели не будут генерировать вредоносный контент, не будут предвзяты и будут действовать в интересах человека. Именно согласованность целей и поведения LLM с человеческими установками позволит раскрыть весь потенциал этих инструментов в качестве надежных помощников в решении проблем и принятии решений, обеспечивая при этом их безопасное и ответственное использование.

Преодоление существующих трудностей в области разработки больших языковых моделей (LLM) открывает путь к их полноценному использованию в качестве надежных и полезных инструментов для решения сложных задач и принятия обоснованных решений. По мере совершенствования LLM, они смогут не только генерировать текст, но и анализировать информацию, выявлять закономерности и предлагать оптимальные стратегии в различных областях — от медицины и финансов до инженерии и научных исследований. Повышение надежности и точности этих моделей позволит автоматизировать рутинные процессы, ускорить темпы инноваций и предоставить экспертные знания широкому кругу пользователей, способствуя тем самым повышению эффективности и улучшению качества жизни. В конечном итоге, успешное решение этих задач позволит LLM стать неотъемлемой частью инфраструктуры принятия решений и катализатором прогресса в различных сферах деятельности.

Исследование, представленное в данной работе, демонстрирует стремление к созданию материалов, обладающих не только улучшенными характеристиками, но и устойчивостью к внешним воздействиям. Этот подход находит глубокий отклик в древней мудрости. Как говорил Конфуций: «Благородный муж ищет удобства для других, а сам стремится к трудностям». Аналогично, стремление к повышению термической и механической стабильности биопластиков, усиленных нанокристаллами целлюлозы, представляет собой поиск удобства и надежности для будущего, принимая при этом вызовы, связанные с разработкой устойчивых материалов. Оптимизация свойств полимерных нанокомпозитов требует целостного взгляда, поскольку каждая модификация может создавать новые точки напряжения в системе, влияя на её общую производительность.

Куда двигаться дальше?

Представленная работа, исследуя возможности армирования биопластиков нанокристаллами целлюлозы, демонстрирует, что даже самые элегантные решения не избавляют от необходимости учитывать сложность системы. Повышение термической и механической стабильности — это лишь первый шаг. Истинный вызов заключается в понимании долгосрочных взаимодействий между наполнителями и матрицей, а также в прогнозировании изменений свойств в условиях реальной эксплуатации. Простое увеличение концентрации нанокристаллов не является универсальным ответом; необходим поиск оптимального баланса, учитывающего не только прочность, но и пластичность, биоразлагаемость и стоимость.

Очевидно, что акцент должен быть смещен с односторонней оптимизации свойств на создание систем, способных к самовосстановлению или адаптации. Возможно, вдохновение следует искать не только в материаловедении, но и в биологических системах, где прочность и гибкость достигаются за счет сложной иерархической структуры. Задача состоит не в том, чтобы создать «вечный» материал, а в том, чтобы разработать систему, способную эффективно функционировать в течение заданного периода времени, а затем разлагаться, возвращаясь в природный цикл.

И, наконец, стоит признать, что устойчивость — это не только экологическая проблема, но и философская. Стремление к простоте и ясности в дизайне материалов — это отражение более широкого принципа, применимого ко всем сложным системам. Если решение слишком хитроумно, оно, вероятно, хрупко. В конечном итоге, долговечность любой системы определяется не ее сложностью, а ее способностью адаптироваться к изменяющимся условиям.

Оригинал статьи: https://arxiv.org/pdf/2602.15246.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- БИТКОИН ПРОГНОЗ. BTC криптовалюта

- ПРОГНОЗ ДОЛЛАРА К ШЕКЕЛЮ

- ЭФИРИУМ ПРОГНОЗ. ETH криптовалюта

- SOL ПРОГНОЗ. SOL криптовалюта

- РИППЛ ПРОГНОЗ. XRP криптовалюта

- ДОГЕКОИН ПРОГНОЗ. DOGE криптовалюта

- FARTCOIN ПРОГНОЗ. FARTCOIN криптовалюта

- SAROS ПРОГНОЗ. SAROS криптовалюта

- SUI ПРОГНОЗ. SUI криптовалюта

- OM ПРОГНОЗ. OM криптовалюта

2026-02-19 05:53