Автор: Денис Аветисян

Новое исследование систематизирует методы оценки устойчивости алгоритмов обнаружения объектов к преднамеренным искажениям и предлагает пути повышения их надежности.

В работе представлен унифицированный бенчмарк для оценки устойчивости детекторов объектов к состязательным атакам и анализируются стратегии состязательного обучения.

Несмотря на значительные успехи в области классификации изображений, обеспечение устойчивости систем обнаружения объектов к намеренным искажениям остается сложной задачей. В работе ‘Benchmarking Adversarial Robustness and Adversarial Training Strategies for Object Detection’ предложен унифицированный подход к оценке устойчивости и стратегий обучения, позволяющий объективно сравнивать различные атаки и методы защиты. Ключевым результатом является демонстрация низкой переносимости современных атак между архитектурами CNN и Vision Transformer, а также эффективности смешанного обучения на разнообразных атаках с различными целями. Сможем ли мы, используя предложенный бенчмарк, разработать более надежные и безопасные системы компьютерного зрения для критически важных приложений?

Хрупкость Современного Обнаружения Объектов

Современное компьютерное зрение, в частности область обнаружения объектов, переживает стремительное развитие благодаря таким алгоритмам, как YOLOv3, FasterRCNN, DETR и DINO. Несмотря на впечатляющие успехи в точности и скорости работы, эти системы оказываются на удивление уязвимыми. Достижения в области глубокого обучения позволили значительно улучшить способность компьютеров «видеть» и интерпретировать изображения, однако, эта же сложность делает их восприимчивыми к тонким, намеренно созданным искажениям. Удивительно, но даже незначительные изменения в исходном изображении могут привести к серьезным ошибкам в процессе обнаружения объектов, что ставит под вопрос надежность этих систем в критически важных приложениях.

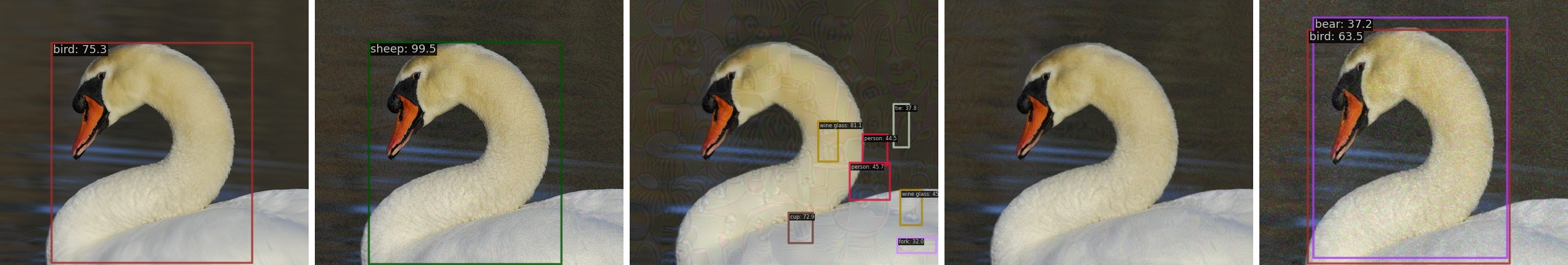

Современные системы обнаружения объектов, обученные на популярных наборах данных, таких как COCODataset и VOCDataset, демонстрируют неожиданную уязвимость к так называемым состязательным атакам. Эти атаки заключаются в добавлении к изображениям едва заметных, намеренно сконструированных изменений, которые способны кардинально снизить точность работы системы. В некоторых случаях, даже незначительные возмущения приводят к падению средней точности обнаружения (mAP) до 90%, что свидетельствует о недостаточной устойчивости алгоритмов к преднамеренным манипуляциям с входными данными. Данное явление подчеркивает необходимость разработки более надежных методов обнаружения объектов, способных противостоять подобным атакам и обеспечивать стабильную работу в реальных условиях.

Существенная проблема современных систем обнаружения объектов заключается в их недостаточной устойчивости к малейшим изменениям входных изображений. Даже незначительные, практически незаметные для человеческого глаза, возмущения могут привести к ошибочной классификации или полному пропуску обнаружения объекта. Это означает, что системы, казалось бы, хорошо обученные на обширных наборах данных, могут быть легко обмануты специально разработанными изменениями в пикселях, что ставит под сомнение их надежность в реальных условиях, особенно в критически важных приложениях, таких как автономное вождение или системы безопасности. Несмотря на впечатляющий прогресс в области компьютерного зрения, отсутствие надежной устойчивости остается серьезным препятствием для широкого внедрения этих технологий.

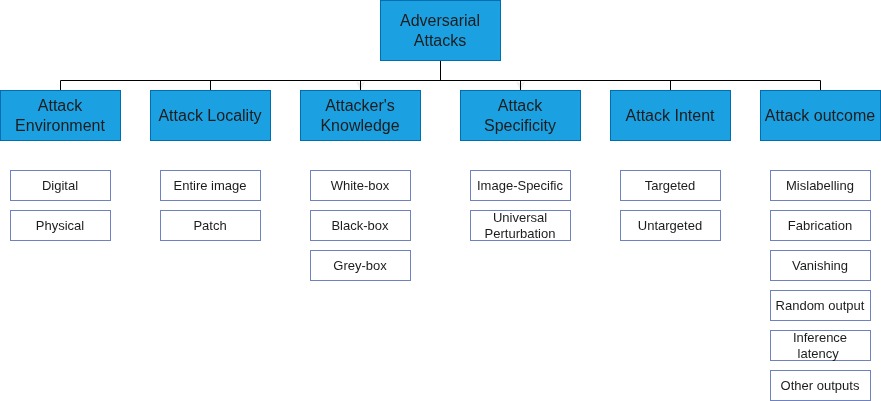

Механизмы Атак: Разрушая Визуальную Целостность

Атакующие методы в области обнаружения объектов не ограничиваются единым подходом, демонстрируя разнообразие стратегий для обхода систем обнаружения. К ним относятся OSFD (One-Step Feature Distillation), CAA (Contrast Augmentation Attack), EBAD (Efficient Black-box Attack to Deep Neural Networks) и даже создание так называемых “фантомных губок” — специальных паттернов, приводящих к ложным срабатываниям. В частности, алгоритм OSFD требует около 44 секунд для генерации атаки на одно изображение, что указывает на его вычислительную сложность и необходимость оптимизации для практического применения в реальном времени. Разнообразие этих методов подчеркивает потребность в комплексных стратегиях защиты, учитывающих различные векторы атак.

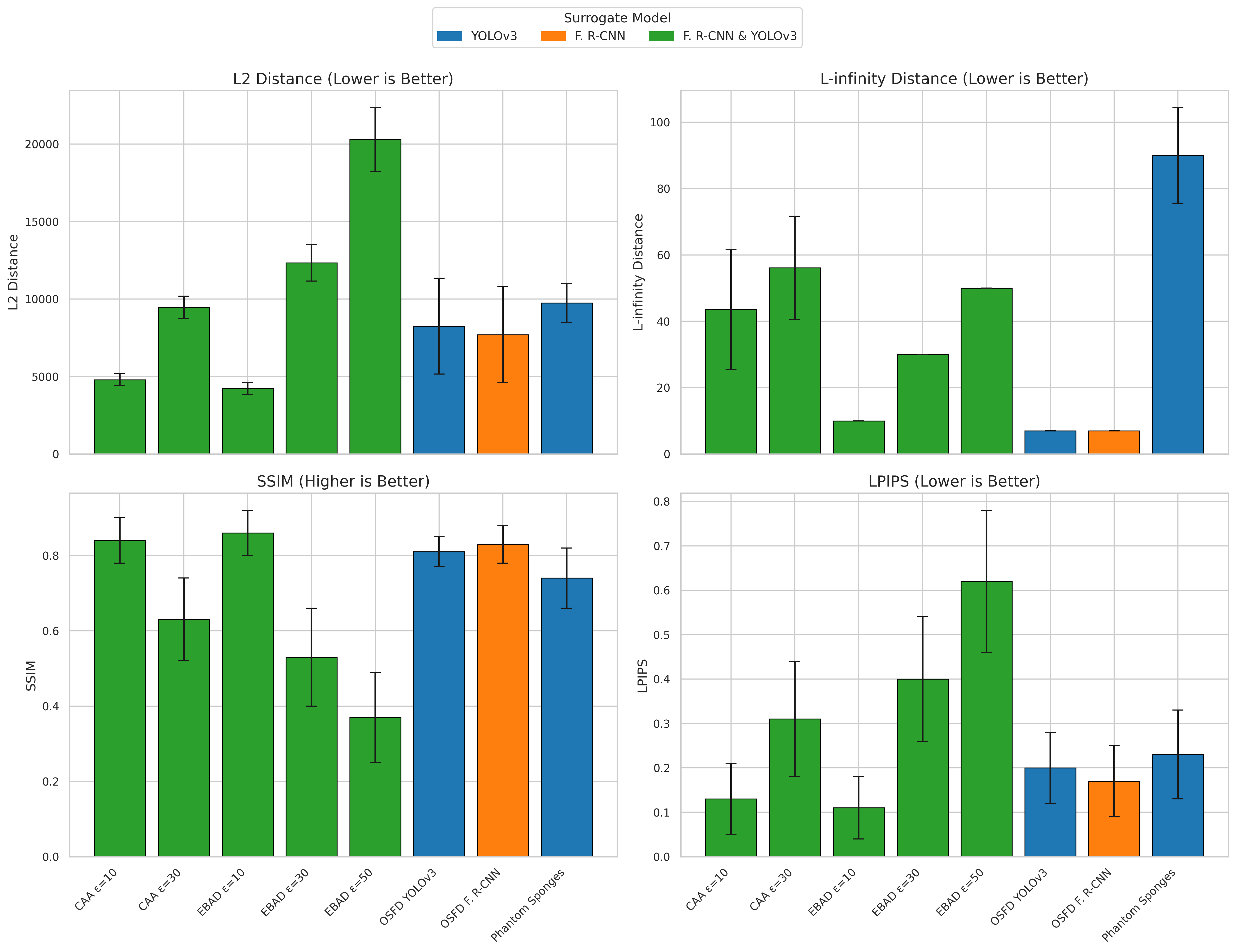

Атаки на системы обнаружения объектов эксплуатируют уязвимости в представлении признаков, используя математические нормы, такие как L2Norm и L\in fty Norm, для создания минимальных, но обманчивых изменений во входных данных. Метрика LPIPS (Learned Perceptual Image Patch Similarity), оценивающая перцептивное сходство изображений, показывает значения в диапазоне от 0.11 до 0.62, что свидетельствует о низкой корреляции между величиной возмущения, измеряемой L\in fty Norm, и восприятием этих изменений человеком. Это указывает на то, что оптимизация исключительно по L\in fty Norm не гарантирует создания атак, неразличимых для человеческого глаза, и требует использования более сложных метрик для оценки перцептивной близости.

Эффективность атак на системы обнаружения объектов напрямую указывает на критическую зависимость их работы от целостности входных данных. Любые, даже незначительные, изменения во входном изображении, созданные злоумышленником, могут привести к ложным срабатываниям или, наоборот, к пропуску реальных объектов. Это обусловлено тем, что современные алгоритмы глубокого обучения, лежащие в основе систем обнаружения, оперируют с числовыми представлениями изображений, и малейшие возмущения в этих представлениях могут существенно повлиять на процесс принятия решений. Понимание механизмов, лежащих в основе этих атак, включая используемые нормы L_2 и L_\in fty, а также метрики, оценивающие перцептивную близость, необходимо для разработки эффективных методов защиты и повышения надежности систем обнаружения объектов.

Укрепление Обороны: К Надежному Обнаружению Объектов

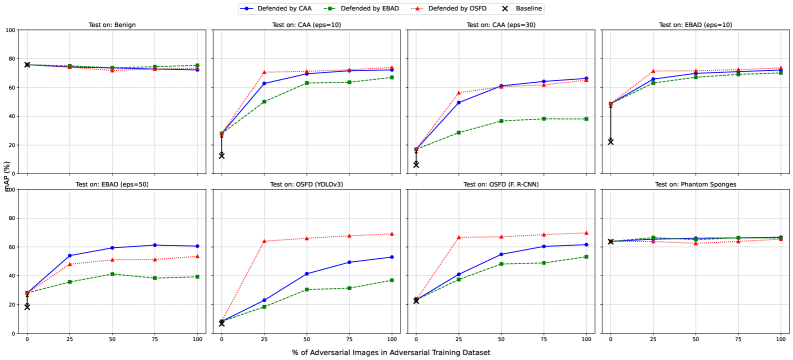

Адверсарная тренировка является ключевым методом повышения устойчивости детекторов объектов к злонамеренным воздействиям. Суть подхода заключается в целенаправленном добавлении в обучающую выборку примеров, намеренно искаженных (адверсарных), с целью научить детектор распознавать объекты даже при наличии незначительных, но тщательно подобранных изменений в изображениях. В процессе обучения детектор адаптируется к этим искажениям, что повышает его устойчивость к реальным атакам, основанным на манипулировании входными данными. Эффективность адверсарной тренировки напрямую зависит от качества и разнообразия используемых адверсарных примеров, а также от стратегии их интеграции в процесс обучения.

Переносимость атак представляет собой постоянную проблему в области объектного детектирования, требуя непрерывной адаптации стратегий обучения и защитных механизмов. Появление новых методов атак обуславливает необходимость регулярного обновления моделей и алгоритмов защиты. При этом, проведенные тесты показали, что все протестированные атаки оказались неэффективны при применении к современным архитектурам на основе трансформеров, таким как DINO, что указывает на повышенную устойчивость этих моделей к существующим угрозам и необходимость разработки принципиально новых подходов к атакам для их преодоления.

Оценка производительности детекторов объектов не ограничивается общей точностью; для оценки устойчивости к атакам необходимо использовать метрики, такие как mAP (mean Average Precision), APloc (Average Precision for Localization) и CSR (Count Suppression Ratio). Эксперименты показали, что обучение на комбинации атак OSFD (Object-aware Semantic Feature Distillation) и EBAD (Efficient Backdoor Attack Detection) обеспечивает более высокий показатель mAP по сравнению с обучением на использовании только одной из атак. Это демонстрирует преимущества использования дополнительных, взаимодополняющих атак при повышении надежности системы обнаружения объектов.

За пределами текущей защиты: Будущее надежного зрения

Перенос обучения представляется перспективным подходом к повышению устойчивости систем обнаружения объектов. Вместо обучения модели с нуля для каждой новой задачи или среды, перенос обучения позволяет использовать знания, полученные при решении схожих задач, и адаптировать их к текущей. Это особенно важно в условиях, когда сложно собрать достаточное количество данных для обучения в конкретной среде или при наличии специфических атак. Исследования показывают, что модели, обученные с использованием переноса обучения, демонстрируют значительно лучшую обобщающую способность и устойчивость к непредсказуемым изменениям в данных, таким как различные типы шума, искажения или даже преднамеренные атаки, направленные на обман системы. Таким образом, перенос обучения открывает путь к созданию более надежных и адаптивных систем компьютерного зрения, способных эффективно функционировать в реальных, динамично меняющихся условиях.

Исследования показывают, что существующие метрики оценки качества изображений часто расходятся с человеческим восприятием, что негативно сказывается на устойчивости систем компьютерного зрения к различным атакам и помехам. В частности, метрика LPIPS (Learned Perceptual Image Patch Similarity) позволяет более точно оценивать сходство изображений с точки зрения человеческого глаза, учитывая не только пиксельные различия, но и семантические особенности. Внедрение LPIPS и подобных метрик в процесс обучения детекторов объектов позволяет создавать системы, которые не только лучше распознают объекты в идеальных условиях, но и более устойчивы к шумам, изменениям освещения и даже целенаправленным искажениям, приближая их работу к человеческому зрению и повышая общую надежность.

В конечном итоге, создание действительно устойчивых систем обнаружения объектов требует перехода к моделям, которые ставят во главу угла семантическое понимание, а не поверхностное сопоставление признаков. Современные детекторы часто полагаются на выявление определенных текстур или форм, что делает их уязвимыми к даже незначительным визуальным искажениям, вызванным атаками или изменениями в окружающей среде. Более продвинутый подход заключается в обучении моделей “понимать”, что изображено на картинке, а не просто как оно выглядит. Это означает, что модель должна уметь абстрагироваться от несущественных деталей и фокусироваться на ключевых характеристиках объекта, определяющих его суть. Такой подход позволит системам надежно идентифицировать объекты даже в условиях сильных помех, изменения освещения или частичной видимости, приближая их к человеческому восприятию и обеспечивая более высокую степень надежности в реальных сценариях.

Исследование демонстрирует, что оценка устойчивости систем обнаружения объектов к неблагоприятным воздействиям требует комплексного подхода, учитывающего не только точность, но и перцептивные искажения. Авторы подчеркивают важность использования метрик, таких как LPIPS, для более адекватной оценки влияния атак на визуальное качество результатов. Как отмечал Эндрю Ын: «Самый быстрый способ узнать, работает ли что-то — это построить что-то». Этот принцип находит отражение в предложенном бенчмарке, который позволяет сравнивать различные стратегии защиты и выявлять наиболее эффективные решения для повышения устойчивости систем обнаружения объектов к adversarial атакам. Поиск закономерностей в поведении систем под воздействием возмущений является ключевым для разработки надежных и безопасных алгоритмов.

Куда двигаться дальше?

Представленная работа, несмотря на кажущуюся практичность создания унифицированного эталона для оценки устойчивости детекторов объектов, лишь обнажает глубину нерешенных вопросов. Попытка зафиксировать «устойчивость» в виде численной метрики, как и любая попытка свести сложность мира к однозначным показателям, неизбежно сталкивается с парадоксами. Успешное противодействие одному классу атак не гарантирует защиты от других, а перцептуальные метрики, такие как LPIPS, хоть и отражают визуальное сходство, не являются абсолютным мерилом семантической корректности.

В будущем необходимо сместить фокус с поиска «непробиваемых» детекторов на создание систем, способных адаптироваться к изменяющимся угрозам. Изучение механизмов самообучения и мета-обучения, позволяющих моделям извлекать уроки из атак и самостоятельно улучшать свою устойчивость, представляется более перспективным путем, чем бесконечная гонка вооружений между атаками и защитами. Более того, необходимо учитывать контекст применения детекторов — устойчивость, достаточная для автономного вождения, может быть избыточной для систем видеонаблюдения, и наоборот.

В конечном счете, понимание системы — это исследование её закономерностей, а не просто накопление статистических данных об успешных и неуспешных атаках. Каждое изображение — вызов для понимания, а не просто входная модель. Истинный прогресс в области устойчивости требует не только технических инноваций, но и философского переосмысления самой концепции «интеллекта» и его уязвимости.

Оригинал статьи: https://arxiv.org/pdf/2602.16494.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- БИТКОИН ПРОГНОЗ. BTC криптовалюта

- ПРОГНОЗ ДОЛЛАРА К ШЕКЕЛЮ

- ЭФИРИУМ ПРОГНОЗ. ETH криптовалюта

- SOL ПРОГНОЗ. SOL криптовалюта

- РИППЛ ПРОГНОЗ. XRP криптовалюта

- ДОГЕКОИН ПРОГНОЗ. DOGE криптовалюта

- SAROS ПРОГНОЗ. SAROS криптовалюта

- FARTCOIN ПРОГНОЗ. FARTCOIN криптовалюта

- SUI ПРОГНОЗ. SUI криптовалюта

- OM ПРОГНОЗ. OM криптовалюта

2026-02-19 12:41