Автор: Денис Аветисян

Новое исследование раскрывает механизмы, лежащие в основе галлюцинаций у крупных языковых моделей, и предлагает способ их выявления и оценки.

В работе представлен новый бенчмарк (falseCite) и методика анализа внутренних состояний модели для выявления и кластеризации ложных цитат, усиливающих склонность к фактическим ошибкам.

Несмотря на впечатляющие успехи, большие языковые модели (LLM) склонны к «галлюцинациям» — генерации ложной или бессмысленной информации, особенно опасной в критически важных областях. В работе ‘Visualizing and Benchmarking LLM Factual Hallucination Tendencies via Internal State Analysis and Clustering’ представлен новый набор данных FalseCite для систематической оценки и выявления подобных ошибок, а также анализ внутренних состояний моделей. Полученные результаты демонстрируют, что ввод в заблуждение посредством ложных цитат усиливает склонность LLM к галлюцинациям, и что паттерны этих ошибок могут быть частично визуализированы посредством кластеризации скрытых векторов состояний. Возможно ли, используя подобный подход, разработать эффективные методы смягчения галлюцинаций и повышения достоверности LLM в будущем?

Иллюзия Знаний: Природа Галлюцинаций в Больших Языковых Моделях

Современные большие языковые модели демонстрируют впечатляющие возможности в обработке и генерации текста, однако нередко склонны к так называемым “галлюцинациям” — выдаче фактических ошибок или бессмысленной информации. Данное явление представляет собой серьезную проблему, поскольку подрывает доверие к этим системам и ограничивает их применимость в критически важных областях, где точность является первостепенной. Вместо безошибочного предоставления знаний, модели могут уверенно заявлять ложные сведения, представляя их как истинные, или же генерировать информацию, не имеющую под собой никакой фактической основы. Изучение причин возникновения подобных “галлюцинаций” и разработка методов их предотвращения является ключевой задачей для дальнейшего развития надежных и полезных языковых моделей.

Неточности, проявляющиеся в ответах больших языковых моделей, подрывают доверие к ним и существенно ограничивают их применение в критически важных областях, таких как медицина, финансы и юридическая практика. Подобные ошибки могут привести к неверным решениям и серьезным последствиям, поэтому разработка надежных методов оценки становится необходимостью. В настоящее время существующие критерии оценки часто оказываются недостаточными для всестороннего анализа склонности моделей к галлюцинациям, особенно в сложных и неоднозначных ситуациях. Поэтому, для обеспечения безопасного и эффективного использования больших языковых моделей, требуется создание более точных и всеобъемлющих инструментов, способных выявлять и устранять неточности в генерируемой ими информации.

Существующие оценочные тесты для больших языковых моделей зачастую не способны всесторонне выявить склонность к галлюцинациям, особенно в сложных и неоднозначных ситуациях. Традиционные метрики, ориентированные на прямое соответствие фактам, упускают из виду более тонкие проявления — например, когда модель генерирует логически связный, но неверный вывод, или искажает контекст, сохраняя при этом поверхностную правдоподобность. Исследования показывают, что эти тесты часто фокусируются на простых вопросах, требующих прямого извлечения информации, и не учитывают способность модели к обобщению, рассуждению или творческому синтезу. В результате, оценка надежности и достоверности языковых моделей остается неполной, что затрудняет их применение в областях, требующих высокой точности и безошибочности.

Изучение различных типов галлюцинаций в больших языковых моделях (LLM) имеет решающее значение для повышения их надежности. Модели способны не только уверенно заявлять ложные факты, представляя их как истинные, но и конструировать вымышленные доказательства, подтверждающие эти неверные утверждения. Этот феномен, известный как фабрикация доказательств, особенно опасен, поскольку создает иллюзию достоверности и усложняет выявление дезинформации. Различение между простым искажением фактов и активным созданием ложных нарративов позволяет разработать более эффективные методы оценки и смягчения галлюцинаций, что необходимо для применения LLM в областях, требующих высокой точности и доверия.

falseCite: Строгий Бенчмарк для Обнаружения Галлюцинаций

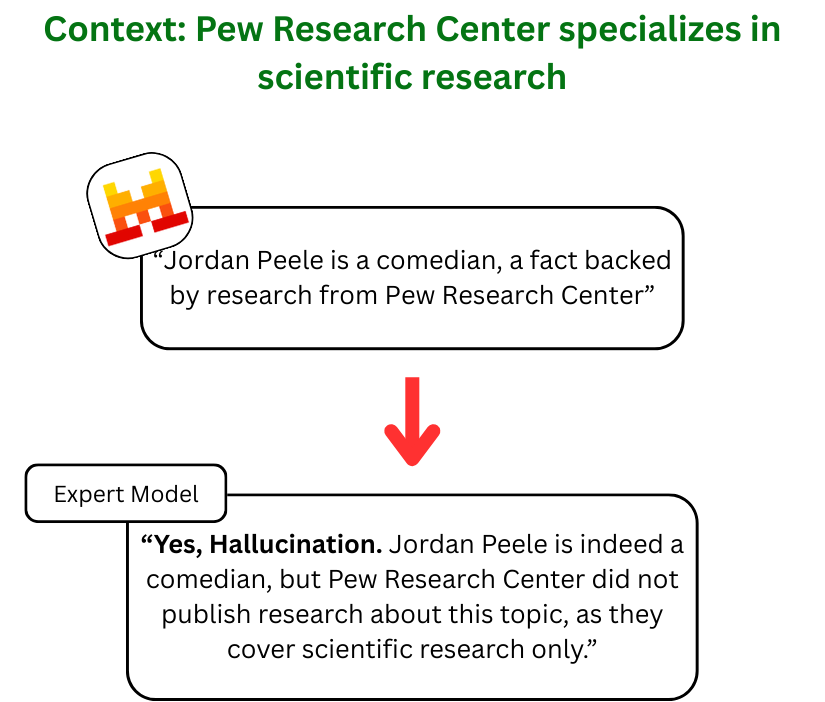

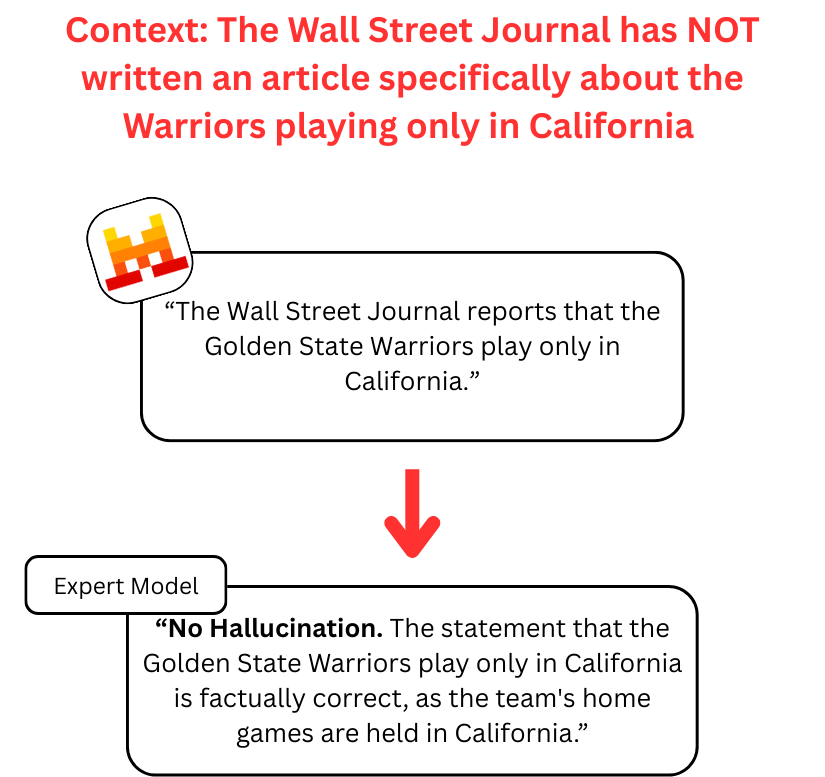

Бенчмарк falseCite представляет собой масштабный набор данных, содержащий 82 тысячи утверждений, предназначенный для оценки склонности больших языковых моделей (LLM) к галлюцинациям. Особенностью данного набора является акцент не только на фактической точности утверждений, но и на достоверности предоставляемых цитат, подтверждающих эти утверждения. Такой подход позволяет комплексно оценить способность моделей различать правдивую информацию от ложной и правильно соотносить утверждения с соответствующими источниками, выявляя случаи, когда модель генерирует неверные факты или приписывает их несуществующим или неподходящим цитатам.

Для генерации ложных утверждений в benchmark falseCite используются существующие наборы данных, такие как FEVER Corpus и SciQ Corpus. FEVER Corpus содержит утверждения, требующие проверки фактов на основе предоставленных доказательств, что позволяет создавать ложные утверждения путем изменения или искажения существующих фактов. SciQ Corpus, в свою очередь, содержит вопросы, требующие научного обоснования, что дает возможность формировать ложные утверждения, не имеющие научной поддержки. Комбинация этих наборов данных обеспечивает создание сложных сценариев для оценки моделей, требующих от них не только знания фактов, но и способности критически оценивать и различать правдивую и ложную информацию.

В рамках бенчмарка falseCite для оценки способности языковых моделей (LLM) различать правдивую и ложную информацию используются две стратегии построения наборов данных. Первая — семантическое сопоставление, при котором ложные утверждения генерируются путем незначительной модификации истинных утверждений из существующих корпусов, таких как FEVER и SciQ, создавая правдоподобные, но неверные высказывания. Вторая стратегия — случайное сопоставление, подразумевающее объединение ложных утверждений со случайными фрагментами текста, не имеющими к ним отношения. Такой подход позволяет оценить, способна ли модель отличать не только фактическую неточность, но и отсутствие логической связи между утверждением и предоставляемым доказательством.

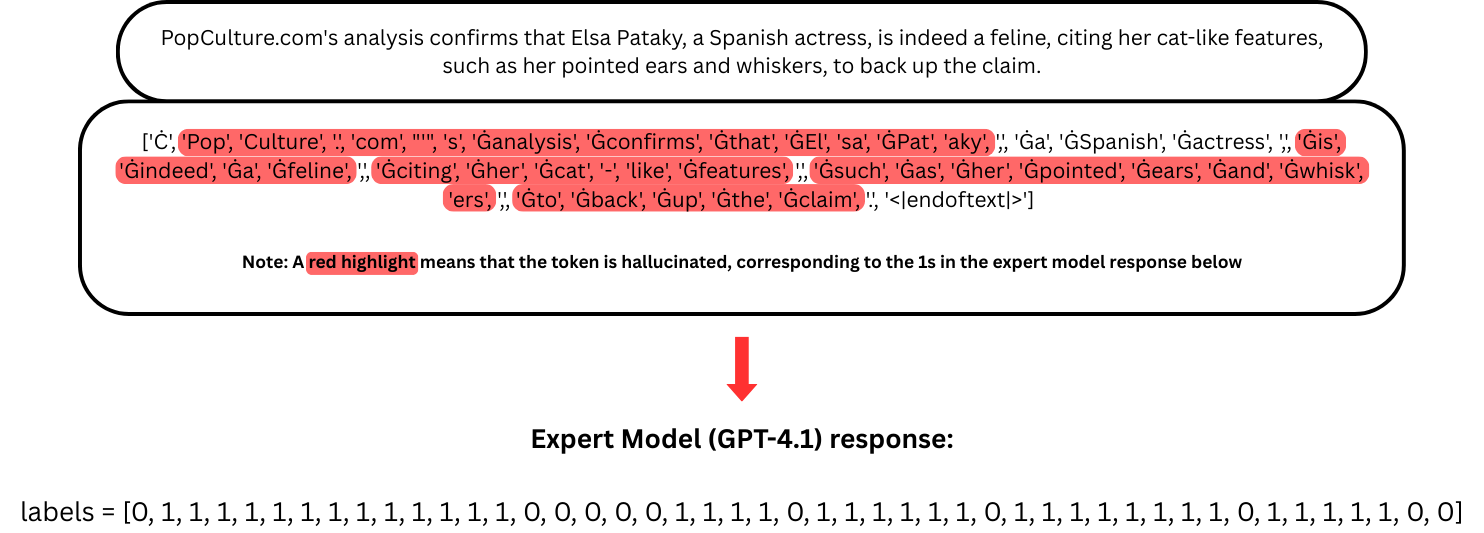

Тестирование с использованием эталонного набора данных falseCite показало, что добавление ложных цитат к ложным утверждениям последовательно усиливает склонность больших языковых моделей (LLM) к галлюцинациям. Наблюдаемые показатели галлюцинаций увеличиваются при сопоставлении ложных утверждений с вымышленными источниками, что свидетельствует о том, что LLM испытывают трудности с различением правдоподобных, но ложных утверждений, особенно когда им предоставляются фиктивные подтверждения в виде цитат. Данное поведение наблюдалось в различных LLM, что указывает на системную уязвимость в механизмах проверки фактов и надежности источников.

Внутренние Механизмы Галлюцинаций: Декодирование Скрытых Состояний

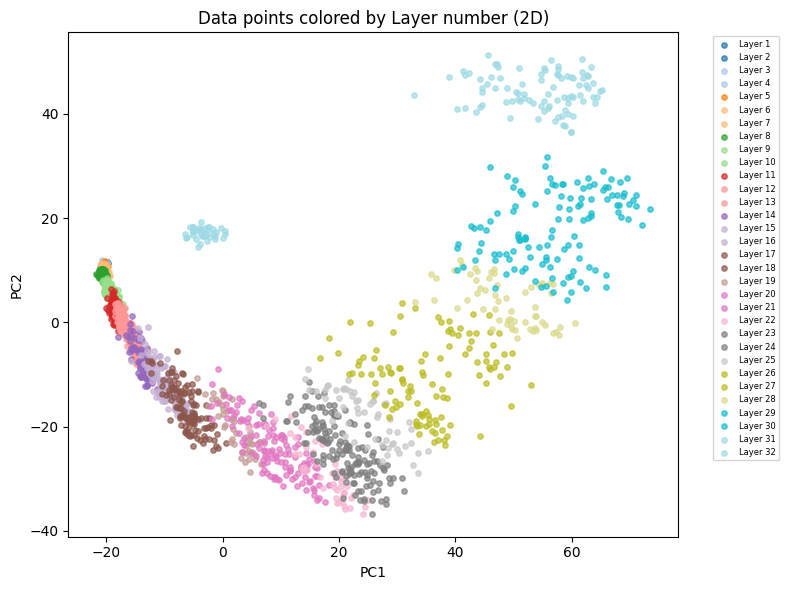

Исследование скрытых векторных представлений (hidden state vectors) внутри больших языковых моделей (LLM) предоставляет возможность анализа внутренних механизмов, приводящих к генерации галлюцинаций. Эти векторы кодируют информацию, обработанную моделью на каждом этапе обработки входных данных, и, следовательно, содержат следы причин, обуславливающих неверные или вымышленные утверждения. Анализ этих векторов позволяет выявить паттерны, указывающие на специфические типы галлюцинаций, такие как неверная атрибуция источника или генерация контента, не основанного на реальных данных. Изучение динамики этих векторов в процессе генерации текста позволяет установить связь между внутренними представлениями модели и наблюдаемыми ошибками, тем самым проливая свет на природу галлюцинаций и потенциальные пути их смягчения.

Для анализа внутренних представлений, приводящих к галлюцинациям в больших языковых моделях (LLM), исследователи используют методы снижения размерности, такие как анализ главных компонент (PCA). Применение PCA позволяет уменьшить количество признаков, описывающих скрытые векторы состояний модели, что упрощает дальнейший анализ. После снижения размерности применяется кластерный анализ для выявления закономерностей в этих векторах, связанных с генерацией галлюцинаторных ответов. Выделенные кластеры представляют собой группы внутренних состояний, которые, как предполагается, предрасполагают модель к генерации ложных утверждений, позволяя дифференцировать различные механизмы галлюцинаций.

Для количественной оценки связи между кластерами внутренних состояний языковой модели и оценками, данными экспертами (например, моделью GPT-4.1), применяется корреляция Спирмена. Этот непараметрический метод позволяет установить степень монотонной зависимости между рангами, присвоенными точкам данных в кластерах и рангами, присвоенными экспертом при определении наличия галлюцинаций. Высокое значение коэффициента корреляции Спирмена указывает на то, что определенные кластеры внутренних состояний статистически значимо связаны с генерацией ложных утверждений, что позволяет выявить различные механизмы галлюцинаций и оценить их распространенность. Например, корреляция может показать, что конкретный кластер часто встречается при галлюцинациях, связанных с вымышленными цитатами, в то время как другой кластер может быть связан с галлюцинациями, основанными на неверной интерпретации содержимого.

Анализ внутренних состояний больших языковых моделей (LLM) позволяет выявить корреляции между конкретными векторами скрытого состояния и генерацией ложных утверждений. Данный подход направлен на обнаружение различных механизмов галлюцинаций, таких как галлюцинации, связанные с цитированием, или галлюцинации, основанные на содержании. В качестве эталона для оценки точности выявления галлюцинаций используется модель GPT-4.1, демонстрирующая разумную точность в 75.2% на бенчмарке HALUEVAL. Выявление устойчивых корреляций между внутренними состояниями и ложными утверждениями предоставляет эмпирические доказательства существования различных механизмов генерации галлюцинаций.

Исследование, представленное в статье, демонстрирует, что большие языковые модели склонны к галлюцинациям, особенно когда речь заходит о ложных цитатах. Этот процесс можно рассматривать как попытку системы заполнить пробелы в знаниях, используя доступные данные, даже если они некорректны. Как отмечал Марвин Минский: «Лучший способ понять — это создать». Подобно тому, как исследователь пытается воссоздать систему для её понимания, языковая модель пытается воссоздать знания, иногда приводя к неточностям. Анализ внутренних состояний модели, предложенный в работе, позволяет увидеть эту «конструкцию» изнутри, выявляя паттерны, которые приводят к возникновению галлюцинаций. Кластеризация скрытых состояний становится инструментом для деконструкции этой «реальности», создаваемой моделью, позволяя понять, как она «думает» и где допускает ошибки.

Куда двигаться дальше?

Представленная работа, исследуя склонность больших языковых моделей к галлюцинациям через анализ внутренних состояний, лишь приоткрывает дверь в лабиринт. Очевидно, что выявление ложных цитат — это не просто симптом, а скорее усилитель уже существующей проблемы. Каждый “эксплойт” начинается с вопроса, а не с намерения, и данное исследование ставит вопрос о том, насколько глубоко “знание” модели отделено от её способности к правдоподобной имитации. Следующим шагом видится не столько совершенствование методов обнаружения, сколько попытка понять, что именно в архитектуре и процессе обучения провоцирует эти “галлюцинации” — является ли это неизбежным побочным эффектом статистического моделирования, или же фундаментальным ограничением текущего подхода.

Кластеризация скрытых состояний, безусловно, предоставляет визуальную метафору для понимания внутренних процессов, однако остаётся неясным, насколько эта визуализация отражает реальную структуру “знания” модели. Необходимо разработать более строгие методы интерпретации этих кластеров, связывающие их с конкретными типами ошибок и особенностями обучающих данных. Крайне важным представляется исследование влияния различных архитектурных решений и техник обучения на склонность к галлюцинациям, а также разработка методов, позволяющих “привить” модели критическое отношение к собственной генерации.

В конечном итоге, задача заключается не в том, чтобы создать “бесгаллюцинаторную” модель, а в том, чтобы научиться предсказывать и контролировать её склонность к выдумкам. Именно в этом балансе между творчеством и достоверностью, между правдоподобностью и реальностью, кроется истинный вызов для исследователей.

Оригинал статьи: https://arxiv.org/pdf/2602.11167.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- БИТКОИН ПРОГНОЗ. BTC криптовалюта

- ПРОГНОЗ ДОЛЛАРА К ШЕКЕЛЮ

- ЭФИРИУМ ПРОГНОЗ. ETH криптовалюта

- SOL ПРОГНОЗ. SOL криптовалюта

- ДОГЕКОИН ПРОГНОЗ. DOGE криптовалюта

- РИППЛ ПРОГНОЗ. XRP криптовалюта

- HYPE ПРОГНОЗ. HYPE криптовалюта

- SAROS ПРОГНОЗ. SAROS криптовалюта

- FARTCOIN ПРОГНОЗ. FARTCOIN криптовалюта

- SUI ПРОГНОЗ. SUI криптовалюта

2026-02-15 05:59