Автор: Денис Аветисян

Новый подход к кибербезопасности предлагает использовать искусственный интеллект для моделирования атак, чтобы эффективнее защищаться от всё более сложных угроз.

Разработка ИИ-агентов, способных к контролируемому поиску уязвимостей, необходима для укрепления киберзащиты в условиях автоматизированных атак.

Традиционные подходы к кибербезопасности полагаются на дефицит квалифицированных специалистов и ручной труд, ограничивая атакующих высокоценными целями. В работе под названием ‘To Defend Against Cyber Attacks, We Must Teach AI Agents to Hack’ утверждается, что развитие автономных агентов, способных к поиску и эксплуатации уязвимостей, нарушает этот баланс, делая неизбежными автоматизированные атаки в масштабе. Ключевой тезис заключается в том, что эффективная защита требует освоения наступательных возможностей искусственного интеллекта в контролируемой среде. Не станет ли создание собственных «взломщиков» с искусственным интеллектом необходимым условием для обеспечения безопасности в цифровом будущем?

Эволюция Киберпространства: Новые Векторы Угроз

Традиционные подходы к кибербезопасности, основанные на опыте специалистов и реагировании на уже совершенные атаки, все чаще оказываются неэффективными перед лицом постоянно усложняющихся угроз. По мере роста скорости и изощренности кибератак, человеческие возможности по анализу и нейтрализации угроз не успевают за динамикой злоумышленников. Ограниченность ресурсов и необходимость ручного вмешательства в процессы обнаружения и реагирования создают узкие места, которые эксплуатируются атакующими. В результате, организации вынуждены постоянно инвестировать в расширение штата специалистов и совершенствование инструментов, но даже это не гарантирует полной защиты, поскольку злоумышленники непрерывно адаптируются и разрабатывают новые методы атак, опережая существующие системы защиты.

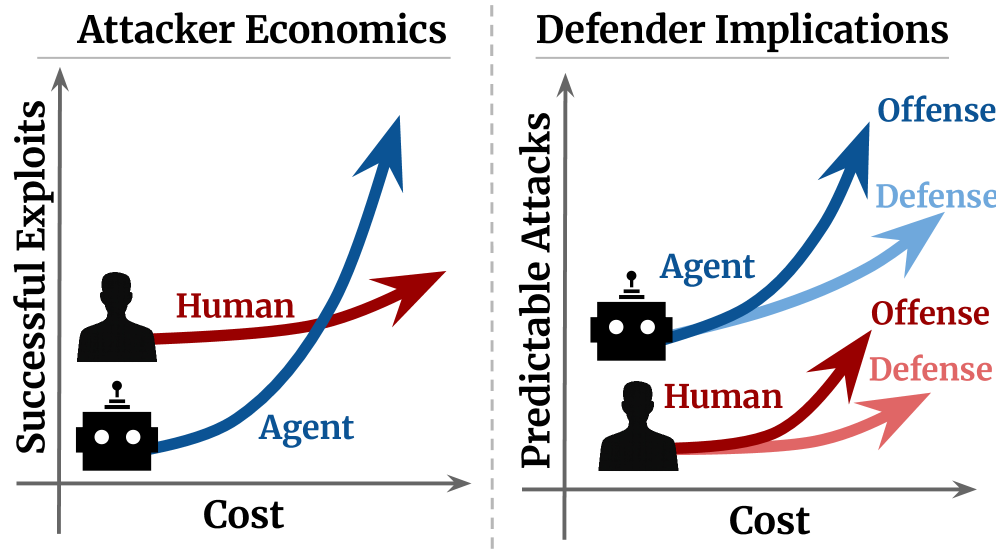

В настоящее время логика кибератак строится на принципах высокой вероятности успеха при минимальных затратах, что обуславливает постоянный поток угроз. Однако, с развитием искусственного интеллекта, эта тенденция, вероятно, усилится. Автоматизация, обеспечиваемая ИИ-агентами, значительно снижает стоимость проведения атак, делая их доступными более широкому кругу злоумышленников. Это приводит к изменению экономического баланса в киберпреступности: атаки, которые ранее были невыгодны из-за высоких затрат, становятся привлекательными, что ведет к увеличению их частоты и сложности. В результате, защита от киберугроз становится все более сложной задачей, требующей новых подходов и технологий, способных эффективно противостоять автоматизированным атакам.

Появление агентов искусственного интеллекта кардинально меняет парадигму кибербезопасности, становясь мощным инструментом как для злоумышленников, так и для защитников. Современные передовые модели демонстрируют существенные различия в производительности при тестировании на специализированных платформах, таких как Cybench, CVE-Bench и BountyBench. Эти расхождения указывают на необходимость дальнейшей разработки и совершенствования возможностей агентов в обеих областях — как в плане обнаружения и предотвращения атак, так и в плане их осуществления. В результате, фокус исследований смещается от традиционных методов реагирования на угрозы к созданию интеллектуальных систем, способных к автономной защите и проактивному выявлению уязвимостей, что представляет собой новую эру в кибербезопасности.

Проактивная Защита: Разведка в Области Наступательной Безопасности

Оборонительная стратегия, основанная на анализе данных об уязвимостях и моделировании атак с использованием агентов искусственного интеллекта, позволяет организациям выявлять слабые места в своей инфраструктуре до того, как они будут использованы злоумышленниками. Этот подход предполагает автоматизированное сканирование систем на предмет уязвимостей, эмуляцию действий атакующих и анализ полученных результатов для повышения уровня защиты. Проактивное выявление и устранение уязвимостей снижает риски компрометации данных и сбоев в работе систем, обеспечивая более надежную защиту от киберугроз.

Киберполигоны представляют собой контролируемые среды, предназначенные для моделирования реалистичных кибератак и тестирования защитных механизмов. Они позволяют организациям воссоздавать инфраструктуру, приложения и данные, чтобы безопасно оценивать эффективность средств защиты и тренировать специалистов по кибербезопасности. В рамках киберполигонов возможно развертывание различных сценариев атак, имитирующих действия злоумышленников, а также проведение анализа последствий и отработка процедур реагирования на инциденты. Это позволяет выявить уязвимости в системах, протестировать новые инструменты защиты и улучшить навыки персонала без риска для реальной инфраструктуры и данных.

Автоматизация обнаружения уязвимостей и разработки эксплойтов с использованием агентов искусственного интеллекта значительно увеличивает скорость и масштаб проведения оценок безопасности. Традиционные методы, требующие ручного анализа и тестирования, становятся неэффективными в условиях растущей сложности инфраструктур и увеличения числа атак. Использование ИИ позволяет автоматизировать сканирование, выявление слабых мест и даже генерацию рабочих эксплойтов, что позволяет охватить гораздо больший объем активов за меньшее время. Особенно важно, что снижение стоимости атак, обусловленное применением ИИ злоумышленниками, требует от организаций перехода к более проактивной и эффективной защите, основанной на автоматизированных инструментах и постоянном мониторинге угроз.

За Пределами Автоматизации: Агентивная Защита и Системный Подход к Безопасности

Агентивная защитная безопасность использует возможности ИИ-агентов для усиления традиционных методов смягчения уязвимостей, обеспечивая адаптацию к возникающим угрозам в режиме реального времени. В отличие от статических систем, агенты способны динамически анализировать сетевой трафик и поведение системы, выявляя аномалии и потенциальные атаки, которые могут быть пропущены сигнатурными системами обнаружения вторжений. Этот подход включает в себя автоматизированное применение патчей, изменение конфигураций безопасности и изоляцию скомпрометированных компонентов для минимизации ущерба. Агенты могут также учиться на новых данных об угрозах, постоянно улучшая свою способность обнаруживать и нейтрализовывать ранее неизвестные атаки, что значительно повышает устойчивость системы к развивающимся угрозам.

Агенты искусственного интеллекта могут использоваться для выполнения задач, связанных с проактивным тестированием на проникновение и красной командой. Этот подход позволяет автоматизировать процессы поиска уязвимостей в системах и приложениях, имитируя действия злоумышленников для выявления слабых мест. В отличие от традиционных методов, агенты ИИ способны адаптироваться к изменяющимся условиям и использовать различные тактики атак, что повышает эффективность обнаружения уязвимостей, которые могут быть пропущены при ручном тестировании. Результаты этих упражнений используются для улучшения безопасности систем и разработки более эффективных мер защиты.

Традиционные методы защиты часто концентрируются на уязвимостях отдельных компонентов системы, оставляя возможность для эксплуатации уязвимостей на системном уровне, возникающих из-за взаимодействия этих компонентов. Агентная защита выходит за рамки этого подхода, обеспечивая более целостную и надежную защиту, анализируя систему как единое целое и выявляя сложные векторы атак. Эффективное развертывание таких агентов требует обучения на масштабных корпусах данных по кибербезопасности, аналогично моделям, обученным на датасетах, таких как Foundation-Sec-8B, что позволяет им распознавать и реагировать на широкий спектр угроз и аномалий на уровне всей системы.

Смягчение Рисков ИИ: Согласование, Управление и Ограничители

Обеспечение соответствия искусственного интеллекта поставленным целям является критически важной задачей, особенно в контексте систем безопасности. Исследования показывают, что даже незначительные расхождения между намерениями разработчиков и фактическим поведением ИИ-агентов могут привести к непредсказуемым и потенциально опасным последствиям. Этот процесс, известный как «выравнивание ИИ», включает в себя разработку методов, гарантирующих, что алгоритмы ИИ не только достигают поставленных целей, но и делают это безопасным и предсказуемым образом. В приложениях, связанных с национальной безопасностью, критической инфраструктурой и автономными системами вооружений, даже небольшая ошибка в выравнивании может иметь катастрофические последствия, подчеркивая необходимость постоянного совершенствования методов контроля и верификации поведения ИИ.

Эффективное управление данными играет ключевую роль в обеспечении безопасности и надежности систем искусственного интеллекта. Контроль над данными, используемыми для обучения моделей, позволяет минимизировать риск проявления предвзятости и злонамеренного поведения. Некачественные или необъективные данные могут привести к тому, что ИИ будет принимать ошибочные или дискриминационные решения, что особенно критично в таких областях, как правосудие, здравоохранение и финансы. Внедрение строгих протоколов сбора, очистки и валидации данных, а также обеспечение прозрачности в отношении источников и методов обработки, является необходимым условием для создания ответственного и этичного искусственного интеллекта. Практики управления данными включают в себя аудит данных на предмет предвзятости, обеспечение конфиденциальности и безопасности, а также соблюдение нормативных требований в отношении защиты персональных данных.

Для смягчения потенциальных рисков, связанных с развитием искусственного интеллекта, всё большее значение приобретают так называемые «выходные ограждения» — механизмы фильтрации результатов работы моделей. Эти ограждения представляют собой систему правил и алгоритмов, предназначенных для блокировки или изменения контента, который может быть вредоносным, предвзятым, оскорбительным или иным образом нежелательным. Принципы работы этих ограждений варьируются от простых списков запрещенных слов и фраз до сложных моделей машинного обучения, способных анализировать семантическое содержание генерируемого текста или изображений. Эффективное внедрение выходных ограждений требует постоянного совершенствования алгоритмов, учитывающих контекст и нюансы языка, а также оперативного реагирования на новые типы вредоносного контента. Таким образом, эти механизмы выступают важным инструментом для обеспечения безопасного и ответственного использования искусственного интеллекта.

Будущее Кибербезопасности: Гонка Вооружений, Ведомая ИИ

Появление автоматизированных кибератак, превосходящих возможности человека, обуславливает необходимость постоянной инновационной гонки в области искусственного интеллекта, как в наступательных, так и в оборонительных стратегиях. Современные системы защиты уже не способны эффективно противостоять атакам, генерируемым ИИ, способным к самообучению и адаптации в реальном времени. Это требует от разработчиков не просто улучшения существующих алгоритмов, но и создания принципиально новых подходов к кибербезопасности, основанных на использовании искусственного интеллекта для прогнозирования, предотвращения и нейтрализации угроз. В сложившейся ситуации, непрерывный цикл исследований и разработок, направленных на усиление как атакующих, так и защитных возможностей ИИ, становится ключевым фактором поддержания стабильности в цифровом пространстве.

В ближайшем будущем, вероятно, ключевую роль в развитии агентов искусственного интеллекта для кибербезопасности сыграют большие языковые модели. Эти модели, обученные на огромных объемах текстовых данных, способны генерировать реалистичные фишинговые письма, имитировать человеческую речь для социальной инженерии и даже автоматически находить и эксплуатировать уязвимости в программном обеспечении. В то же время, аналогичные модели могут быть использованы для создания интеллектуальных систем обнаружения вторжений, способных анализировать сетевой трафик, выявлять аномалии и автоматически реагировать на угрозы. Таким образом, большие языковые модели становятся мощным инструментом как для атакующих, так и для защитников, определяя новый уровень сложности и автоматизации в киберпространстве и требуя постоянного совершенствования методов защиты.

Постоянная гонка вооружений в сфере кибербезопасности требует принципиально нового, проактивного подхода к защите данных и систем. Недостаточно реагировать на уже произошедшие атаки — необходимо непрерывно совершенствовать оборонительные стратегии и предвидеть потенциальные угрозы, возникающие в связи с развитием искусственного интеллекта. Прогнозируется существенное снижение стоимости осуществления кибератак благодаря автоматизации и использованию ИИ-агентов, что делает превентивные меры и адаптацию к новым вызовам критически важными для обеспечения безопасности в цифровом пространстве. Успешная защита в будущем будет зависеть от способности предвосхищать действия злоумышленников и быстро адаптироваться к изменяющейся обстановке, а не просто от реагирования на уже совершенные инциденты.

Исследование подчеркивает необходимость понимания атакующих стратегий для эффективной защиты, что находит отклик в словах Анри Пуанкаре: «Наука не состоит из ряда истин, а из методов, ведущих к истинам». Разработка искусственного интеллекта, способного к контролируемым атакам, представляется не просто инструментом защиты, а способом глубокого понимания уязвимостей системы. Подобный подход, акцентирующий внимание на обратных связях и взаимосвязанности элементов, позволяет создать более устойчивую и адаптивную систему безопасности. Именно понимание структуры атак, подобно пониманию структуры самой системы, определяет эффективность защиты, а не просто набор изолированных мер.

Куда двигаться дальше?

Представленная работа поднимает вопрос о парадоксальной необходимости создавать инструменты взлома, чтобы укрепить защиту. Если система держится на костылях, значит, мы переусложнили её, пытаясь предвидеть все возможные угрозы. Попытки создать универсальный щит, не понимая динамики атаки, обречены на провал. Следующим шагом видится не столько совершенствование алгоритмов обнаружения, сколько развитие способности к адаптации — создание систем, способных учиться на ошибках противника и предвосхищать новые векторы атак.

Модульность, безусловно, важна, но модульность без понимания контекста — иллюзия контроля. Необходимо сосредоточиться на разработке не просто отдельных «умных» агентов, а на создании целостной архитектуры, где взаимодействие этих агентов подчинено общей стратегии защиты. Иначе мы получим лишь набор изолированных инструментов, неспособных эффективно противостоять скоординированной атаке.

В конечном счете, успех в этой области зависит не от вычислительной мощности или сложности алгоритмов, а от глубины понимания фундаментальных принципов, лежащих в основе как защиты, так и нападения. Если мы стремимся создать надежную систему, необходимо взглянуть на неё глазами атакующего — понять его мотивацию, методы и слабые места нашей собственной архитектуры. Иначе, мы рискуем построить крепость из песка.

Оригинал статьи: https://arxiv.org/pdf/2602.02595.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- БИТКОИН ПРОГНОЗ. BTC криптовалюта

- ПРОГНОЗ ДОЛЛАРА К ШЕКЕЛЮ

- SOL ПРОГНОЗ. SOL криптовалюта

- ЭФИРИУМ ПРОГНОЗ. ETH криптовалюта

- Акции Южуралзолото ГК прогноз. Цена акций UGLD

- SAROS ПРОГНОЗ. SAROS криптовалюта

- РИППЛ ПРОГНОЗ. XRP криптовалюта

- ДОГЕКОИН ПРОГНОЗ. DOGE криптовалюта

- ПРОГНОЗ ЕВРО К ШЕКЕЛЮ

- FARTCOIN ПРОГНОЗ. FARTCOIN криптовалюта

2026-02-04 14:04