Автор: Денис Аветисян

Новое исследование показывает, как асимметрия информации о возможностях ИИ влияет на принятие решений и формирование рынка.

Ищешь ракеты? Это не к нам. У нас тут скучный, медленный, но надёжный, как швейцарские часы, фундаментальный анализ.

Бесплатный Телеграм канал

Асимметрия информации о реальных возможностях систем искусственного интеллекта препятствует эффективному внедрению и требует разработки продуманных механизмов прозрачности.

Несмотря на растущий потенциал искусственного интеллекта, асимметрия информации о его возможностях создает серьезные препятствия для широкого внедрения. Данное исследование, озаглавленное ‘When Life Gives You AI, Will You Turn It Into A Market for Lemons? Understanding How Information Asymmetries About AI System Capabilities Affect Market Outcomes and Adoption’, экспериментально демонстрирует, что информационная асимметрия негативно влияет на принятие решений о делегировании задач ИИ. Установлено, что частичное раскрытие информации о качестве систем ИИ может улучшить эффективность принятия решений, однако полное раскрытие не гарантирует оптимального использования. Какие механизмы прозрачности необходимо разработать, чтобы обеспечить доверие к ИИ и максимизировать его пользу для общества?

Скрытые риски интеграции искусственного интеллекта

Широкое внедрение искусственного интеллекта происходит в условиях существенной информационной асимметрии между разработчиками и пользователями. В то время как создатели систем ИИ обладают глубоким пониманием их возможностей и ограничений, конечные пользователи зачастую взаимодействуют с этими технологиями, не имея достаточного представления о принципах их работы или потенциальных рисках. Эта диспропорция знаний создает ситуацию, когда потребители не могут в полной мере оценить качество и надежность предлагаемых решений, что может привести к необоснованным ожиданиям, неправильному использованию и, как следствие, к снижению доверия к технологиям искусственного интеллекта в целом. Отсутствие прозрачности в отношении алгоритмов и данных, используемых в системах ИИ, усугубляет эту проблему, создавая барьер для осознанного принятия решений и эффективного использования преимуществ искусственного интеллекта.

Ситуация, возникающая при широком внедрении искусственного интеллекта, напоминает рынок “лимонов”, где покупатель не может достоверно оценить качество товара до совершения покупки. Аналогично, пользователи часто не обладают достаточной информацией для оценки надежности и эффективности систем ИИ, что создает благоприятную почву для распространения низкокачественных или предвзятых алгоритмов. Это, в свою очередь, подрывает доверие к технологиям искусственного интеллекта в целом и препятствует полноценной реализации их потенциальных преимуществ. Подобная ситуация может привести к тому, что даже действительно полезные системы ИИ будут отвергнуты из-за опасений, вызванных опытом взаимодействия с некачественными аналогами, замедляя прогресс и ограничивая возможности для инноваций.

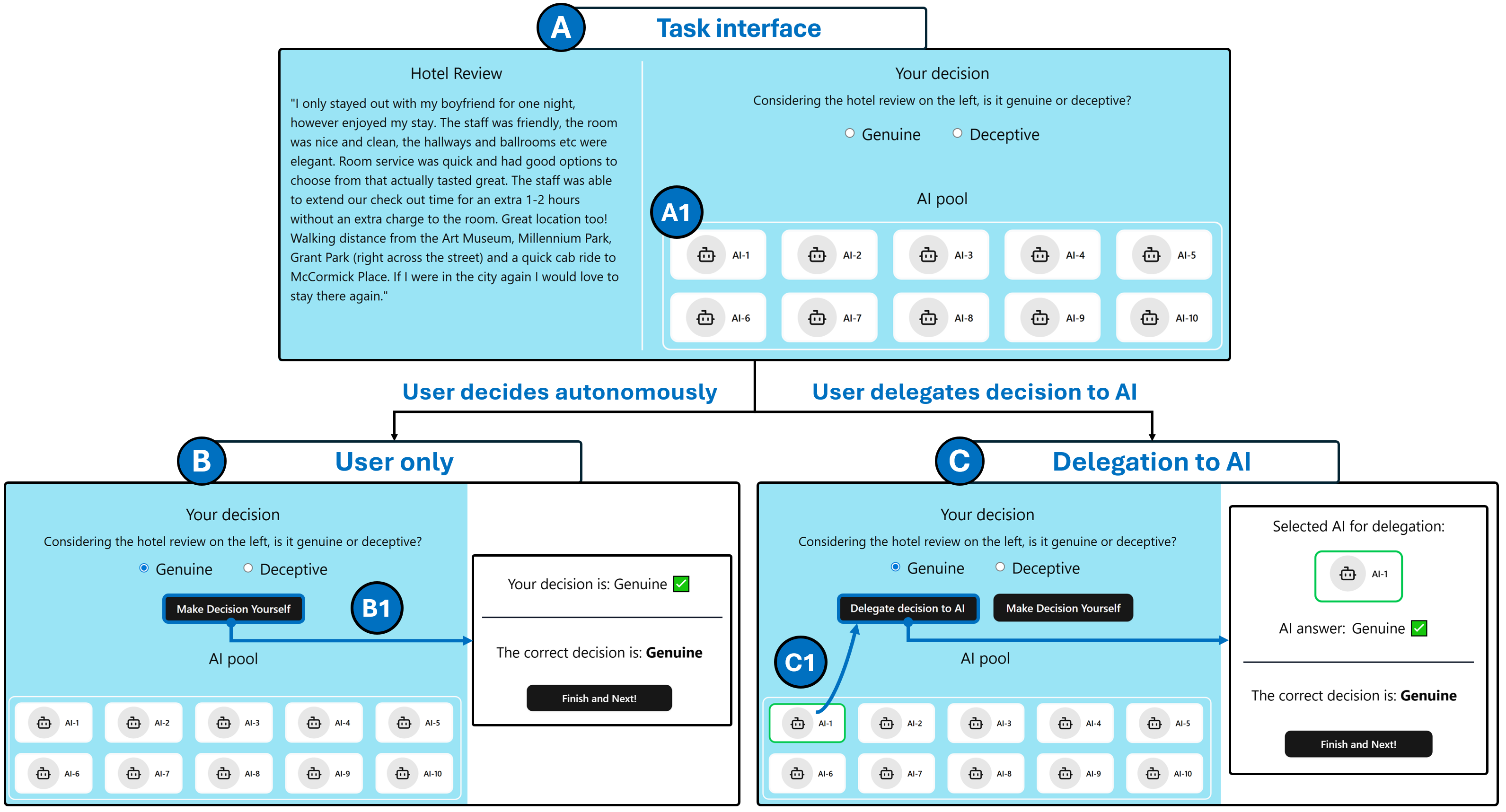

Степень, в которой пользователи передают принятие решений искусственному интеллекту, напрямую влияет на их уязвимость к потенциальным рискам. Чем больше доверия и ответственности возлагается на алгоритмы, тем меньше возможностей для критической оценки и контроля со стороны человека. В ситуациях, где ИИ принимает решения без достаточного надзора, ошибки или предвзятости в алгоритмах могут привести к нежелательным последствиям, затрагивающим финансовую стабильность, личную свободу или даже физическое благополучие. По сути, передача контроля над важными аспектами жизни ИИ создает ситуацию, в которой человек становится зависимым от системы, чьи внутренние механизмы могут быть непрозрачными или недостаточно надежными. Особенно уязвимы те, кто не обладает достаточными знаниями или опытом для оценки результатов работы ИИ и выявления потенциальных ошибок.

Полноценная реализация преимуществ искусственного интеллекта остаётся недостижимой, если не устранить существующий дисбаланс между разработчиками и пользователями. Неравномерный доступ к информации о возможностях и ограничениях систем ИИ создаёт ситуацию, когда даже потенциально полезные технологии могут быть отвергнуты из-за недоверия или разочарования. Отсутствие прозрачности в работе алгоритмов и сложность оценки их надёжности приводят к тому, что пользователи опасаются делегировать важные решения искусственному интеллекту, что, в свою очередь, замедляет внедрение инноваций и сдерживает экономический рост. Поэтому, для раскрытия всего потенциала ИИ, необходимо обеспечить более справедливое распределение информации и создать механизмы, позволяющие пользователям оценивать и контролировать работу интеллектуальных систем.

Прозрачность как лекарство: стратегии раскрытия информации

Предоставление пользователям информации о возможностях ИИ-систем, в частности, об их точности и качестве данных, является критически важным шагом для снижения информационной асимметрии. Недостаток информации о производительности системы создает дисбаланс, при котором пользователи не могут адекватно оценить надежность и применимость ИИ-решений. Сообщение данных о точности (например, процент правильно классифицированных примеров) и происхождении данных (источники, методы сбора, потенциальные смещения) позволяет пользователям формировать обоснованные ожидания и принимать более взвешенные решения относительно использования ИИ-систем. Отсутствие такой информации может привести к неоправданному доверию к неточным системам или, наоборот, к отказу от полезных инструментов из-за недооценки их возможностей.

Раскрытие информации о работе систем искусственного интеллекта выступает ключевым механизмом, позволяющим пользователям формировать адекватное доверие и принимать обоснованные решения. Предоставление данных о возможностях и ограничениях ИИ-систем, включая точность и качество используемых данных, позволяет пользователям оценить надежность системы и соответствующим образом скорректировать свои ожидания. Это, в свою очередь, снижает риск принятия неверных решений, основанных на нереалистичных представлениях о возможностях искусственного интеллекта, и способствует более эффективному взаимодействию с технологией. Калибровка доверия, основанная на прозрачности, является необходимым условием для успешного внедрения и использования ИИ-систем в различных областях.

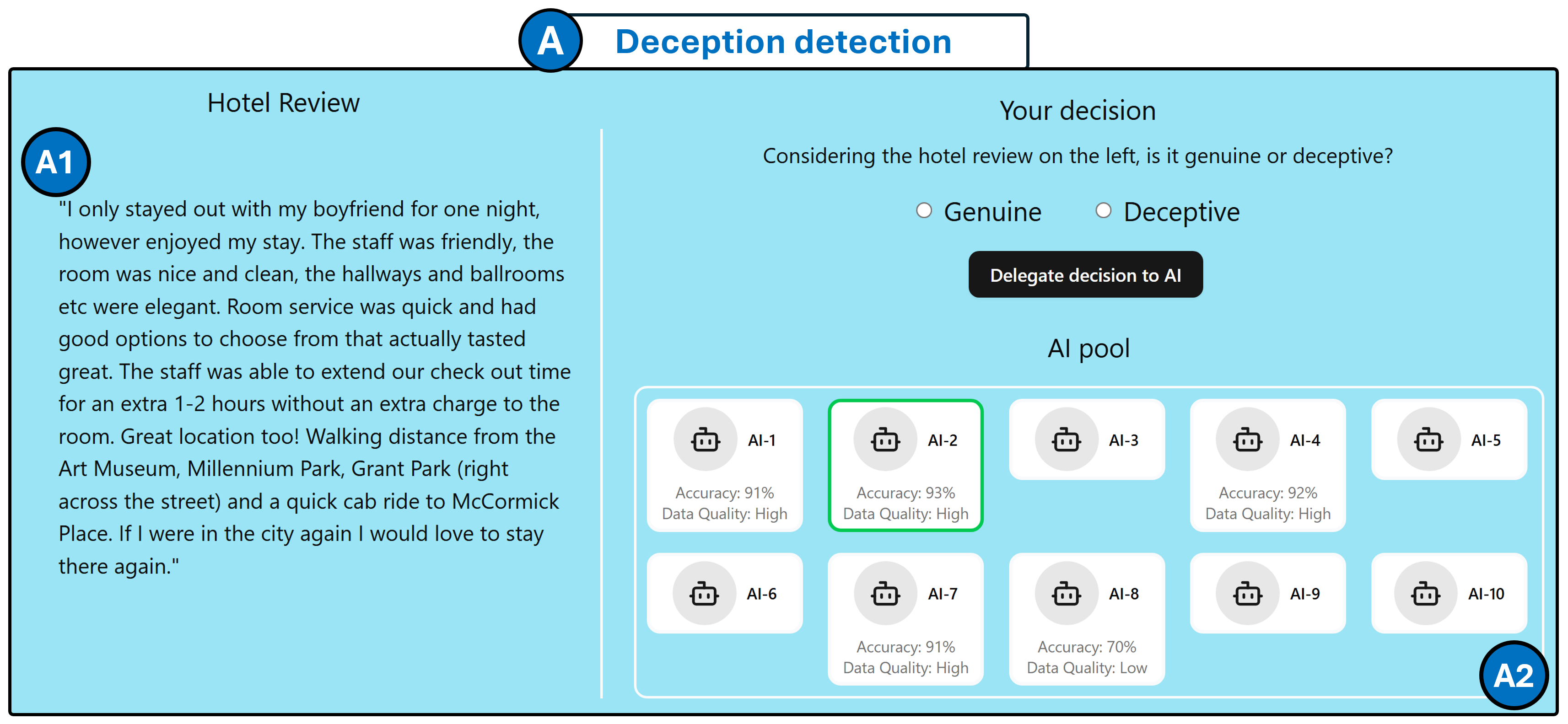

Существуют различные стратегии раскрытия информации об ИИ-системах, варьирующиеся от полной прозрачности (FullDisclosure), при которой предоставляется исчерпывающая информация о принципах работы, данных обучения и ограничениях системы, до частичного раскрытия (PartialDisclosure), подразумевающего предоставление только ключевых характеристик, таких как точность и качество данных. FullDisclosure требует значительных ресурсов для документирования и может быть сложна для восприятия пользователями. PartialDisclosure, напротив, обеспечивает более лаконичное представление информации, облегчая процесс принятия решений, однако может не охватывать все важные аспекты, необходимые для полного понимания возможностей и ограничений системы. Выбор стратегии зависит от конкретного контекста использования ИИ, целевой аудитории и доступных ресурсов.

Наше исследование показало, что частичное раскрытие информации о качестве работы ИИ-систем значительно повышает эффективность принятия решений пользователями. В ходе экспериментов было установлено, что предоставление данных о точности и надежности системы позволяет пользователям более эффективно отсеивать низкокачественные ИИ-решения и концентрироваться на тех, которые демонстрируют приемлемый уровень производительности. Это приводит к сокращению времени, затрачиваемого на оценку и выбор ИИ-системы, а также к снижению вероятности принятия ошибочных решений, основанных на недостоверных данных или неадекватных алгоритмах.

Навигация по человеческой погрешности: доверие и калибровка

Пользователи не оценивают возможности искусственного интеллекта (ИИ) объективно; на их восприятие и степень доверия к ИИ-системам оказывают влияние когнитивные искажения. Это означает, что субъективные предубеждения, такие как эвристика доступности или предвзятость подтверждения, могут приводить к переоценке или недооценке реальной надежности ИИ. Например, недавние негативные опыты взаимодействия с ИИ могут усилить скептицизм, даже если текущая система демонстрирует высокую производительность. Напротив, положительный первоначальный опыт может создать необоснованное доверие, приводящее к чрезмерной делегации задач, несмотря на возможные ошибки. Эти когнитивные факторы существенно влияют на процесс принятия решений пользователем и требуют учета при разработке и внедрении ИИ-систем.

Успешная интеграция систем искусственного интеллекта (ИИ) требует процесса, названного “Калибровкой доверия” (TrustCalibration), который представляет собой динамическую корректировку степени полагания на ИИ пользователем, основанную на наблюдаемой производительности системы. Этот процесс подразумевает, что пользователи не должны слепо доверять или отвергать ИИ, а должны адаптировать уровень делегирования задач в зависимости от фактических результатов, демонстрируемых системой в различных ситуациях. Эффективная калибровка доверия позволяет пользователям извлекать максимальную пользу из возможностей ИИ, избегая как чрезмерной зависимости от ненадежных систем, так и неоправданного отказа от полезных инструментов. По сути, это непрерывный цикл оценки производительности ИИ и соответствующей корректировки стратегии взаимодействия.

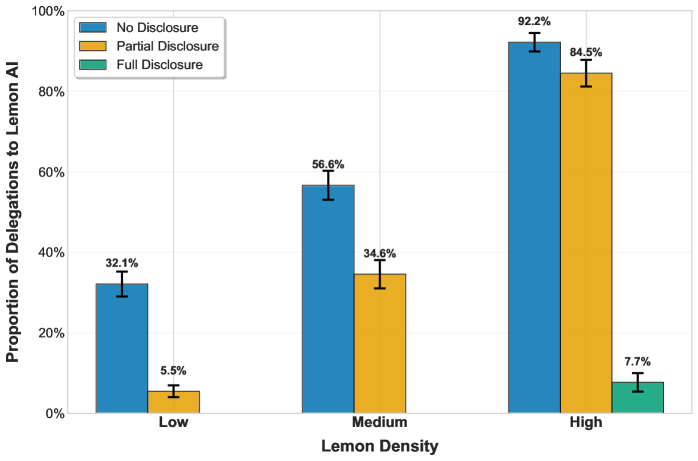

Рыночный контекст существенно влияет на уровень доверия к системам искусственного интеллекта. В сценарии “низкой плотности лимонов” — когда на рынке представлено небольшое количество некачественных систем — пользователи склонны доверять новым AI-решениям и делегировать им задачи. Напротив, в ситуации “высокой плотности лимонов”, характеризующейся большим количеством некачественных систем, доверие к AI снижается, что приводит к нежеланию пользователей полагаться на автоматизированные решения, даже если они потенциально полезны. Это связано с формированием негативного опыта и ожиданием низкой надежности системы в целом.

Результаты исследования показали, что даже при полной прозрачности в отношении качества систем, уровень делегирования задач искусственному интеллекту составляет 57.7% в сценариях с высокой концентрацией некачественных систем (“HighDensityLemons”), что свидетельствует о недостаточной степени доверия и склонности к самостоятельному выполнению задач. В то же время, частичное раскрытие информации о качестве систем привело к увеличению заработанных виртуальных монет в сценариях с низкой и средней концентрацией некачественных систем, что указывает на более эффективное использование ИИ в условиях меньшего риска столкнуться с ошибками.

К устойчивым экосистемам ИИ: путь вперед

Несимметричность информации и необходимость калибровки доверия являются ключевыми факторами для раскрытия полного потенциала искусственного интеллекта. Часто пользователи не обладают достаточными знаниями о принципах работы и ограничениях ИИ-систем, что порождает необоснованные ожидания или, наоборот, излишний скептицизм. Для преодоления этой проблемы необходима прозрачность в отношении данных, используемых для обучения моделей, а также четкое объяснение логики принятия решений. Калибровка доверия подразумевает формирование адекватной оценки возможностей и рисков, связанных с использованием ИИ, что позволит избежать как слепого принятия решений, так и неоправданного отказа от полезных технологий. В конечном итоге, создание среды, в которой пользователи понимают и доверяют ИИ, открывает путь к более широкому внедрению и инновациям в различных сферах жизни.

Для эффективного управления сложными процессами принятия решений, особенно в системах искусственного интеллекта, необходимы стратегии заблаговременного раскрытия информации в сочетании с принципом “Человек в контуре” (HumanInTheLoop). Это означает, что алгоритмы ИИ не должны действовать как “черные ящики”, а должны предоставлять понятные объяснения своих рассуждений и данных, на которых они основаны. Одновременное привлечение экспертов-людей для проверки и корректировки решений ИИ, особенно в критически важных ситуациях, позволяет избежать ошибок и повысить доверие к системе. Такой подход обеспечивает не только техническую точность, но и этическую ответственность, позволяя учитывать нюансы и контекст, которые могут быть упущены машиной, и гарантируя, что конечные решения соответствуют человеческим ценностям и ожиданиям.

Переход к рынку, напоминающему концепцию “LowDensityLemons” — где преобладают качественные и прозрачные продукты, а не скрытые дефекты — представляется ключевым фактором для расширения внедрения искусственного интеллекта и стимулирования инноваций. В отличие от рынка “лимонов”, где недобросовестные продавцы маскируют недостатки, данная модель предполагает открытое предоставление информации о возможностях и ограничениях систем ИИ. Это способствует формированию доверия со стороны пользователей и инвесторов, позволяя им более осознанно оценивать и использовать технологии. Такая прозрачность не только минимизирует риски, связанные с непредсказуемым поведением ИИ, но и создает благоприятную среду для разработки более надежных и эффективных решений, что, в свою очередь, ведет к более широкому распространению и применению искусственного интеллекта в различных сферах жизни.

Для достижения действительно ответственного внедрения искусственного интеллекта необходимы согласованные действия разработчиков, пользователей и представителей власти. Разработчики должны уделять первостепенное внимание прозрачности алгоритмов и безопасности систем, а также активно вовлекать пользователей в процесс тестирования и обратной связи. Пользователи, в свою очередь, должны обладать необходимыми знаниями и инструментами для критической оценки результатов, предоставляемых ИИ, и сообщать о любых выявленных проблемах. Наконец, регулирующие органы призваны создавать четкие и понятные правила, способствующие инновациям, но при этом обеспечивающие защиту прав и интересов граждан. Только при таком комплексном подходе, основанном на сотрудничестве и взаимной ответственности, можно в полной мере реализовать потенциал искусственного интеллекта и избежать нежелательных последствий.

Исследование показывает, что асимметрия информации, подобно туману, искажает восприятие истинных возможностей систем искусственного интеллекта. Авторы демонстрируют, что простое раскрытие информации не гарантирует оптимального делегирования задач, а лишь создает иллюзию контроля. Это напоминает слова Андрея Николаевича Колмогорова: «Вероятность того, что в любой сложной системе произойдет сбой, стремится к единице». Действительно, чем сложнее система, и чем больше в ней скрытых переменных, тем выше вероятность неожиданных последствий. Полное раскрытие возможностей ИИ не устраняет риск принятия неверных решений, а лишь подчеркивает необходимость тщательно продуманных механизмов прозрачности и калибровки доверия, чтобы избежать ситуации, когда рынок превращается в базар «лимонов».

Что дальше?

Настоящее исследование демонстрирует, что асимметрия информации — не просто шум в канале связи, а фундаментальная сила, формирующая судьбу любой системы, особенно тех, что оперируют искусственным интеллектом. Стремление к прозрачности, как ни парадоксально, не гарантирует оптимального делегирования. Полное раскрытие возможностей системы, словно карта местности, может привести к преждевременной эксплуатации, к игнорированию скрытых рисков. Каждая новая архитектура обещает свободу, пока не потребует DevOps-жертвоприношений.

Будущие исследования должны сосредоточиться не на создании идеальной системы раскрытия информации, а на понимании динамики доверия. Важно исследовать, как люди калибруют свое доверие к системам ИИ в условиях неполной информации, и как это доверие влияет на принятие решений. Порядок — просто временный кэш между сбоями, и необходимо научиться жить с этим хаосом, а не пытаться его искоренить.

В конечном счете, проблема заключается не в том, чтобы построить систему, способную предоставить всю информацию, а в том, чтобы создать экосистему, способную адаптироваться к ее недостатку. Системы — это не инструменты, а экосистемы. Их нельзя построить, только вырастить. И, возможно, самое важное — признать, что даже самая прозрачная система всегда будет содержать в себе некую долю «лимонной плотности».

Оригинал статьи: https://arxiv.org/pdf/2601.21650.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- ПРОГНОЗ ДОЛЛАРА К ШЕКЕЛЮ

- БИТКОИН ПРОГНОЗ. BTC криптовалюта

- SOL ПРОГНОЗ. SOL криптовалюта

- ЭФИРИУМ ПРОГНОЗ. ETH криптовалюта

- SAROS ПРОГНОЗ. SAROS криптовалюта

- ПРОГНОЗ ДОЛЛАРА К ЗЛОТОМУ

- AXS ПРОГНОЗ. AXS криптовалюта

- FARTCOIN ПРОГНОЗ. FARTCOIN криптовалюта

- ДОГЕКОИН ПРОГНОЗ. DOGE криптовалюта

- РИППЛ ПРОГНОЗ. XRP криптовалюта

2026-01-30 19:38